一文详解Swin Transformer的现状、优势和未来方向!

介绍

深度学习的出现预示着计算机视觉领域进入了一个新时代,卷积神经网络(CNN)在相当长的一段时间内占据了主导地位。然而,最近将变换器模型引入视觉领域引发了重大转变, Transformer模型主要因其在自然语言处理(NLP)领域的成功而闻名。在将 Transformer用于图像分析的各种尝试中,Swin Transformer作为一种特别创新的方法脱颖而出。本文将深入探讨 Swin Transformer,探索其架构、优势、应用及其在塑造视觉表征学习未来方面的作用。

Swin Transformer简介

Swin Transformer由微软公司的研究人员推出,是一种有效结合了 CNN 和 Transformer模型优势的新型架构。它旨在以类似 CNN 的分层方式处理图像,同时利用变换器固有的自我关注机制。这种混合方法使 Swin 变换器能够有效处理各种规模的视觉信息,从而使其在广泛的视觉任务中具有高度的通用性和强大的功能。

架构创新

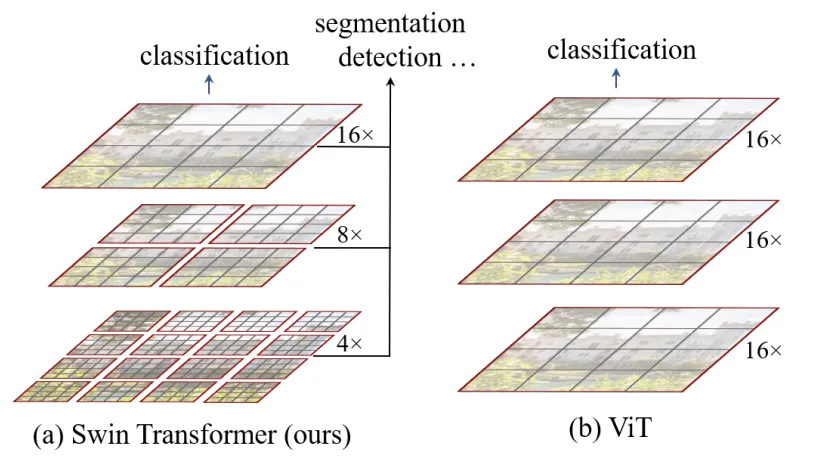

Swin Transformer 的核心创新在于其分层结构和基于移位窗口的自我关注的使用。标准视觉转换器(ViT)在整个图像中全面应用自我注意,而 Swin Transformer则不同,它将图像划分为更小、不重叠的窗口。在这些窗口内计算自我注意力,从而大大降低了与注意力机制的二次性质相关的计算复杂性。此外,为了增强模型捕捉图像不同部分之间关系的能力,Swin Transformer采用了一种新颖的技术,即在连续的Transformer块之间移动窗口分割。这种移动确保了在上一层中单独处理的图像区域能够在下一层中相互影响,从而促进了局部和全局上下文信息的更好整合。

与传统方法相比的优势

Swin Transformer解决了以往基于 CNN 和 Transformer的模型的几个局限性。首先,它的分层设计可以高效处理多种分辨率的图像,有助于完成需要同时了解精细细节和整体结构的任务,如物体检测和语义分割。其次,通过将自我关注机制定位到窗口并采用移位窗口,Swin Transformer 大幅降低了计算要求,使其更易于扩展到大型图像和数据集。最后,它的架构通过将局部特征无缝集成到更广泛的上下文中,实现了更好的特征学习,从而提高了各种视觉任务的性能。

应用与性能

Swin Transformer 的多功能性和高效性使其被广泛应用,从基本的图像分类到更复杂的任务,如物体检测、语义分割,甚至三维场景理解。在基准测试中,与传统 CNN 和其他基于Transformer的模型相比,Swin Transformer始终表现出卓越的性能,在 ImageNet、COCO 和 ADE20K 等著名数据集上取得了最先进的结果。

未来方向与结论

Swin Transformer 的成功凸显了将自我注意机制与分层、类似 CNN 的视觉表征学习结构相结合的潜力。它能够高效处理多种尺度的视觉信息,同时降低了计算需求,为研究和应用开辟了新的途径。未来的工作可能会探索进一步优化、适应不同领域(如视频处理或医学图像分析)以及与其他深度学习创新的整合。

代码

针对特定任务从头开始实施一个完整的 Swin Transformer 模型,以及生成合成数据集、训练模型、评估指标和绘制结果,涉及多个详细步骤。下面,我将概述一个全面的指南,其中包括:

- 创建用于图像分类的合成数据集。

- 构建简化版的 Swin Transformer 架构。

- 在合成数据集上训练模型。

- 以准确率为指标对模型进行评估。

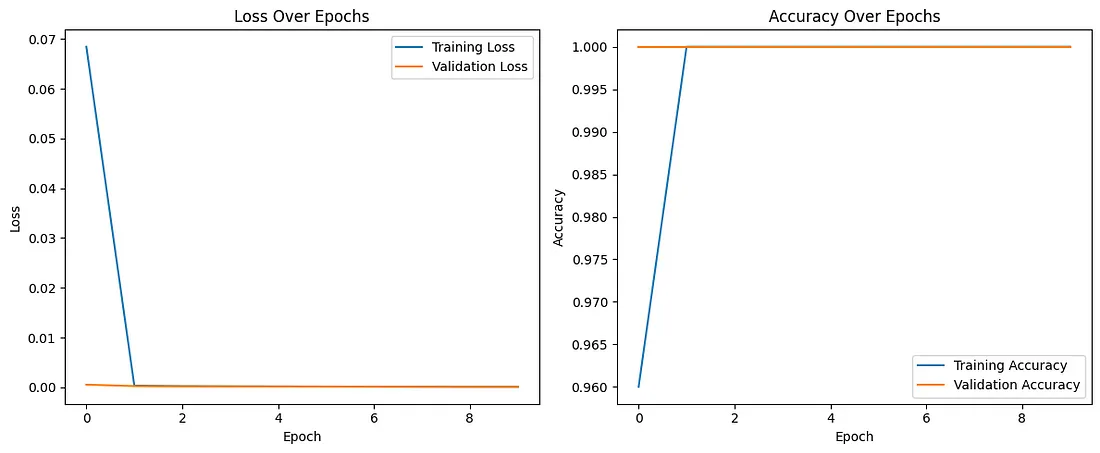

- 绘制训练损失和准确率的历时图。

在本例中,我们将使用合成数据集来完成简单的图像分类任务。鉴于 Swin Transformer的复杂性,从头开始实现一个完整的版本是相当困难的。因此,我们将专注于一个简化的模型来演示核心概念。要实现完整的全功能,建议使用 Hugging Face's Transformers 或 Timm 等库,其中包含预训练的 Swin Transformer 模型。

第1步:创建合成数据集

我们将使用统一背景上的简单形状(圆形、方形)生成一个合成数据集。每张图片都将根据其包含的形状进行标注。

第2步:简化 Swin Transformer架构

我们将概述 Swin Transformer模块的简化版本。

第3步:训练模型

我们将设置一个训练循环,在合成数据集上训练模型,使用适合分类的通用优化器和损失函数。

第4步:评估模型

我们将计算模型在验证集上的准确率,以评估其性能。

第5步:绘制结果图

最后,我们将绘制随时间变化的训练损失和准确率图,以直观展示学习过程。

让我们先生成一个合成数据集。由于复杂性以及空间和处理能力的限制,下面的 Python 代码只是一个简化的示例,在实际场景中运行时可能需要进行调整。

import numpy as np

import cv2

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

from tensorflow.keras.utils import to_categorical

from tensorflow.keras import layers, models

import tensorflow as tf

# Generate synthetic data

def generate_synthetic_data(num_samples=1000, img_size=32):

X = np.zeros((num_samples, img_size, img_size, 3), dtype=np.float32)

y = np.zeros((num_samples,), dtype=np.int32)

for i in range(num_samples):

shape_type = np.random.randint(0, 2) # 0 for circle, 1 for square

y[i] = shape_type

if shape_type == 0: # Draw circle

cv2.circle(X[i], (img_size//2, img_size//2), img_size//4, (255, 0, 0), -1)

else: # Draw square

cv2.rectangle(X[i], (img_size//4, img_size//4), (3*img_size//4, 3*img_size//4), (0, 0, 255), -1)

X /= 255.0 # Normalize

return X, y

# Create synthetic dataset

X, y = generate_synthetic_data()

y = to_categorical(y, num_classes=2) # One-hot encode labels

# Split dataset into training and validation

X_train, X_val, y_train, y_val = train_test_split(X, y, test_size=0.2, random_state=42)

# Simplified Swin Transformer model (placeholder)

def build_simplified_swin_transformer(input_shape=(32, 32, 3), num_classes=2):

inputs = layers.Input(shape=input_shape)

# This is a placeholder for the actual Swin Transformer layers

x = layers.Flatten()(inputs)

x = layers.Dense(64, activation='relu')(x)

outputs = layers.Dense(num_classes, activation='softmax')(x)

model = models.Model(inputs, outputs)

return model

# Compile model

model = build_simplified_swin_transformer()

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# Train model

history = model.fit(X_train, y_train, epochs=10, validation_data=(X_val, y_val))

# Plot training history

plt.figure(figsize=(12, 5))

plt.subplot(1, 2, 1)

plt.plot(history.history['loss'], label='Training Loss')

plt.plot(history.history['val_loss'], label='Validation Loss')

plt.title('Loss Over Epochs')

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.legend()

plt.subplot(1, 2, 2)

plt.plot(history.history['accuracy'], label='Training Accuracy')

plt.plot(history.history['val_accuracy'], label='Validation Accuracy')

plt.title('Accuracy Over Epochs')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.legend()

plt.tight_layout()

plt.show()

要完整、详细地实现 Swin Transformer,包括其所有错综复杂的功能(如移位窗口机制),建议参考官方资源库或深度学习库中已有的实现。这些资源将提供经过优化、随时可用的 Swin 变换器版本,可用于此处讨论的简化示例之外的各种任务。

结论

总之,Swin Transformer 是计算机视觉深度学习架构发展过程中的一个重要里程碑。通过弥合 CNN 的效率和Transformer模型的有效性之间的差距,它不仅推动了视觉表征学习的最新发展,还为该领域的未来研究指明了新方向。随着我们不断探索深度学习所能达到的极限,像 Swin Transformer这样的架构无疑将在释放新功能和应用方面发挥关键作用。