谷歌音乐AI工具MusicRL:使音乐生成符合人类偏好

什么是 MusicLM?

MusicLM是谷歌的旗舰级文本转音乐人工智能,最初发布于2023年初。即使是基本版本,它也代表了一项重大突破,令音乐行业大吃一惊。不过,几周前,MusicLM 进行了重大更新。下面是两个选定提示的并排对比:

提示: "带有旋律合成器线条和琶音的舞曲":

- 旧音乐LM: https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musiclm-7.wav

- 新音乐LM: https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musicrlhf-ru-7.wav

提示: "手风琴乐队演奏的怀旧乐曲

- 旧 MusicLM: https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musiclm-27.wav

- 新音乐LM: https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musicrlhf-ru-27.wav

音乐质量的提高可归功于谷歌研究院发表的一篇题为 "MusicRL: 将音乐生成与人类偏好相匹配"。显然,这次升级被认为意义重大,因此他们决定重新命名该模型。不过,在关键架构下,MusicRL 与 MusicLM 是完全相同的。唯一的区别是:微调。

什么是微调?

当从零开始建立一个人工智能模型时,它从零知识开始,基本上是随机猜测。然后,模型通过对数据的训练提取有用的模式,并随着训练的进行开始表现出越来越智能的行为。这种方法的一个缺点是,从头开始训练需要大量数据。微调是指在使用现有模型的基础上,对其进行调整以适应新的任务,或对同一任务进行不同的调整。由于模型已经掌握了最重要的模式,因此所需的数据要少得多。

例如,像 Mistral7B 这样强大的开源 LLM,原则上任何人都可以从头开始训练。但是,要想获得有用的输出结果,所需的数据量是巨大的。相反,公司会使用现有的 Mistral7B 模型,向其输入少量专有数据,使其能够解决新任务,无论是编写 SQL 查询还是对电子邮件进行分类。

关键的一点是,微调并不会改变模型的基本结构。它只是对内部逻辑稍作调整,以便在特定任务中执行得更好。现在,让我们利用这些知识来了解谷歌是如何根据用户数据对 MusicLM 进行微调的。

谷歌如何收集用户数据

在 MusicLM 论文发表几个月后,谷歌发布了一个公开演示,作为谷歌人工智能测试的一部分。在那里,用户可以免费试用文本到音乐模型。不过,你可能知道这样一句话: 如果产品是免费的,那么你就是产品。谷歌也不例外。在使用 MusicLM 的公开演示时,你偶尔会遇到两个生成的输出结果,并被要求说明你更喜欢哪一个。通过这种方法,谷歌在几个月内收集到了 30 万用户的喜好。

从截图中可以看出,用户并没有被明确告知他们的偏好将被用于机器学习。虽然这可能会让人觉得不公平,但必须指出的是,我们在互联网上的许多行为都被用于机器学习训练,无论是谷歌搜索历史、Instagram 点赞还是 Spotify 私人播放列表。与这些相当私人和敏感的情况相比,MusicLM 游戏场上的音乐偏好似乎可以忽略不计。

Linkedin 协作文章上的用户数据收集示例

我们应该意识到,用于机器学习的用户数据收集工作一直在进行,而且通常未经用户明确同意。如果你在 Linkedin 上,你可能会被邀请为所谓的 "协作文章 "投稿。从本质上讲,用户受邀就其专业领域的问题提供建议。

谷歌如何利用这些用户数据

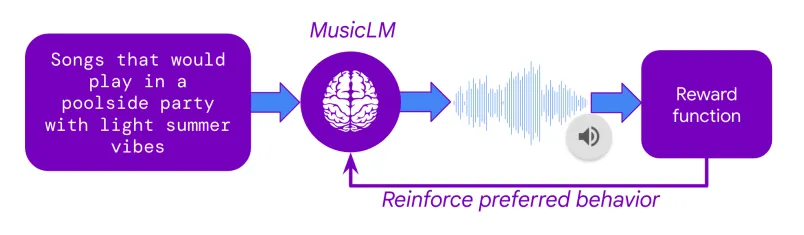

接下来的问题是,谷歌是如何利用这些大量的用户偏好数据对 MusicLM 进行微调的。其中的奥秘在于一种名为 "人类反馈强化学习"(RLHF)的技术,这也是 ChatGPT 在 2022 年取得的重要突破之一。在 RLHF 中,人类的偏好被用来训练一个人工智能模型,该模型会学习模仿人类的偏好决定,从而产生一个人工评分器。一旦这个所谓的奖励模型训练完成,它就能接收任意两首曲目,并预测哪一首曲目最有可能受到人类评分者的青睐。

有了奖励模型,就可以对 MusicLM 进行微调,以最大限度地提高用户对其输出结果的预测偏好。这意味着文本到音乐模型生成了成千上万首曲目,每首曲目都会得到奖励模型的评分。通过反复调整模型权重,MusicLM 学会了生成人工评分者 "喜欢 "的音乐。

除了对用户偏好进行微调外,MusicLM 还根据另外两个标准进行了微调:

1. Prompt Adherence

谷歌专有的文本到音频嵌入模型 MuLan 用于计算用户提示和生成音频之间的相似度。在微调过程中,这一一致性得分被最大化。

2. 音频质量

谷歌在用户数据上训练了另一个奖励模型,以评估其生成输出的主观音频质量。这些用户数据似乎是在单独的调查中收集的,而不是在 MusicLM 的公开演示中。

新版 MusicLM 究竟好在哪里?

请听演示页面上提供的样本。当然,选定的公开演示可能会有欺骗性,因为作者有动力展示能让他们的新模型看起来尽可能好的例子。希望我们很快就能在公共游乐场测试 MusicRL。

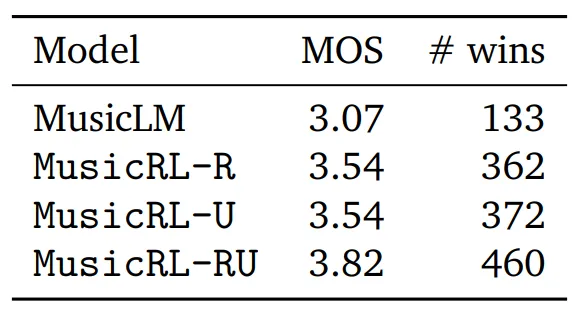

不过,论文也对主观质量进行了量化评估。为此,谷歌进行了一项研究,要求用户比较为同一提示生成的两首曲子,给每首曲子打 1 到 5 分。利用这个名字听起来很花哨的平均意见分(MOS)指标,我们不仅可以比较每个模型的直接比较获胜次数,还可以计算出评分者的平均得分(MOS)。

在这里,MusicLM 代表最初的 MusicLM 模型。MusicRL-R仅针对音频质量和及时性进行了微调。MusicRL-U 仅针对人类反馈(奖励模型)进行了微调。最后,MusicRL-RU 对所有三个目标都进行了微调。不出所料,MusicRL-RU 在直接比较和平均评分方面都优于所有其他模型。

论文还指出,经过全面微调的 MusicRL-RU 模型在 87% 的直接比较中击败了 MusicLM。通过分析 MusicRL-R 和 MusicRL-RU 之间的直接比较,可以看出 RLHF 的重要性。在这里,后者的胜率为 66%,可靠地超越了竞争对手。

总而言之,谷歌通过利用从 ChatGPT 借用的经过验证的微调方法,使自己在竞争中处于领先地位。虽然即使有了 RLHF,新的 MusicLM 仍然没有达到人类水平的质量,但谷歌现在可以维护和更新其奖励模型,通过相同的微调程序改进未来几代的文本到音乐模型。