【深度学习】CPU与GPU性能的比较分析

简介

深度学习是机器学习的一个子集,近年来取得了突飞猛进的发展,这主要归功于图形处理器(GPU)和中央处理器(CPU)所提供的计算能力。了解 CPU 和 GPU 在深度学习中的使用差异对于优化计算效率、成本和性能至关重要。本文将探讨 CPU 和 GPU 在架构上的差异、它们对深度学习过程的影响,以及在哪些情况下,CPU 和 GPU 孰优孰劣。

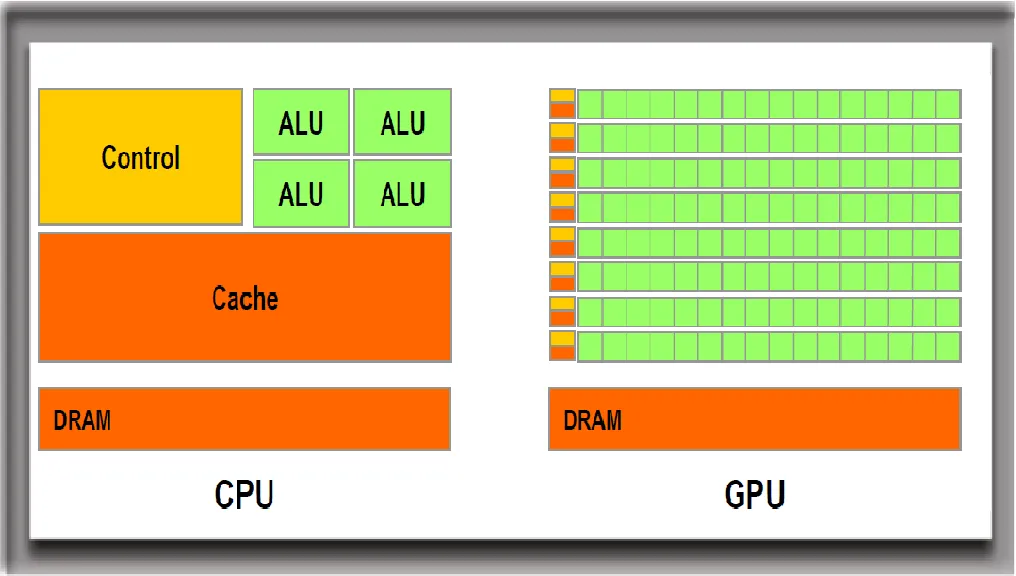

架构差异

CPU 和 GPU 的根本区别在于它们的架构和设计理念。CPU 设计用于处理各种计算任务,并针对顺序处理进行了优化。典型的 CPU 有几个内核和大量高速缓冲存储器,可以同时处理几个软件线程。相比之下,GPU 专为并行处理而设计,配备了数千个较小的内核,可以协同工作,同时执行多个操作。这使得 GPU 特别适合深度学习中常见的矩阵和矢量操作。

对深度学习的影响

深度学习涉及使用海量数据训练神经网络,这一过程需要巨大的计算能力。GPU 的并行处理能力可以高效地处理这些大规模计算,大大缩短训练模型所需的时间。

- 训练速度:与 CPU 相比,GPU 可以大大加快训练时间。这是因为 GPU 的架构允许它们并行执行数千次操作,从而将训练复杂模型的时间从数周缩短到数天甚至数小时。

- 批量处理: 深度学习模型通常会批量处理数据,以优化学习效果。GPU 在这方面表现出色,因为它们可以同时对多个数据点进行并行计算,而 CPU 会按顺序处理每个点。

- 成本效益: 虽然 GPU 为深度学习任务提供了卓越的性能,但其初始成本也比 CPU 高。不过,在训练模型时节省下来的时间往往可以证明这笔费用是合理的,尤其是在时间是关键因素的商业和研究环境中。

CPU 与 GPU: 选择正确的工具

在深度学习任务中选择使用 CPU 还是 GPU 取决于多个因素,包括数据集的大小、模型的复杂性和预算限制。

- 小型数据集和简单模型: 对于较小的数据集或不太复杂的模型,CPU 可能就足够了。在这种情况下,将数据传输到 GPU 和从 GPU 传输数据的开销可能不足以证明处理速度的提升是合理的。

- 大型数据集和复杂模型: 对于在大型数据集上训练深度神经网络,GPU 通常是首选。GPU 能够并行处理许多操作,因此速度明显快于 CPU。

- 预算和可访问性: 预算限制和可访问性也会影响选择。GPU 性能优越,但价格昂贵。基于云的解决方案可以通过按使用付费的方式访问 GPU 资源来缓解这一问题,从而让更多的人可以使用深度学习。

未来发展方向

CPU 和 GPU 技术的不断发展将继续推动深度学习的发展。新的 GPU 模型正在开发中,它们具有更多的内核和专门用于深度学习任务的功能,例如英伟达公司 Volta 和图灵架构中的张量内核。同样,针对深度学习优化 CPU 架构的研发工作也在持续进行,包括使用专用指令集和改进并行性。

代码

要执行一项深度学习任务来展示 CPU 和 GPU 处理性能的差异,需要一种实用的方法。我们将使用一个合成数据集模拟一个简单的深度学习任务,测量 CPU 和 GPU 的执行时间,并将性能指标可视化。本示例将使用 TensorFlow,这是一个同时支持 CPU 和 GPU 操作的流行深度学习库。

前提条件

确保你的环境中已安装 TensorFlow。如果 GPU 可用,TensorFlow 将自动使用 GPU,但你可以在代码中显式控制设备位置。请注意,在 GPU 上运行 TensorFlow 时,如果使用英伟达™(NVIDIA®)GPU,则需要安装相应的 CUDA 和 cuDNN 驱动程序。

第 1 步:创建合成数据集

我们将使用 scikit-learn 的数据集生成工具生成一个适合分类任务的合成数据集。

第 2 步:定义简单的深度学习模型

我们将使用 TensorFlow/Keras 定义一个简单的神经网络。该模型将在我们的合成数据集上进行训练。

第 3 步:在 CPU 和 GPU 上训练模型

我们将分别在 CPU 和 GPU 上训练模型,测量每种情况下训练所需的时间。这需要明确设置 TensorFlow 的设备上下文。

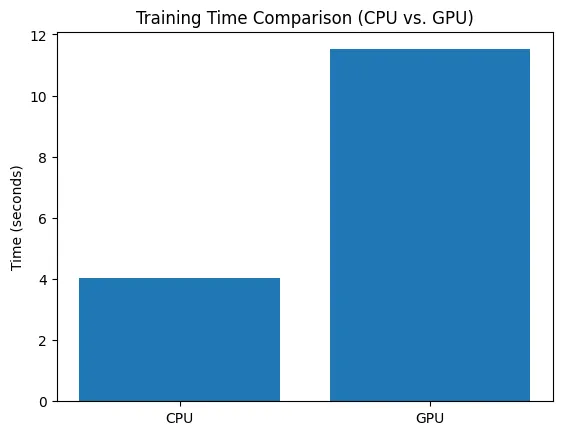

第 4 步:比较性能

我们将绘制 CPU 与 GPU 的训练时间对比图,以便对性能差异进行清晰直观的比较。

让我们开始编码:

import time

import numpy as np

import tensorflow as tf

from sklearn.datasets import make_classification

import matplotlib.pyplot as plt

# Step 1: Create a Synthetic Dataset

X, y = make_classification(n_samples=10000, n_features=20, n_classes=2, random_state=42)

# Step 2: Define a Simple Deep Learning Model

def create_model():

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(64, activation='relu', input_shape=(20,)),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(1, activation='sigmoid')

])

model.compile(optimizer='adam',

loss='binary_crossentropy',

metrics=['accuracy'])

return model

# Function to train model on a specific device

def train_on_device(device_name, X, y, epochs=10):

with tf.device(device_name):

model = create_model()

start_time = time.time()

model.fit(X, y, epochs=epochs, batch_size=256, verbose=0)

end_time = time.time()

training_time = end_time - start_time

return training_time

# Step 3: Train the Model on CPU and GPU

cpu_time = train_on_device('/cpu:0', X, y)

gpu_time = train_on_device('/gpu:0', X, y) if tf.test.is_gpu_available() else None

# Step 4: Compare Performance

plt.bar(['CPU', 'GPU'], [cpu_time, gpu_time if gpu_time is not None else 0])

plt.title('Training Time Comparison (CPU vs. GPU)')

plt.ylabel('Time (seconds)')

plt.show()

# Display the training times

print(f"Training time on CPU: {cpu_time:.2f} seconds")

if gpu_time is not None:

print(f"Training time on GPU: {gpu_time:.2f} seconds")

else:

print("GPU is not available.")

Training time on CPU: 4.02 seconds

Training time on GPU: 11.51 seconds

请注意,使用 GPU 的实际性能增益取决于多个因素,包括模型的复杂性、数据集的大小以及所使用的特定 CPU 和 GPU 硬件。此外,如果你的环境中没有可用的 GPU,将无法测量 GPU 训练时间,你将看到一条提示 GPU 不可用的信息。

结论

选择使用 CPU 还是 GPU 来完成深度学习任务受项目具体要求的影响,包括模型的复杂性、数据集的大小和预算因素。虽然 GPU 因其并行处理能力通常能为大多数深度学习任务提供更优越的性能,但 CPU 可能仍然适用于较小规模的项目。随着这两种技术的不断发展,它们之间的差距可能会缩小,从而为深度学习从业者提供更多的灵活性和选择。