微软Orca AI团队发布新型数学大语言模型Orca-Math

昨天,微软研究院的高级研究员Arindam Mitra领导的Orca AI团队,在X上公布了一则重大进展,即推出了一款新型的大语言模型——Orca-Math。这款模型是法国初创公司Mistral的Mistral 7B模型的一个新变体,其特点是在“数学文字问题”上表现出色,同时保持了较小的训练和推理规模。这是微软Orca团队致力于提升小型大语言模型(LLM)能力的一部分。

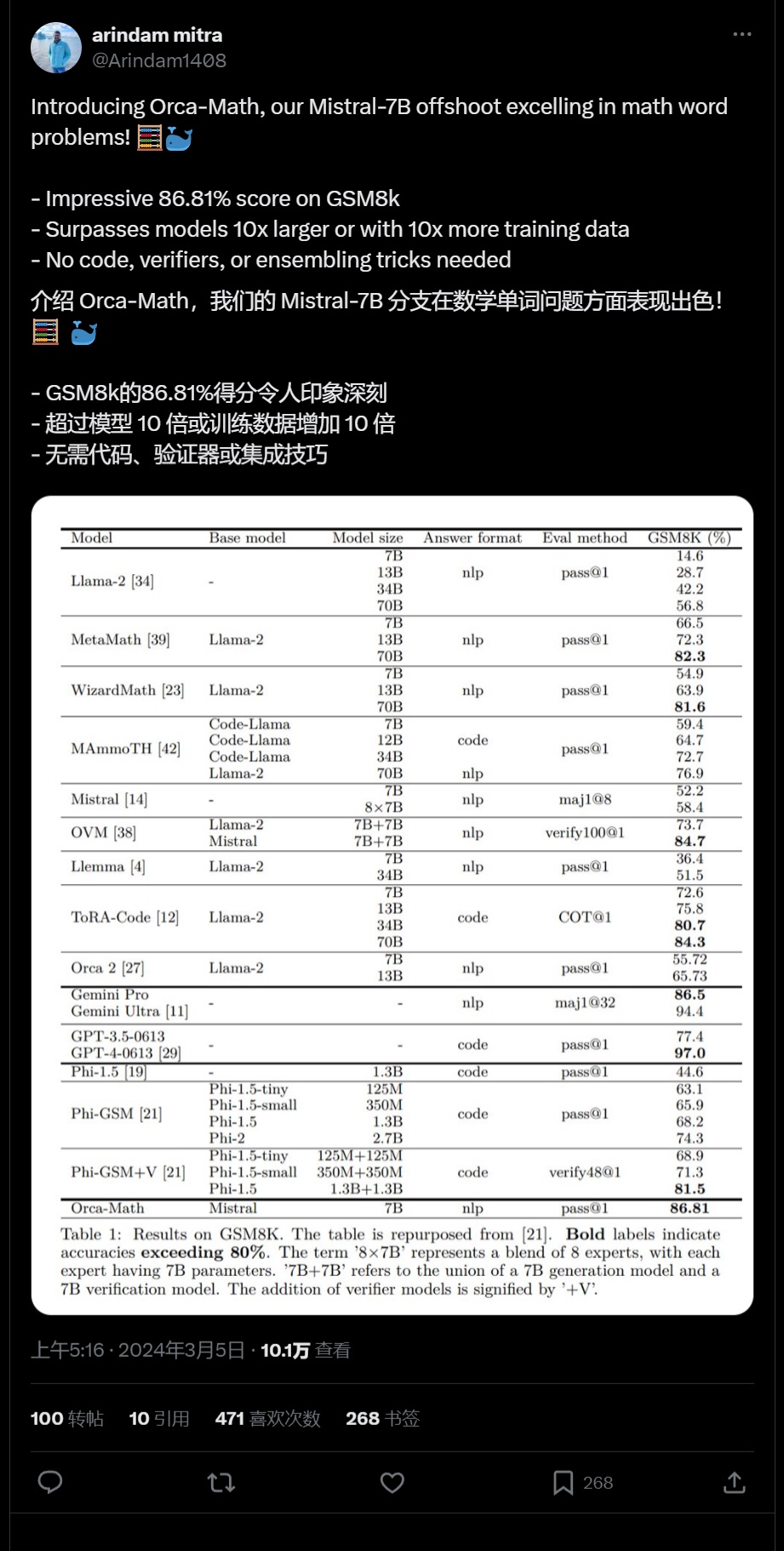

Orca Math的性能表现尤为亮眼,他们在小规模上达到了新的性能高度,甚至在某种程度上超越了参数数量是其10倍的模型。Mitra团队分享了一张图表,显示Orca Math在GSM8K基准测试上的表现超越了其他大多数7-70亿参数大小的人工智能LLM和变体,包括MetaMath(70B)和Llemma(34B),仅次于谷歌的Gemini Ultra和OpenAI的GPT-4。GSM8K是一个由OpenAI发布的包含8500个不同数学文字问题和问题的系列,每个问题需要2-8步解决,且由人类作家设计,适合中学生级别(最高到八年级)解答。

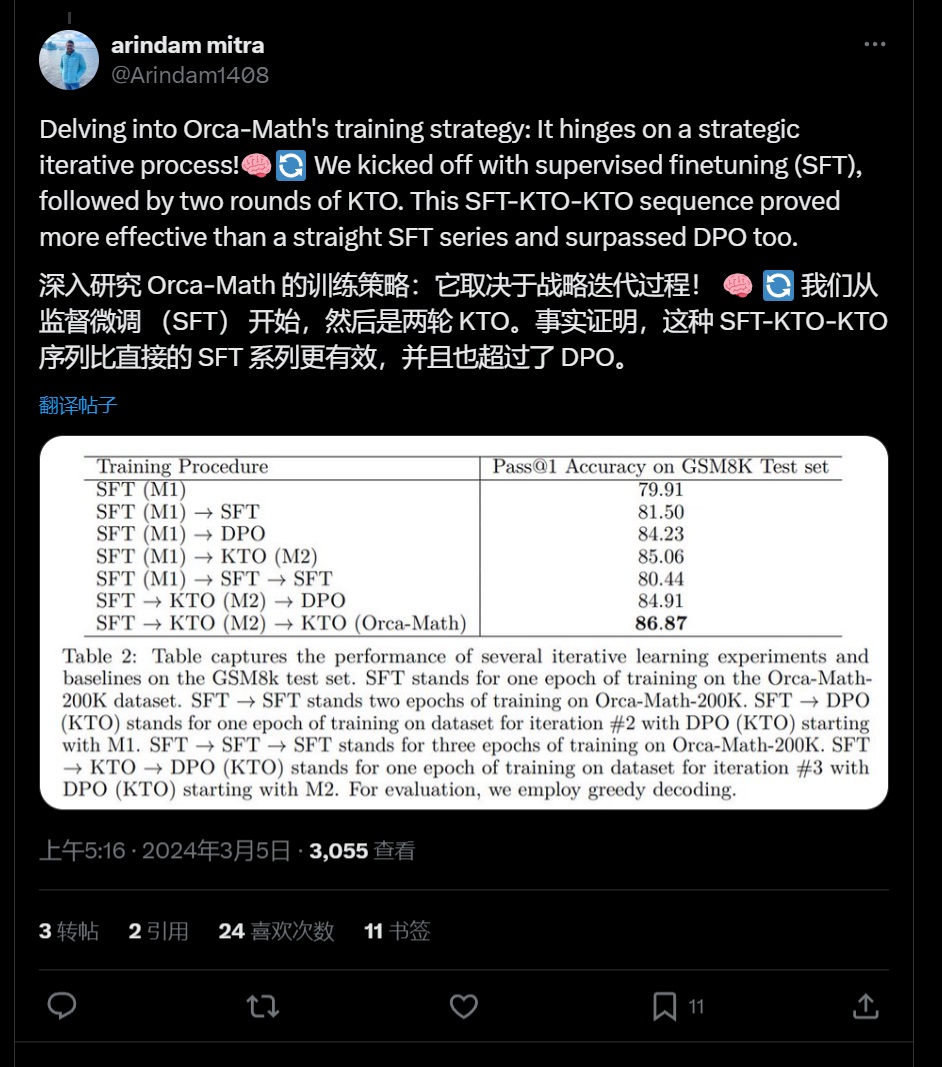

这一成果的取得归功于Orca团队的创新方法。Mitra透露,他们生成了一个包含20万个数学文字问题的新列表,这些问题由“专业的代理合作”完成,包括学生AI代理和教师AI代理,后者负责纠正答案。这些问题是通过收集36217个来自现有开源数据集的数学文字问题样本,然后向OpenAI的GPT-4寻求答案,再用这些答案来训练新的Mistral 7B变体,最终形成了Orca-Math。

此外,Orca团队还引入了一个“建议者和编辑者”代理,用于开发更复杂的问题以训练AI。这一创新方法使得Orca-Math在保持较小规模的同时,实现了与更大模型相当的性能。

值得注意的是,微软Orca团队还将他们合成的、由AI生成的20万个数学文字问题集发布在Hugging Face上,并采用了宽松的MIT许可证,允许任何人探索、构建和创新,甚至用于商业用途。这一举措将促进初创公司和企业对这一数据集的利用,推动人工智能领域的发展。

自2023年6月微软发布最初的Orca 13B以来,该团队一直致力于提升模型的能力。随后的Orca 2的13B和7B版本于2023年11月发布,均基于Meta的开源Llama 2 LLM。可以预见,随着技术的不断进步,Orca家族将继续壮大,并为我们带来更多惊喜。