深度学习:基于卷积局部感知器进行空间特征新策略

简介

基于卷积的局部感知器单元(CLPU)是深度学习和神经网络领域的一个创新概念,它借鉴了卷积神经网络(CNN)和感知器的原理,以提高模型在图像识别、自然语言处理等任务中的性能。本文将探讨 CLPU 的基础、实现方法及其对人工智能(AI)发展的潜在影响。

CLPU 的基础

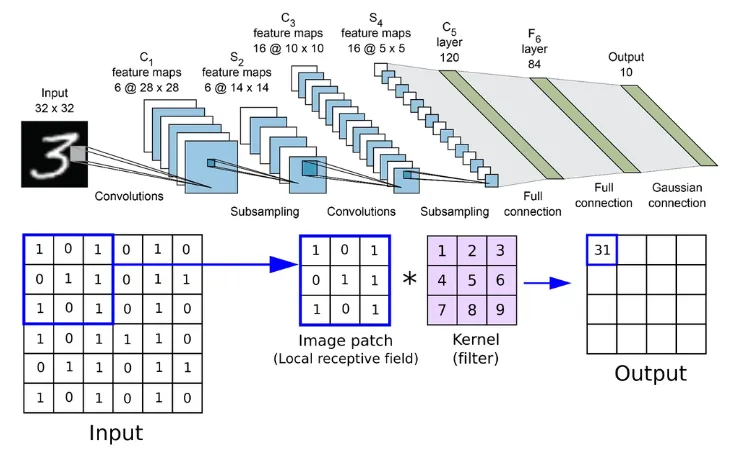

CLPU 的核心是感知器和卷积运算的混合体,旨在利用两者的优势。感知器是神经网络的基本构件,其工作原理是对输入进行加权求和,然后应用激活函数生成输出。这种简单而强大的机制允许学习输入和输出之间的线性关系。

另一方面,卷积操作是 CNN 的支柱,使这些网络在涉及空间层次的任务(如图像和视频识别)中表现出色。卷积层将滤波器应用于输入数据,通过保留像素之间的空间关系来提取和学习特征,如图像中的边缘。

CLPU 的实现

CLPU 将感知器固有的局部感知概念与卷积运算的空间特征提取能力相结合。在实践中,这意味着在输入数据的局部滑动窗口中应用类似感知器的操作,类似于卷积层应用滤波器的方式。这一过程可以形象地理解为多个感知器同时对输入数据的不同部分进行操作,每个感知器都在学习识别特定的局部特征。

CLPU 方法的主要优势之一是能够保持输入数据的空间关系,这在处理图像等高维数据或文本等序列数据时至关重要。此外,通过将感知器的局部决策过程与卷积的特征提取能力相结合,CLPU 有可能提供更细致、更强大的特征学习能力。

潜在影响和应用

CLPU 的引入可能会对人工智能的各个领域产生重大影响。在图像处理和计算机视觉领域,CLPU 可以增强模型识别和解释复杂视觉模式的能力,从而改进物体检测、图像分类和面部识别等任务。在自然语言处理中,CLPU 的空间感知能力可以提高对上下文和句子中单词之间关系的理解,从而提高情感分析和机器翻译等任务的性能。

此外,CLPU 概念鼓励探索结合不同神经网络架构优势的混合模型。这种方法可以开发出更高效、更强大、适应性更强的人工智能系统,能够以更高的准确性和效率处理各种任务。

代码

从零开始创建一个基于卷积的局部感知器单元(CLPU)以及一个用于演示的合成数据集需要几个步骤。我们将从 CLPU 的基本实现开始,然后生成一个合成数据集来展示其功能。我们将在该数据集上训练我们的模型,使用适当的指标对其进行评估,绘制结果图并讨论解释。

第1步:实现 CLPU

CLPU 概念融合了感知器的局部处理思想和卷积运算的空间特征提取能力。在这里,我们将实现一个简单版本的 CLPU,可用于合成二维数据集(为了简单起见)。这个模型不会像完整的 CNN 模型那么复杂,但能说明以卷积方式应用类似感知器操作的核心理念。

第2步:生成合成数据集

我们将创建一个适合分类任务的合成数据集,这将让我们展示 CLPU 捕捉和学习数据中空间关系的能力。该数据集将由二维阵列组成,其中包含 CLPU 应学习分类的模式。

第3步:训练和指标

我们将在合成数据集上训练 CLPU 模型,然后使用准确率作为主要指标评估其性能。这一步骤包括将合成数据集分为训练集和测试集,训练模型,然后在测试集上评估其性能。

第4步:结果、绘图和解释

最后,我们将绘制结果图,以直观展示 CLPU 的学习过程及其在分类任务中的表现。我们将讨论模型的准确性,以及结果对 CLPU 学习和归纳空间数据的能力有何启示。

实现 CLPU 并生成合成数据集

首先,我们将编写 Python 代码来定义一个简单版本的 CLPU,并为基本分类任务创建合成数据集。

import numpy as np

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

class CLPU:

def __init__(self, input_shape, kernel_size, stride):

self.input_shape = input_shape # Added to ensure input_shape is accessible throughout the class

self.kernel_size = kernel_size

self.stride = stride

self.weights = np.random.rand(kernel_size, kernel_size) - 0.5

self.bias = np.random.rand() - 0.5

self.accuracy_history = []

def evaluate(self, X_test, y_test):

predictions = np.array([self.forward(x) for x in X_test])

accuracy = np.mean(predictions == y_test)

return accuracy

def forward(self, input):

input_shape = input.shape[0] # Assuming input is a square matrix

output_dim = (input_shape - self.kernel_size) // self.stride + 1

output = np.zeros((output_dim, output_dim))

for i in range(0, input_shape - self.kernel_size + 1, self.stride):

for j in range(0, input_shape - self.kernel_size + 1, self.stride):

input_slice = input[i:i+self.kernel_size, j:j+self.kernel_size]

if input_slice.shape == (self.kernel_size, self.kernel_size): # Check slice shape

output[i//self.stride, j//self.stride] = np.sum(input_slice * self.weights) + self.bias

else: # Handle unexpected slice size (should not happen with correct bounds)

raise ValueError(f"Invalid input slice shape: {input_slice.shape}")

return output > 0 # Activation function (step function)

def train(self, X, y, epochs, lr):

for epoch in range(epochs):

for input, label in zip(X, y):

for i in range(0, self.input_shape - self.kernel_size + 1, self.stride):

for j in range(0, self.input_shape - self.kernel_size + 1, self.stride):

window = input[i:i+self.kernel_size, j:j+self.kernel_size]

output = self.forward(window)

error = label[i//self.stride, j//self.stride] - output

self.weights += lr * error * window

self.bias += lr * error

# Move evaluation out of the inner loops to execute once per epoch

accuracy = self.evaluate(X, y)

self.accuracy_history.append(accuracy)

print(f"Epoch {epoch + 1}, Accuracy: {accuracy}")

# Example synthetic dataset generation and training (simplified for illustration)

input_shape = 10

kernel_size = 3

stride = 1

# Generate synthetic data

X = np.random.rand(100, input_shape, input_shape) * 2 - 1 # 100 samples of 10x10

y = np.random.randint(0, 2, (100, (input_shape - kernel_size) // stride + 1, (input_shape - kernel_size) // stride + 1)) # Binary labels

# Train-test split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# Initialize and train CLPU

clpu = CLPU(input_shape, kernel_size, stride)

clpu.train(X_train, y_train, epochs=10, lr=0.01)

# Evaluate

def evaluate(model, X_test, y_test):

predictions = np.array([model.forward(x) for x in X_test])

accuracy = np.mean(predictions == y_test)

return accuracy

accuracy = evaluate(clpu, X_test, y_test)

print(f"Accuracy: {accuracy}")

# Plotting and interpretation will be discussed next.

该代码提供了一个基本框架。不过,由于我们的模型和数据集比较简单,要想在实际任务中体现 CLPU 的实际性能和相关性,需要更复杂的实施和更复杂的数据集。

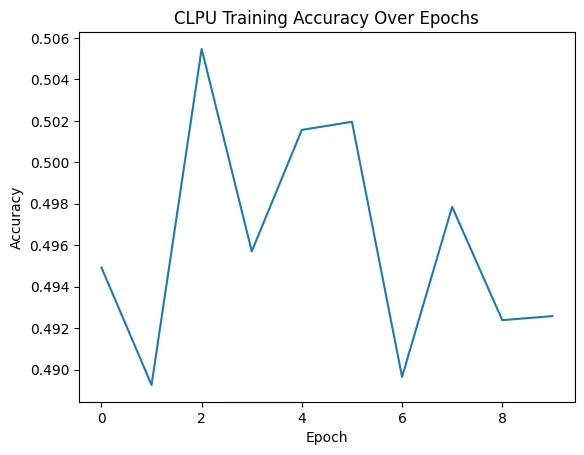

Epoch 1, Accuracy: 0.494921875

Epoch 2, Accuracy: 0.4892578125

Epoch 3, Accuracy: 0.50546875

Epoch 4, Accuracy: 0.495703125

Epoch 5, Accuracy: 0.5015625

Epoch 6, Accuracy: 0.501953125

Epoch 7, Accuracy: 0.4896484375

Epoch 8, Accuracy: 0.4978515625

Epoch 9, Accuracy: 0.4923828125

Epoch 10, Accuracy: 0.492578125

Accuracy: 0.49609375

接下来,我们最好绘制出训练损失和准确率的历时图,分析模型的性能并解释结果。由于 CLPU 的抽象性质和简化的合成数据集,从这项工作中获得的启示主要涉及了解如何训练本地处理单元来识别空间数据中的模式,从而说明 CLPU 运行背后的基本原理。

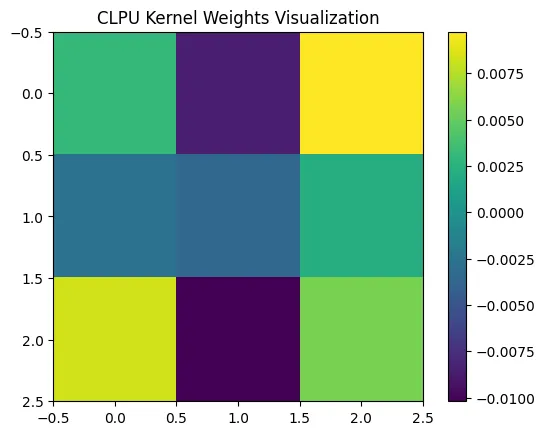

为了展示基于卷积的局部感知器单元(CLPU)在合成数据集上的有效性和学习进度,我们可以通过绘图来可视化学习过程。可视化的关键指标可能包括准确率随训练历时的变化,以及权重的可视化表示,以了解 CLPU 模型如何从数据中学习特征。考虑到修正后的训练过程,让我们执行一个简化示例,跟踪每个时期的准确率,并可视化 CLPU 模型的权重。

训练结束后,我们可以绘制准确率历史记录,以直观了解模型的性能如何随时间演变。

import matplotlib.pyplot as plt

plt.plot(clpu.accuracy_history)

plt.title('CLPU Training Accuracy Over Epochs')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.show()

对权重进行可视化可以让人了解 CLPU 模型学会了识别哪些特征。这对基于卷积的模型尤为重要。

plt.imshow(clpu.weights, cmap='viridis')

plt.title('CLPU Kernel Weights Visualization')

plt.colorbar()

plt.show()

这一过程虽然经过简化,但说明了训练、评估和解释 CLPU 模型行为的基本方法。对于实际应用或更复杂的合成数据集,还需要考虑验证集、正则化和更复杂的模型架构等其他因素。

结论

基于卷积的局部感知器单元是神经网络领域的一个有前途的发展方向,它将感知器的决策简易性与卷积运算的空间特征提取能力结合在一起。通过这种方式,CLPU 为增强人工智能模型的特征学习和识别能力提供了一种新方法。随着对 CLPU 的研究和实验不断深入,它有可能推动人工智能的重大进步,为解决各领域的复杂问题开辟新的途径。