Midjourney推出新功能:保持AI生成角色一致性

Midjourney已经实现了用户最期待的功能之一:在新图像中保持角色的一致性。

这一直是AI图像生成器面临的一大难题,主要是因为它们的特性所限。

这主要是因为,大部分的AI图像生成器都是基于“扩散模型”的,这些工具类似于或借鉴了Stability AI的开源图像生成算法Stable Diffusion。这些工具主要是通过获取用户输入的文本,并根据从数百万张人类创作的图像训练数据集中学习到的类似图像和文本标签,来逐个像素地拼凑出与描述相匹配的图像。

但是,对于生成式AI图像来说,保持角色的一致性之所以重要且难以实现,是因为所有生成式AI应用都存在响应不一致的问题:AI会根据每个输入的提示生成新的内容——在Midjourney的情况下,就是图像。那么,如果你正在为电影、小说、连环画或漫画等视觉媒介进行分镜,希望同一个角色或角色在不同的场景、设置、面部表情和道具中移动并出现,该如何处理呢?

这种通常需要叙事连贯性的场景,对于生成式AI来说,一直是一个难以逾越的难题——至少到目前为止。然而,Midjourney现在正试图解决这一问题,它引入了一个新的标签“--cref”(意为“角色引用”),用户可以在Midjourney的Discord服务器中将其添加到文本提示的末尾,并尝试从用户在此标签后粘贴的URL中匹配角色的面部特征、体型,甚至服装。

随着这一功能的不断完善,Midjourney可能会从一款有趣的创意工具转变为更加专业的应用。

如何使用Midjourney的新角色一致功能

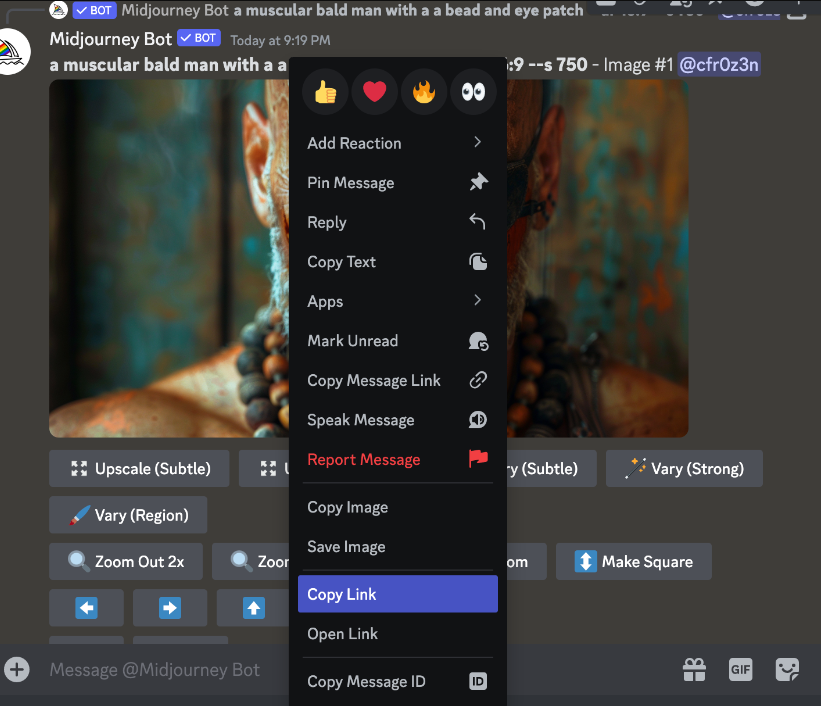

这个标签最适合与先前生成的Midjourney图像一起使用。所以,举例来说,用户的工作流程将是首先生成或检索先前生成的角色图像的URL。

让我们从头开始,假设我们用这个提示生成一个新角色:“一个肌肉发达的秃顶男人,戴着珠子眼罩。”

我们将放大我们最喜欢的图像,然后在Midjourney的Discord服务器中点击它,找到“复制链接”选项。

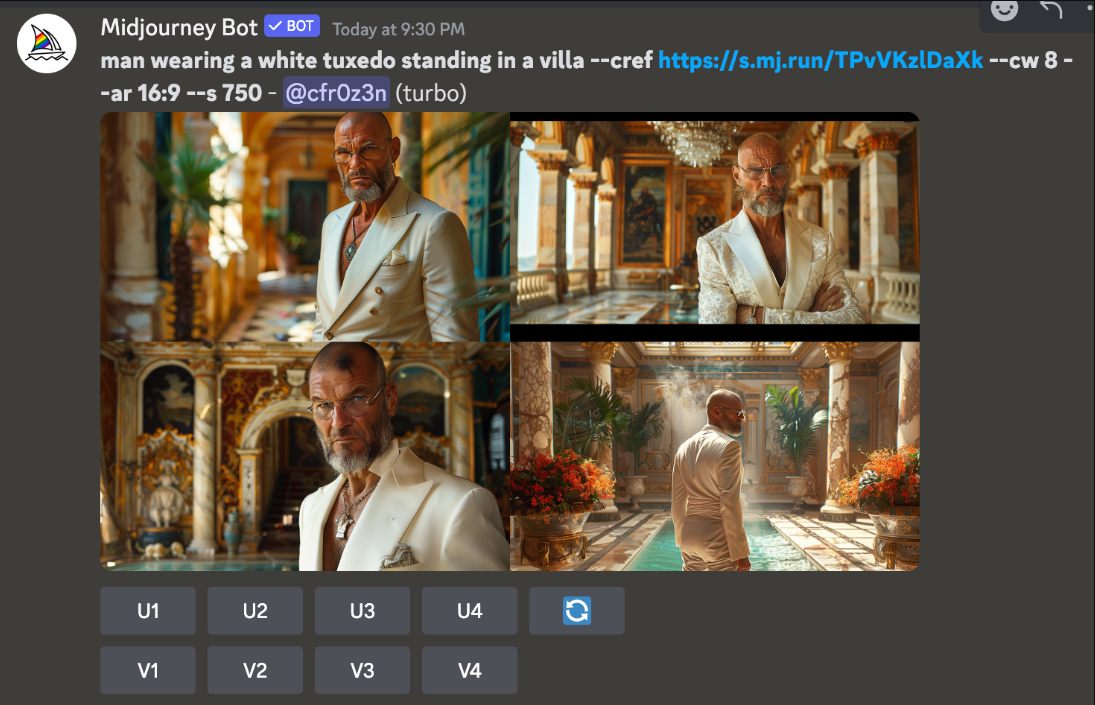

然后,我们可以在“穿着白色燕尾服站在别墅里--cref [URL]”中输入新的提示,并粘贴我们刚刚生成的图像的URL,Midjourney将尝试在我们新输入的场景中生成之前的那个角色。

你会看到,结果虽然与原始角色(甚至我们的原始提示)不是完全一致,但确实令人鼓舞。

此外,用户还可以通过在新提示的末尾(在“--cref [URL]”字符串之后)添加“--cw”标签并后跟1到100之间的数字,来控制新图像在多大程度上忠实于原始角色的再现(例如:“--cref [URL] --cw 100”)。“cw”数字越低,生成的图像变化就越大;而“cw”数字越高,生成的新图像就越接近原始参考图像。

在我们的例子中,你可以看到,输入一个非常低的“cw 8”实际上返回了我们想要的结果:白色燕尾服。尽管现在它已经去掉了我们角色标志性的眼罩。

好吧,没有什么是“vary region”功能不能解决的——对吧?

好吧,所以眼罩在错误的眼睛上……但我们正在接近目标!

你还可以使用两个“--cref”标签并排输入它们各自的URL,将多个角色合并成一个。

这个功能刚刚上线不久,但已经有艺术家和创作者在测试它了。如果你有Midjourney,不妨自己试试看。

虽然Midjourney V6仍处于alpha阶段,此功能和其他功能可能会突然更改,但V6官方beta版即将推出。