英伟达发布Blackwell GPU,引领AI计算新时代

英伟达公司CEO黄仁勋在加利福尼亚州圣何塞举行的英伟达GPU技术大会(GTC)上公布了公司下一代GPU架构,名为Blackwell,该架构有望在人工智能领域取得重大进展。此次宣布凸显了这家芯片制造商在AI硬件市场的持续主导地位。

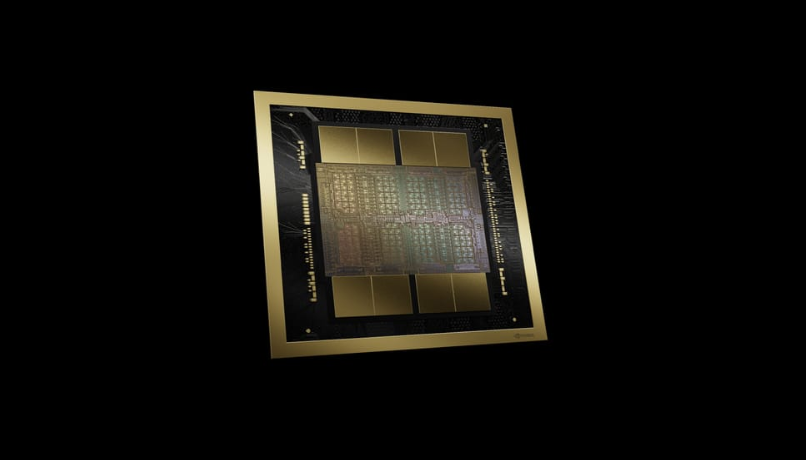

Blackwell GPU以著名数学家和统计学家大卫·哈罗德·布莱克威尔(David Harold Blackwell)的名字命名,预计将取代两年前推出的非常成功的Hopper架构。Blackwell芯片采用了令人印象深刻的2080亿个晶体管,采用定制的4NP TSMC工艺制造,从而实现无与伦比的性能和效率。

Blackwell架构的一个关键创新是第二代Transformer引擎,它支持的计算和模型大小是前代产品的两倍。这一进步与英伟达公司的TensorRT-LLM和NeMo Megatron框架相结合,将能够以更低的成本和能耗开发和部署万亿参数规模的AI模型。

包括亚马逊网络服务、戴尔科技、谷歌、Meta、微软、OpenAI、甲骨文、特斯拉和xAI等在内的科技巨头预计将采用Blackwell平台,进一步巩固英伟达作为AI硬件首选供应商的地位。这些公司对Blackwell GPU的突破性能力表示了热情,这将使他们能够加速各种行业的发现和推动创新。

Blackwell架构还引入了几项其他突破性技术,如第五代NVLink,其每个GPU的双向吞吐量高达惊人的1.8TB/s,确保数百个GPU之间无缝通信,以支持最复杂的大型语言模型(LLM)。此外,RAS引擎和先进的机密计算能力在不牺牲性能的情况下,增强了系统的正常运行时间、恢复能力和数据保护。

英伟达致力于加速数据处理,为此专门配备了解压缩引擎,支持最新格式并加速数据库查询。这一发展尤为重要,因为预计在未来几年中,数据处理将越来越多地通过GPU加速来实现。

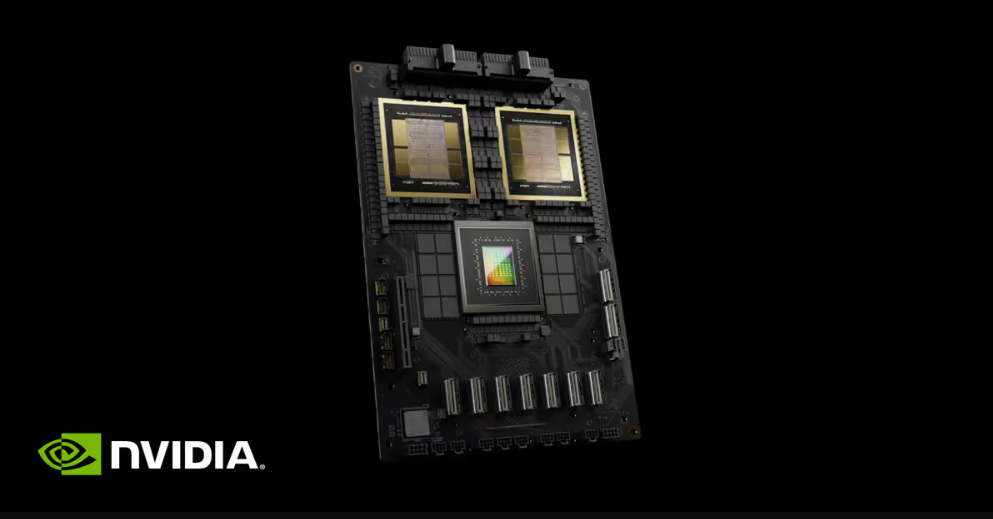

GB200 Grace Blackwell Superchip是一款多节点、液冷、机架规模的系统,集成了36块Grace Blackwell Superchip,与相同数量的NVIDIA H100 Tensor Core GPU相比,在大型语言模型(LLM)推理工作负载方面,性能提高了高达30倍。该平台作为单个GPU,拥有1.4百亿亿次浮点运算的AI性能和30TB的快速内存,成为最新DGX SuperPOD的基础构建块。

基于Blackwell的产品将于今年晚些时候由一系列合作伙伴提供,包括云服务提供商、服务器制造商和软件制造商。这一全球合作伙伴网络将使各行业组织能够利用Blackwell的强大功能,应用于生成式AI、工程仿真、电子设计自动化和计算机辅助药物设计等应用。

正如黄仁勋在主题演讲中所说:“生成式AI是我们时代的定义性技术。Blackwell是推动这场新工业革命的引擎。”随着Blackwell GPU的推出,英伟达有望维持其在AI硬件市场的领导地位,推动人工智能和加速计算领域前所未有的进步。