模型上下文长度越来越长,RAG会被取代吗?

简介

长上下文视窗会不会取代 RAG?

1. 大型或长上下文视窗(LCW)与 RAG 是两种不同的使用情况。

2. LCW 将用于一次性单个提示场景,即在单个提示中对提交的长内容提出多个问题。以下是 Anthropic 提供的此类提示的示例。

ur task is to generate multiple choice questions based on content from the following document:

<document>

{{DOCUMENT}}

</document>

Here are some example multiple choice questions and answers based on other parts of the text:

<examples>

Q1: [Example question 1, created from information within the document]

A. [Answer option A]

B. [Answer option B]

C. [Answer option C]

D. [Answer option D]

Answer: [Correct answer letter]

Q2: [Example question 2, created from information within the document]

A. [Answer option A]

B. [Answer option B]

C. [Answer option C]

D. [Answer option D]

Answer: [Correct answer letter]

</examples>

Instructions:

1. Generate 5 multiple choice questions based on the provided text.

2. Each question should have 4 answer options (A, B, C, D).

3. Indicate the correct answer for each question.

4. Make sure the questions are relevant to the text and the answer options are all plausible.

3. LCW 主要供单个用户一次性使用。对于大容量架构来说,每次推理都发送如此大量的数据是不可行的。

4. 由于每次推理都要使用大量令牌,因此推理成本极高。

RAG 是一种高度可检查、可观察和可管理的解决方案,是一种非梯度方法。在优化推理时间的同时,还能利用 LLM 独特的上下文学习能力。

5. 考虑到推理等待时间以及每次查询所发送的数据量,仅基于 LCW 的方法无法优化速度。

6. 高度可扩展和优化的解决方案需要一定程度的弹性,而 LCW 方法由于缺乏粒度而无法解决这一问题。

7. 试想一下,如果采用 LCW 方法而不是 RAG 方法,优化解决方案将是多么困难。LLM 本质上是一个黑盒子,访问长上下文不同部分的方法是不透明的。

8. 大型语言模型 (LLM) 擅长语境学习 (ICL),通过为 LLM 的每次推理提供恰到好处的语境,ICL 的优势尤为明显。

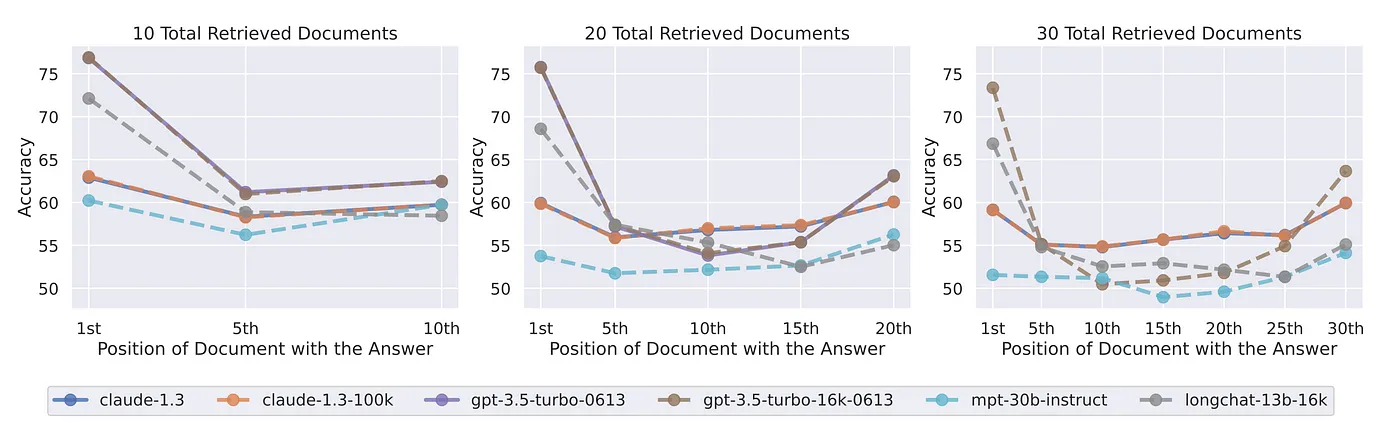

9. 最近一项名为 "迷失在中间"(Lost in the middle)的研究证明了长篇上下文提交文档的开头和结尾处的事实如何比结尾处的文档得到更多的覆盖。

RAG 是实现 LLM 独立的一个步骤。

10. 对于可扩展的企业级生成式人工智能方法而言,数据发现和数据设计至关重要。

这一过程的一部分包括对数据隐私和匿名化进行尽职调查。

发现在用例和客户意图方面具有强烈信号的数据后,下一步就自然而然、合乎逻辑地将这些数据分块为高度上下文关联的文本片段,以注入推理。

11. RAG 允许采用高度可检查、可观察和可管理的解决方案,这是一种非梯度方法。同时优化推理时间,并利用 LLM 独特的上下文学习能力。

12. RAG 是实现 LLM 独立性的一个步骤。研究表明,被认为低劣的 LLM 在获得上下文参照时会表现出色。RAG 在很大程度上与 LLM 无关,而使用 LCW 方法肯定无法实现 LLM 的独立性。

上下文中的标记

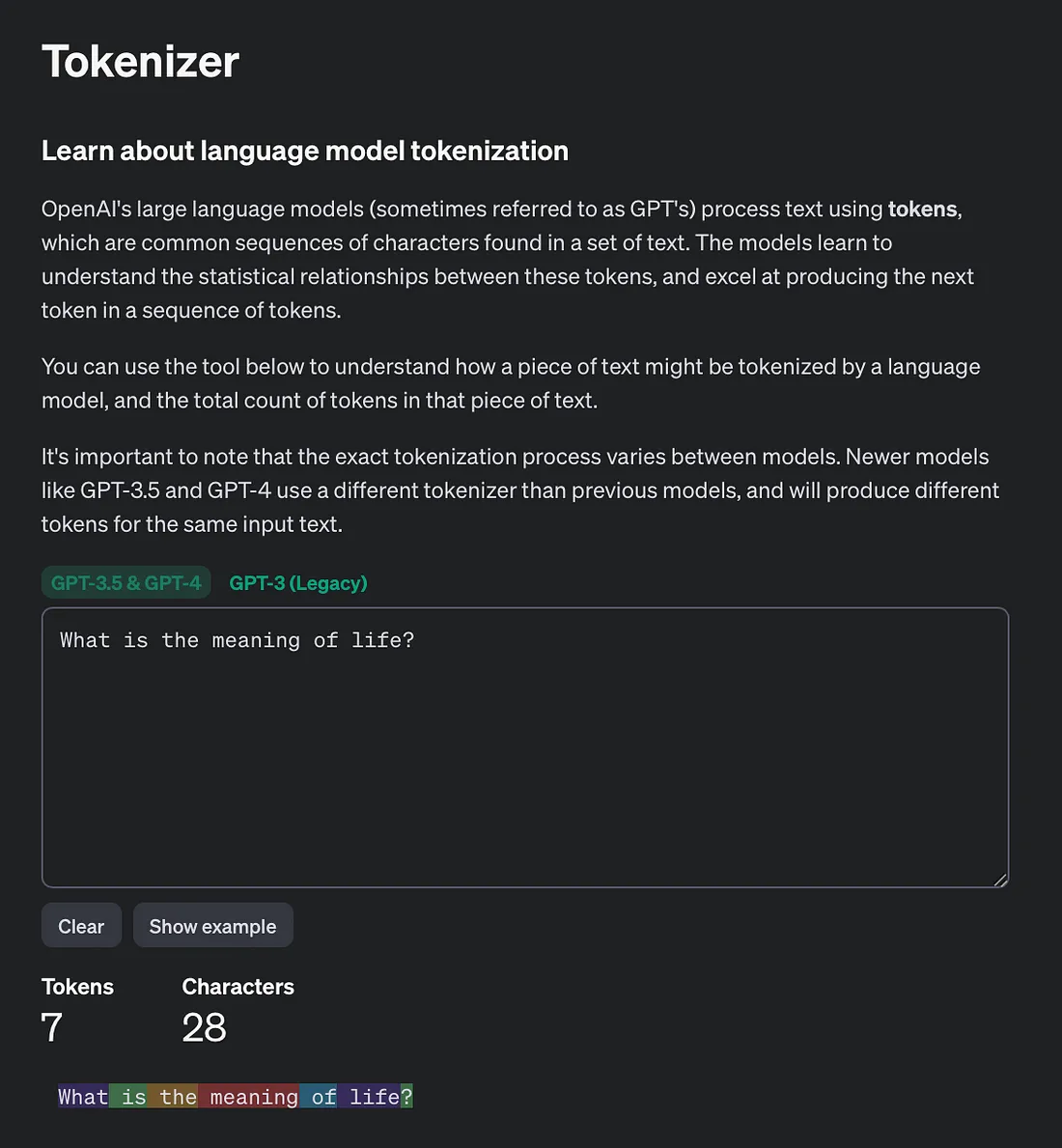

为了将标记的使用与上下文联系起来,下面是 OpenAI 标记化计算器。该计算器可将文本转换为标记,并根据推理输入和输出的大小计算成本。

下表显示了一些 Anthropic 和 OpenAI 模型的上下文窗口,以及它们各自每 100 万个代币的定价。

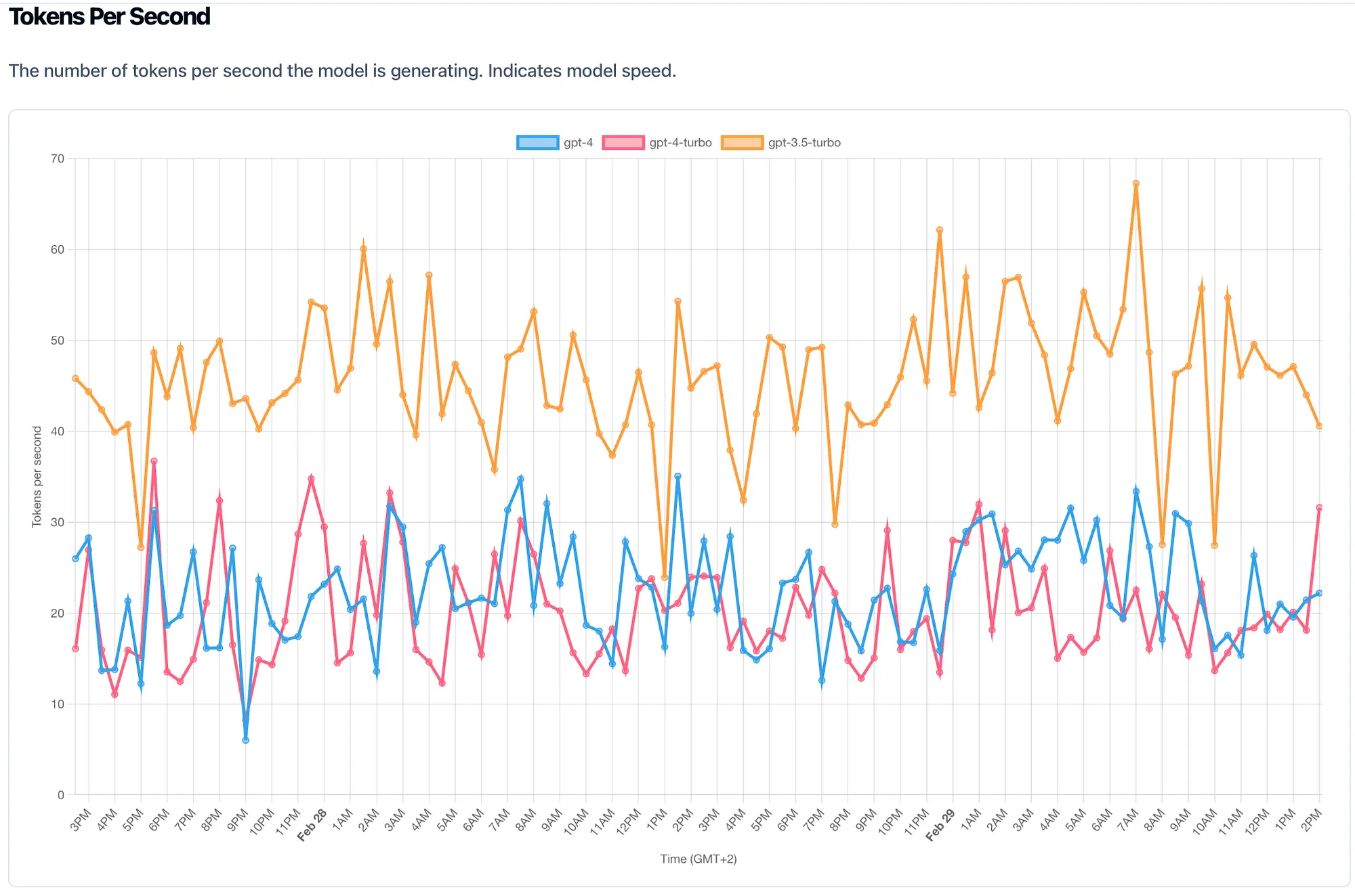

下图显示了模型每秒生成的词块数量。这很好地说明了模型的推理时间。生成一个句子需要一秒钟以上的时间。

情境学习

最近的一项研究表明,法学硕士实际上不具备突现能力,而过去被视为突现能力的实际上是法学硕士利用情境学习(ICL)的能力。

ICL 充分利用了 LLM 在逻辑和常识推理、自然语言生成、语言理解和上下文对话管理方面的能力。

除了不严重依赖 LLM 的知识密集性之外。

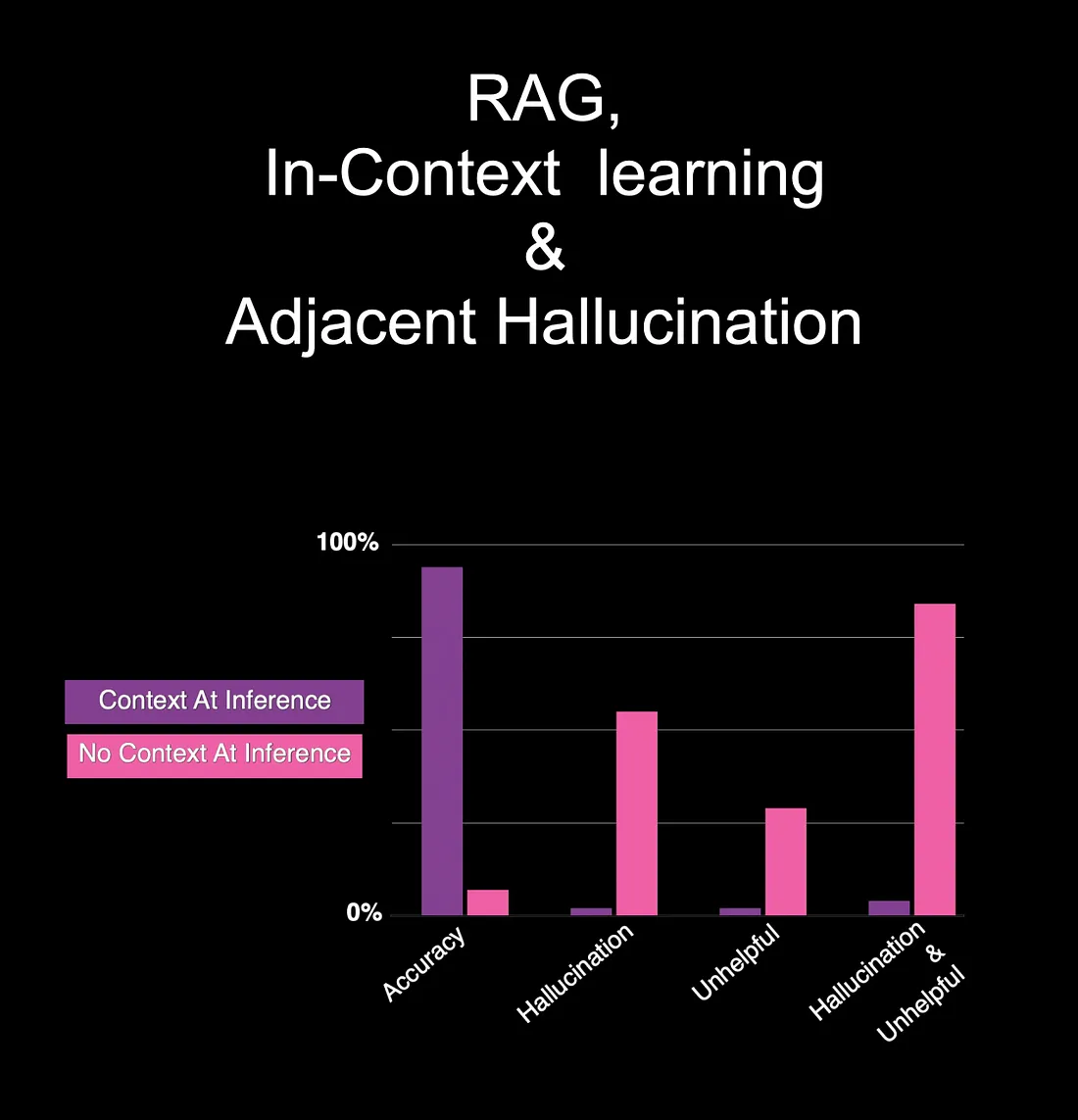

从上图可以看出,在有语境和没有语境的情况下,两者形成了鲜明的对比。研究考虑的类别包括准确性、幻觉、有用性和有用性与幻觉的结合。

Lost in the middle

最近的一项研究考察了 LLM 在两项任务中的表现:

- 一项任务涉及在输入语境中识别相关信息。

- 第二项任务涉及多文档问题解答和键值检索。

研究发现,当相关信息位于输入上下文的开头或结尾时,LLM 的表现更好。

然而,当相关上下文位于较长上下文的中间时,检索性能就会大大降低。专为长语境设计的模型也是如此。

结论

总之,了解任何组织数据中的语义相似性、了解客户希望进行哪些对话以及优化推理时注入的数据都具有重要价值。