谷歌推出突破性通用视频理解模型VideoPrism

谷歌人工智能推出了一项名为VideoPrism的新研究,这项研究介绍了一种具有突破性的通用视频理解单模型。这款基础视觉编码器旨在处理一系列广泛的任务,包括分类、定位、检索、字幕生成和问题回答。

在论文中,谷歌表示,VideoPrism的发展是由预训练数据和建模策略的创新共同推动的。该模型在庞大且多样化的数据集上进行预训练,其中包括3600万个高质量视频文本对和5.82亿个带有嘈杂或机器生成并行文本的视频片段。这种混合数据方法使VideoPrism能够从视频文本对和视频本身中学习。

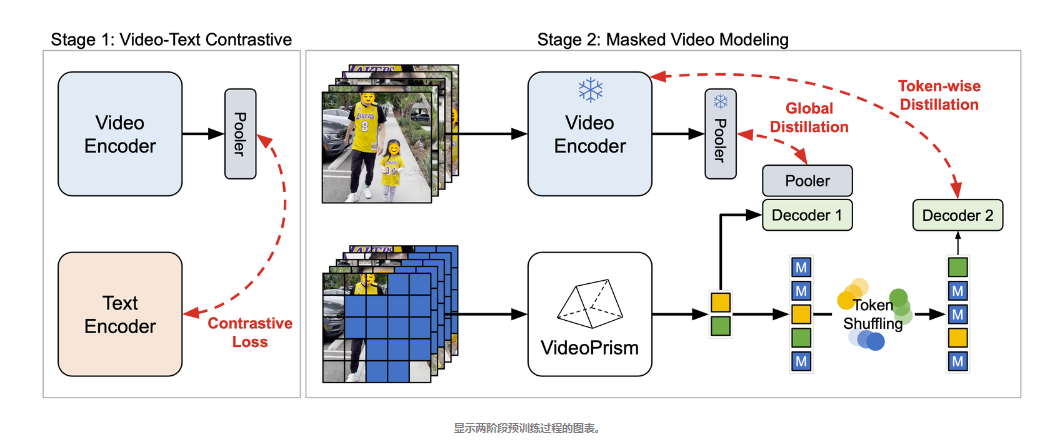

预训练过程包括两个阶段。首先,使用对比学习来教模型将视频与其文本描述进行匹配,从而为将语义语言内容匹配到视觉内容奠定基础。然后,模型预测视频中被掩盖的部分,利用在第一阶段中获得的知识。这种独特的设置使VideoPrism在需要理解外观和运动的任务中表现出色。

在四个广泛的视频理解任务类别中进行的广泛评估表明,VideoPrism具有出色的性能。该模型在33个视频理解基准测试中的30个上取得了最先进的结果,而且所有结果都是通过一个单一的冻结模型进行最小适应后得到的。这些基准测试包括视频分类和定位、视频文本检索、视频字幕生成、问题回答和科学视频理解。

VideoPrism与大型语言模型结合的能力进一步释放了其在处理各种视频语言任务方面的潜力。当与文本编码器或语言解码器配对时,VideoPrism在广泛且具有挑战性的视觉语言基准测试中设定了新的标准。该模型在理解视频中复杂运动和外观方面的能力尤其令人印象深刻。

最令人兴奋的是VideoPrism在科学应用方面的潜力。该模型不仅在科学家使用的跨领域数据集(如行为学、行为神经科学和生态学)上表现出色,而且实际上超越了专门为这些任务设计的模型。这表明,像VideoPrism这样的工具可能会改变科学家在不同领域分析视频数据的方式。

“VideoPrism为人工智能和视频分析交叉领域的未来突破铺平了道路,有助于实现视频基础模型在科学发现、教育和医疗保健等领域的潜力。”——谷歌研究的高级研究科学家龙兆和高级软件工程师刘婷

VideoPrism的推出标志着通用视频理解模型发展过程中的一个重要里程碑。它能够在广泛的任务中进行泛化,以及其在现实世界应用中的潜力,使其成为各个领域研究人员和专业人士的有前途的工具。随着谷歌人工智能继续在这一领域进行负责任的研究,并遵循其人工智能原则的指导,我们可以期待看到更多利用人工智能的力量来理解和解释大量可用视频数据的突破。