HyperLLaVA:通过动态视觉和语言专家增强多模态语言模型

大型语言模型(LLMs)在处理以语言为核心的应用上展现了卓越的多功能性。然而,为了使其能够应对更广泛的输入形式,多模态大型语言模型(MLLMs)开始受到越来越多的关注。这些模型对于构建能够理解和处理文本、图像、视频及音频等多种信息形式的灵活助手至关重要。

当前流行的MLLMs,如LLaVA,通常遵循两阶段的训练模式:首先是视觉与语言的对齐,这里通过一个静态投影仪将视觉特征与语言模型的词嵌入空间进行匹配,让LLM能够理解视觉内容;接着是多模态指令微调,通过对LLM进行微调,使其能够更好地响应涉及视觉内容的多样化用户请求。

尽管这两个阶段至关重要,但投影仪的结构和LLM的调整策略仍待深入探索。现有的研究大多集中在扩大预训练数据、指令跟随数据、视觉编码器或语言模型上。然而,静态参数的学习模型可能在处理多样化的多模态任务时存在局限性。

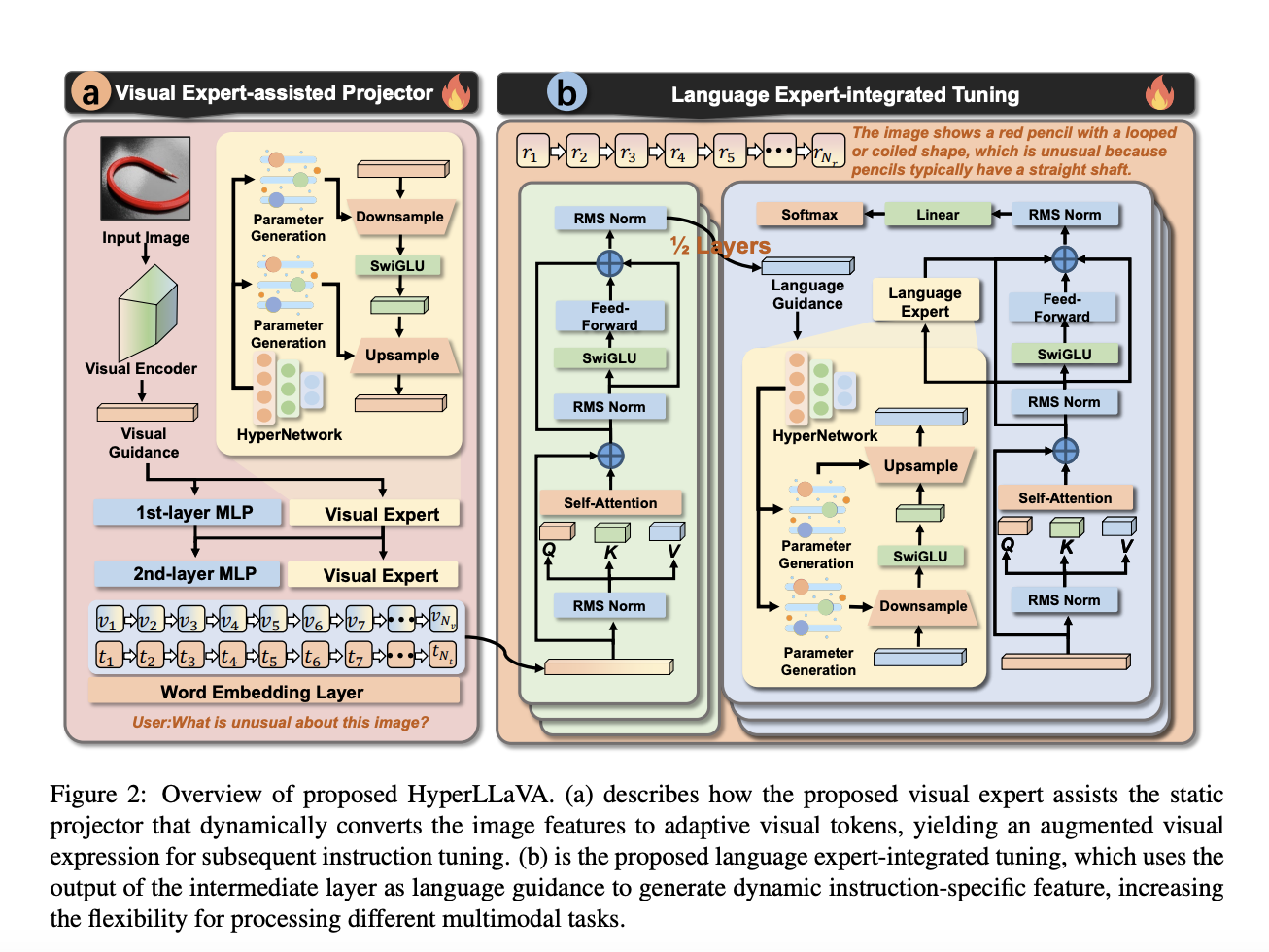

为了突破这一局限,研究者提出了HyperLLaVA,这是LLaVA的动态版本。它借鉴了HyperNetworks中的专家模块设计,能够根据输入信息生成动态参数。这使得模型能够自适应地调整投影仪和LLM层,从而增强其在多种多模态任务中的推理能力。

HyperLLaVA的训练分为两个关键步骤:

首先,在视觉与语言对齐阶段,将投影仪分解为静态层(即LLaVA中的原始MLP)和动态层(即视觉专家)。静态层的参数保持不变,而动态层的参数则根据视觉输入动态生成。视觉专家借助HyperNetworks协助静态投影仪学习一个针对视觉特征的特定投影仪,这个投影仪能够根据视觉信息自适应地建模特征。这样,投影仪就能将适应性视觉标记传递到语言语义空间中。

其次,在多模态指令微调阶段,为LLM配备了一个语言专家,用于为LLM块建模动态参数。LLM的中间输出被视为语言指导,指导语言专家更好地理解用户的请求并提供针对性的指令。通过为每个输入生成独特的参数,MLLM增强了其灵活性,能够利用跨数据集样本之间的相似性,并避免同一数据集内样本之间的潜在干扰。这一语言专家作为MLLMs的参数高效微调方法,不仅与原始LLaVA的性能相当,还增强了模型处理多样化多模态任务的能力。

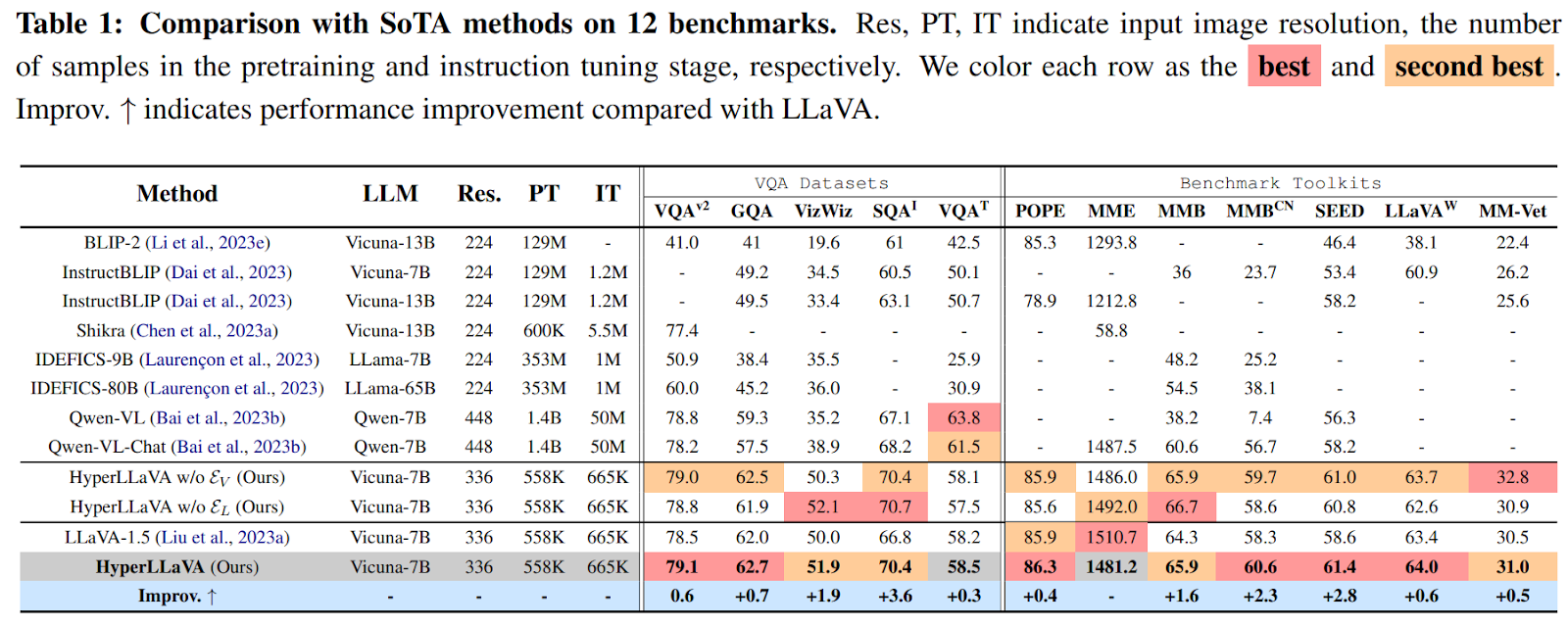

在实验中,研究人员在多个数据集上评估了HyperLLaVA的性能,包括五个VQA数据集(VQAv2、GQA、VizWiz、SQAI和VQAT)和七个基准工具包(POPE、MME、MMB、MMBCN、SEED、LLaVAW和MM-Vet)。结果显示,HyperLLaVA在几乎所有这些基准测试的多模态场景中均优于现有的最先进方法,包括那些拥有数十亿可训练参数的更大MLLMs。通过精心设计的轻量级视觉和语言专家,静态投影仪和LLM得以促进不同多模态任务的处理能力,超越了原始LLaVA在12个基准中的11个的性能。

总的来说,HyperLLaVA的创新动态调整策略为多模态学习系统的进步开辟了新道路。通过自适应地调整投影仪和LLM参数,并结合动态视觉和语言专家,研究者们提出了一种参数高效的新方法,超越了现有的性能基准。这种方法为通过个性化、动态调整来提升多模态任务性能提供了新的视角,有望解锁更无缝地理解和整合多模态信息的新途径。