如何训练多模式LLM理解文本、图像、视频和音频并与之交互

最近,多模态大语言模型(LLM)因其能够理解和生成各种数据类型的内容而闻名,受到了研究界和科技行业的广泛关注。

这些多模态模型以 Chat-GPT 等单模态模型的基本原理为基础,整合了视觉、听觉和文本数据,能够提供更丰富、与上下文更相关的输出。

本文将简要概述多模态大型语言模型领域的背景和相关研究。

一、简介

1. 大型语言模型(LLM)

近年来,人工智能领域最具突破性的进展之一是大型语言模型(LLM)的发展和普及。

这些模型以前所未有的规模运行,处理海量数据,以惊人的准确性执行语言任务。

LLM 背后的基础技术是在大量文本语料库中进行训练。这种方法旨在为模型提供数十亿甚至上万亿个单词,帮助它理解语言结构、语义和语境。

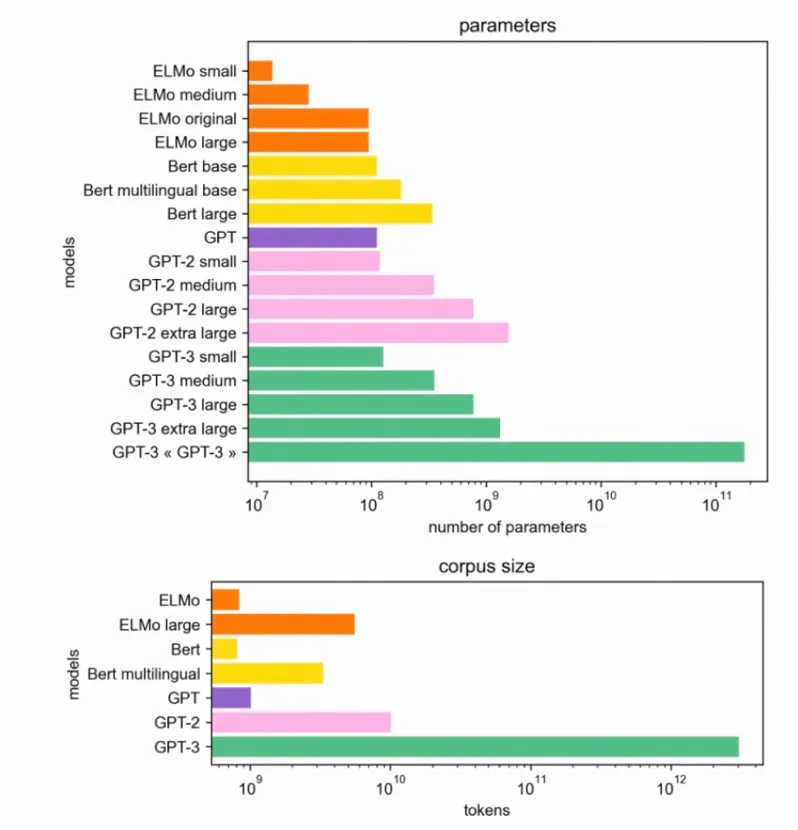

如下图所示,GPT-3至少使用token来训练语言模型。

此外,其参数的大小也呈指数级激增。如今的 LLM 拥有数十亿甚至上万亿个参数,展示了其运行背后巨大的计算能力。

参数的激增不仅仅是规模上的竞争,而是有着深远的影响。参数空间越大,模型就越能囊括庞大语言数据库的细微差别。这是一种共生关系:随着可用数据量的增长,也需要更广阔的参数空间来处理和理解这些数据。

从本质上讲,参数和数据量的共同增长催化了这些模型的精确性和适应性,使它们跻身于人工智能技术的前沿。

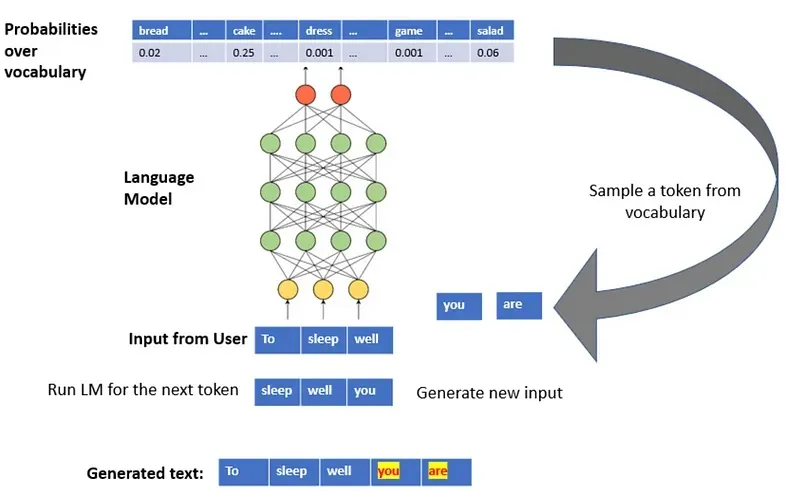

在这些 LLM 背后,训练阶段使用的一种特别重要的方法是 "下一个词预测(nwp)"。

"下一个词预测 "是一种用于开发语言模型,特别是 LLM 的训练技术。在这种方法中,模型的任务是预测给定序列或句子中的下一个词。例如,给定短语 "It's raining cats and",模型可能会根据训练结果预测 "dogs "为下一个单词。

通过不断尝试预测不同语境中的下一个单词,模型可以完善其对语言结构、语义和模式的理解。由于在训练过程中反复接触了无数的语序,LLM 变得越来越熟练,从而生成的文本在连贯性和上下文方面都非常接近人类。

2. 指令调整

虽然在大量数据集上接受过训练的 LLM 对语言有全面的理解,但它们并不总是擅长专业任务。就像医学领域的全科医生拥有广泛的知识,但可能无法进行专业手术一样,LLM 如果不进行微调,可能无法为特定任务提供最佳结果。教学调整旨在弥补这一差距,将 LLM 塑造成特定领域或功能的专家。

LLM 中的指令调整是一种专门的微调过程,它缩小了模型的一般知识范围,使其能够胜任特定的任务或指令。当 LLM 在广泛的语料库中接受了大量训练后,指令调整会完善其广泛的掌握能力,以更高的准确性和精确度来应对特定的查询或任务。

与让模型接触各种语言模式的初始训练阶段不同,指令调整让 LLM 专注于遵循指令。指令调整通常使用带有明确指令的数据集来引导模型的学习轨迹。初始训练优先考虑的是广泛的理解,而指令调整则强调对特定查询做出响应时的精确性和相关性。

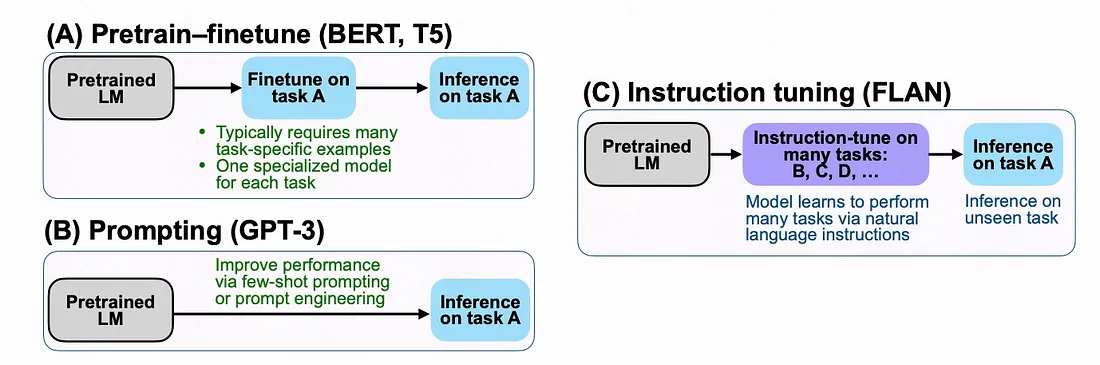

如下图所示,在之前的预训练-微调方法中,模型在广泛的语料库中经历了初始预训练阶段,随后在更具任务针对性的数据集上进行微调。这种技术使模型能够利用预训练期间获得的广泛知识,并针对特定任务进一步完善。

不过,这种方法往往需要大量的标注数据来进行微调,而且存在对专门数据集过度拟合的内在风险。

另一方面,提示法不需要额外的训练。取而代之的是,向模型提供精心设计的提示,引导它们产生所需的输出。这种方法能够避免以任务为中心的微调需求,并能适应不同的任务,因此脱颖而出。

然而,对完美提示的追求有时是难以捉摸的,与其说它是一门精确的科学,不如说是一门艺术,而且也无法保证回答的精确性或具体性。

最后,"指令调整 "是一种将预培训的广泛知识基础与任务一般培训的细致精确无缝融合的方法。这种协调确保了模型在所有下游任务中的熟练程度。

然而,与预训练-微调方法类似,指令-微调可能需要不同的数据集和明确的指令,在总体知识和精确特异性之间取得适当的平衡仍然至关重要。

3. 多模态 LLM

LLM在与文本相关的任务中取得了令人瞩目的进展,在理解、生成和推理文本内容方面表现出了卓越的能力。它们善于解读错综复杂的语言和各种文本数据集中的细微差别,这确实值得称赞。

然而,法学硕士面临的一个新兴挑战是他们熟练处理多模式数据的能力。

传统上,法学硕士主要设计用于处理文本数据。因此,使他们能够理解多模式输入(涵盖图像、视频和音频)并与之交互,这构成了重大挑战。

最近的进展提出了一种创新方法:利用法学硕士强大的预训练知识库来适应多模式输入。通过这样做,我们希望像 LLaMA这样的开源 LLM 可以进行微调,不仅可以处理数据,还可以从不同的数据类型中得出有意义的解释。

这一演变旨在实现整体的多模态理解和推理,标志着向更通用和更全面的人工智能系统的重大飞跃。

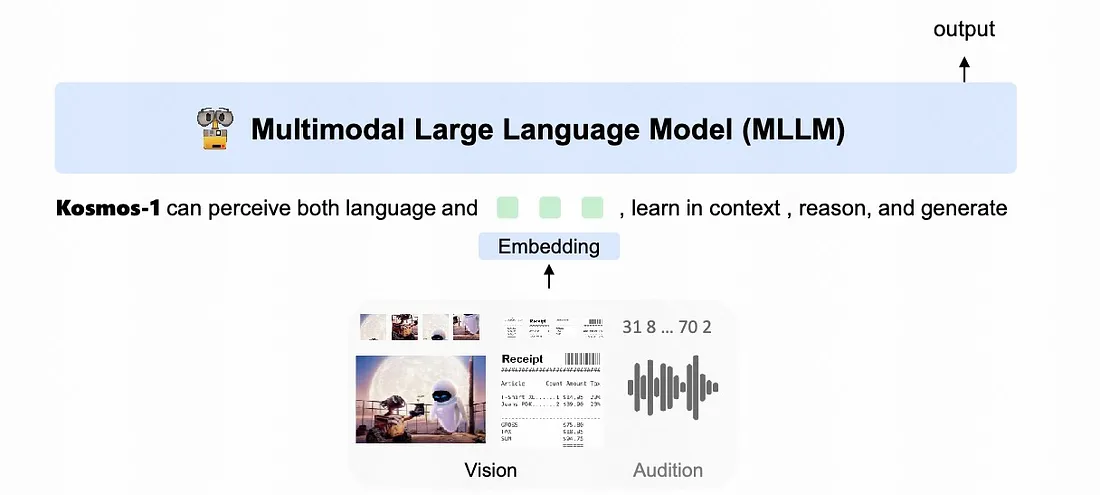

在下图中,很明显 Kosmos-1 具有处理语言和视觉数据的能力。这使得它能够推理、理解多模式输入并生成适当的响应。

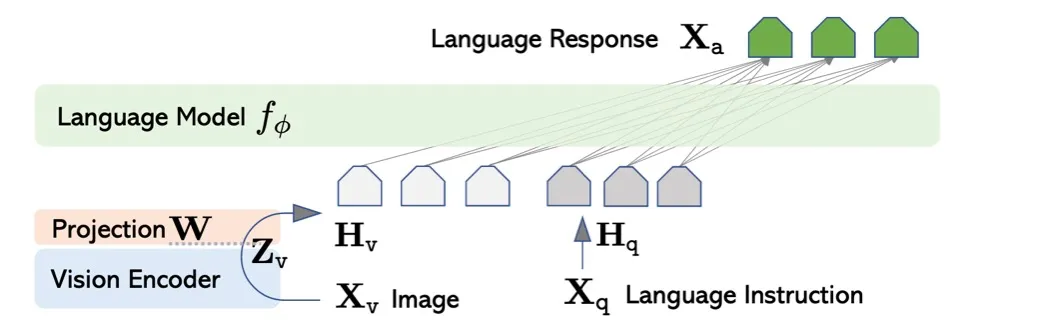

通常,在这种情况下使用的方法是视觉编码器,如视觉转换器(ViT)。视觉转换器的主要作用是将视觉数据转换为与大型语言模型(LLM)兼容的嵌入空间。转换完成后,冻结的 LLM将被用于对合并的多模态输入标记进行推理。

4. M-LLM的训练过程

LLM 主要用于处理文本数据。另一方面,预先训练好的视觉编码器则专门用于管理和解释图像数据。鉴于两者输入模式的不同性质,将两者整合在一起需要一种专门的方法。

为了弥合这一差距,当前的多模态 LLM 采用了一种战略流程,即首先将图像嵌入与 LLM 嵌入空间进行对齐。这种对齐是通过密集的多模态预训练阶段实现的。在这一阶段,重点放在自动回归学习上。这种方法包括使用大量不同的图像-文本对来训练系统。

这样做的目的是教会 LLM 将图像与其文字说明联系起来。通过为呈现给它的每张图片生成准确而相关的标题,LLM 被训练成能从图片中提取关键语义。这种做法可确保在遇到新的或不熟悉的图像时,LLM 能够分辨出图像的核心元素,并将其转化为连贯的描述性标题。

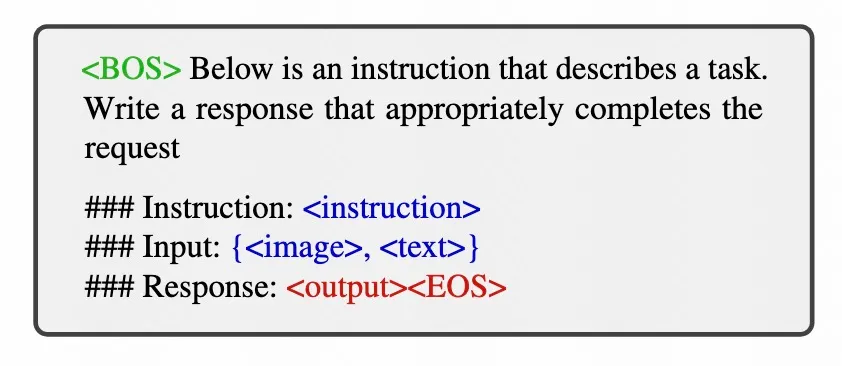

在此之后,还有一个被称为 "指令调整"(instruction-tuning)的进一步完善阶段。为此,我们专门构建了多模态数据集。这些独特的数据集包含指令、图像和相应文本的混合。通过在这些数据集上进行训练,多模态 LLM 不仅能熟悉图像,还能熟悉与图像相关的类似人类的指令。这最终形成了一个复杂的系统,让多模态 LLM能够以标准 LLM的方式处理指令并做出反应。