NVIDIA Hopper在MLPerf结果中引领生成式AI推理

NVIDIA在最新的MLPerf基准测试中公布了性能指标,进一步巩固了其在生成式AI领域的领先地位。利用专门为LLM(大型语言模型)推理任务设计的TensorRT-LLM,NVIDIA的Hopper架构GPU在GPT-J LLM上的性能比半年前提高了3倍。

业界领先的创新公司正在利用TensorRT-LLM优化他们的模型,NVIDIA NIM(NVIDIA推理微服务套件)进一步推动了这一进程,该套件包含TensorRT-LLM等强大的引擎。这种综合方法简化了NVIDIA推理平台的部署,为企业提供了无与伦比的效率和灵活性。

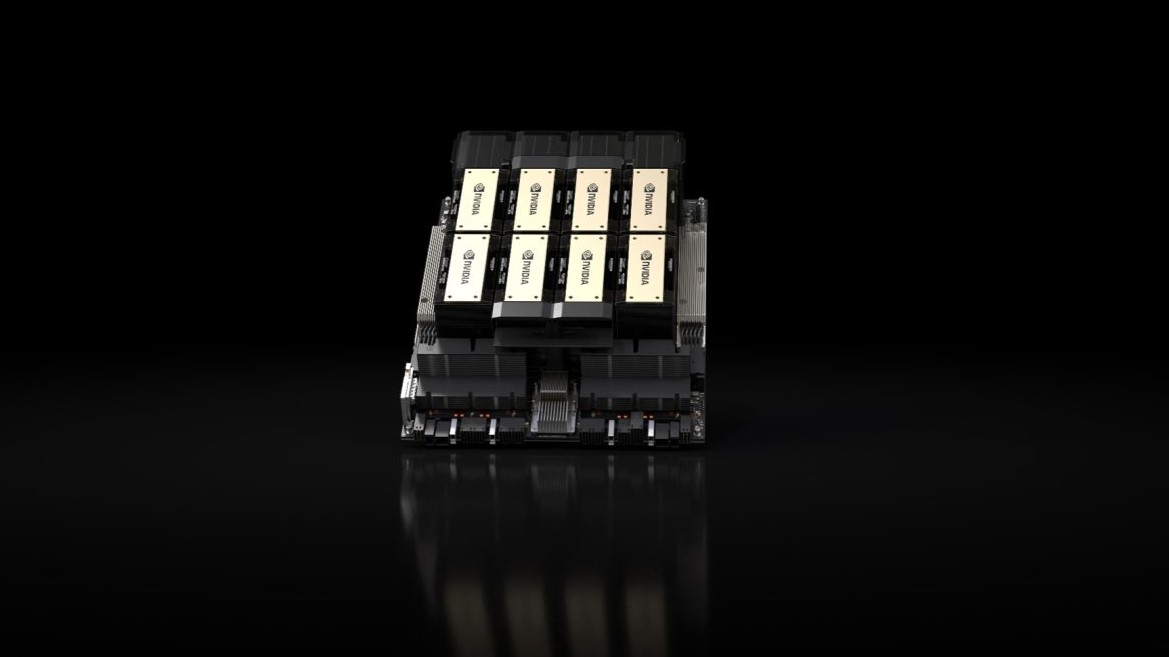

最近的MLPerf基准测试展示了生成式AI能力的巨大飞跃,TensorRT-LLM在NVIDIA最新的H200 Tensor Core GPU上运行。这些具有增强内存功能的GPU在MLPerf赛场上首次亮相,实现了惊人的吞吐量,在Llama 2 70B基准测试中每秒生成高达31000个标记。

H200 GPU的成功也突显了在热管理方面的创新步伐,定制解决方案有助于性能提升高达14%。这些进步通过系统制造商在NVIDIA MGX设计中的创造性实施得到进一步体现,从而提升了Hopper GPU的性能能力。

NVIDIA开始发货H200 GPU,这些GPU很快将通过近20家知名系统制造商和云服务提供商进行供应。

GH200超级芯片具有高达近5TB/秒的惊人内存带宽,展现了卓越的性能,特别是在内存密集型MLPerf评估(如推荐系统)中表现突出。

NVIDIA的工程师们采用了一种称为结构化稀疏性的技术——这是一种旨在减少计算量的方法,最初在NVIDIA A100 Tensor Core GPU中引入——在Llama 2的推理任务中实现了高达33%的速度提升。

针对LLM模型规模的不断扩大,NVIDIA的创始人兼CEO黄仁勋在上周的GTC大会上透露,即将推出的NVIDIA Blackwell架构GPU将提供更高的性能水平,满足多万亿参数AI模型的需求。