Databricks开源推出企业级大模型DBRX,性能超越LLaMA2

Databricks公司正式宣布并推出了DBRX这一前沿的大型语言模型,其在多项基准测试中均超越了现有的开源模型,表现卓越。公司的目标是为那些希望利用生成式AI力量的企业提供优质、可个性化的人工智能解决方案。

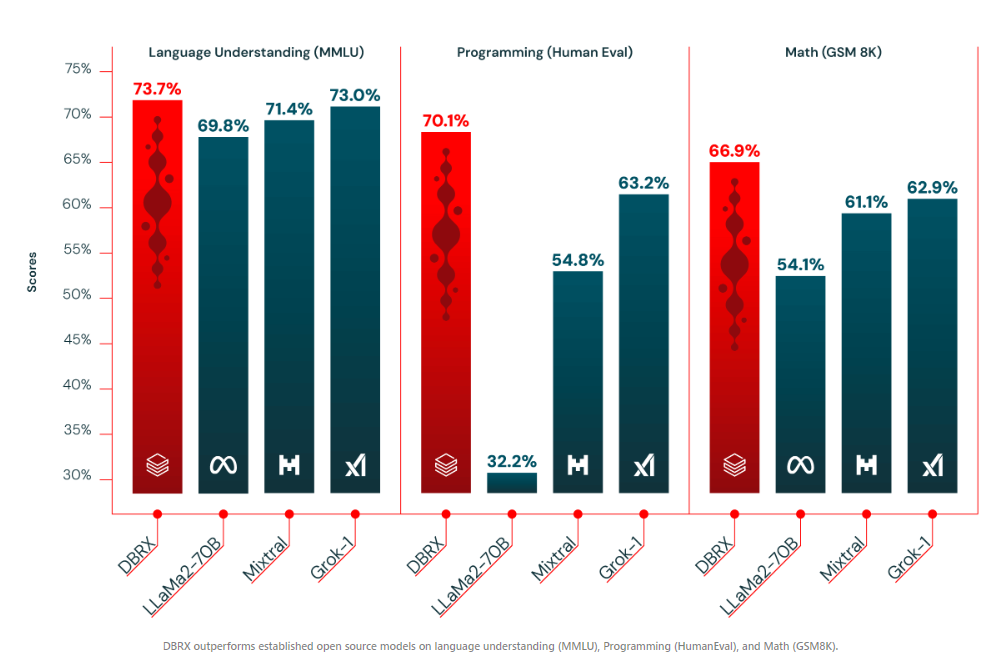

DBRX在各类测试中展现出了非凡的实力,尤其在语言理解、编程、数学和逻辑任务上,它超越了LLaMA2-70B、Mistral和Grok-1等模型。根据Databricks的开源基准测试Gauntlet,DBRX在30多个最新的基准测试中均名列前茅,这充分展现了开源模型质量的持续进步。

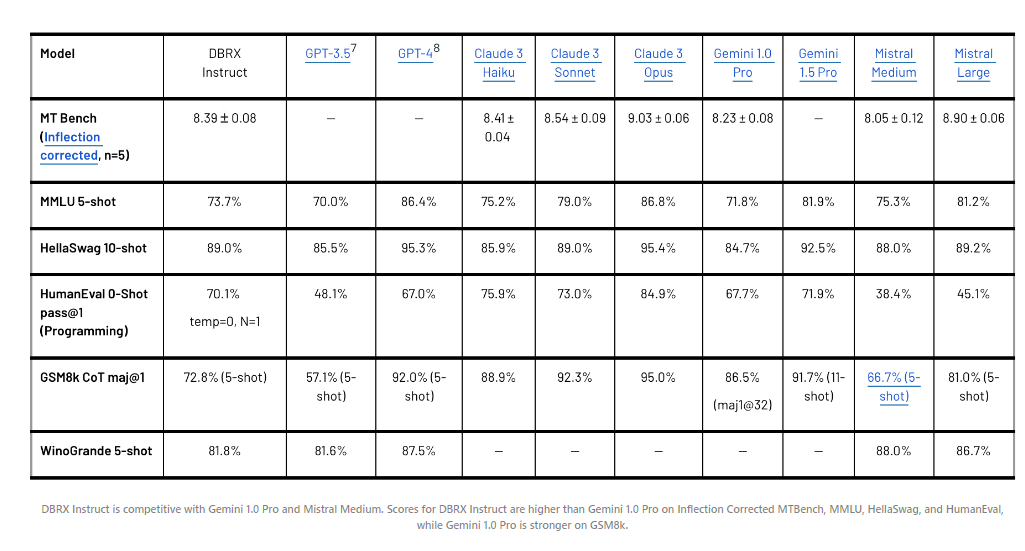

值得注意的是,DBRX在大多数基准测试中的表现甚至优于GPT-3.5,这一结果具有深远意义。随着企业越来越倾向于使用开源替代方案来替代专有模型,以提高效率和掌控力,DBRX的出现无疑为这一趋势注入了新的活力。Databricks在其超过12,000家的客户中观察到了这一趋势,许多客户通过为特定任务定制开源模型,实现了更高质量和更快的速度。

DBRX的另一个引人注目的地方在于其基于MegaBlocks研究和开源项目的混合专家(MoE)架构。这种设计使得模型在保持相对较小的360亿活动参数计数的同时,实现了更快的令牌生成,而模型的总参数数达到了惊人的1320亿。MoE架构使得更大模型的训练具有更高的吞吐量,从而在速度和性能方面达到了完美的平衡。

Databricks使用高达32K令牌上下文窗口对DBRX进行了训练,并完全在其平台上构建了它。在这个过程中,他们使用了Unity Catalog进行数据治理,Apache Spark™和Lilac AI进行数据处理和清理,以及Mosaic AI Training服务进行大规模模型训练和微调。

Databricks精心设计了DBRX,使其易于定制,从而帮助企业提升AI应用程序的质量。从今天开始,企业可以在Databricks平台上与DBRX进行互动,利用其在RAG系统中的长上下文能力,并在其私有数据上构建定制的DBRX模型。该模型已通过Databricks的GitHub存储库和Hugging Face(DBRX Base、DBRX Instruct)向公众开放。您还可以在下面的Hugging Face空间中试用指导模型。

基础模型(DBRX Base)和微调模型(DBRX Instruct)的权重在Hugging Face上以开放许可证的形式提供。从今天开始,Databricks的客户可以通过API使用DBRX,并可以使用Databricks用于构建DBRX的相同工具和科学,从头开始预训练自己的DBRX类模型,或在Databricks的某个检查点之上继续训练。