AI21 Labs开源推出首个基于Mamba架构的大模型Jamba

AI21 Labs刚刚发布了Jamba,这是世界上第一个基于创新Mamba架构的生产级AI模型。目前的大多数模型(如GPT、Gemini和Llama)都是基于Transformer架构。Jamba将Mamba结构化状态空间模型(SSM)和传统的Transformer架构的优点结合在一起,带来了令人印象深刻的性能和效率提升。

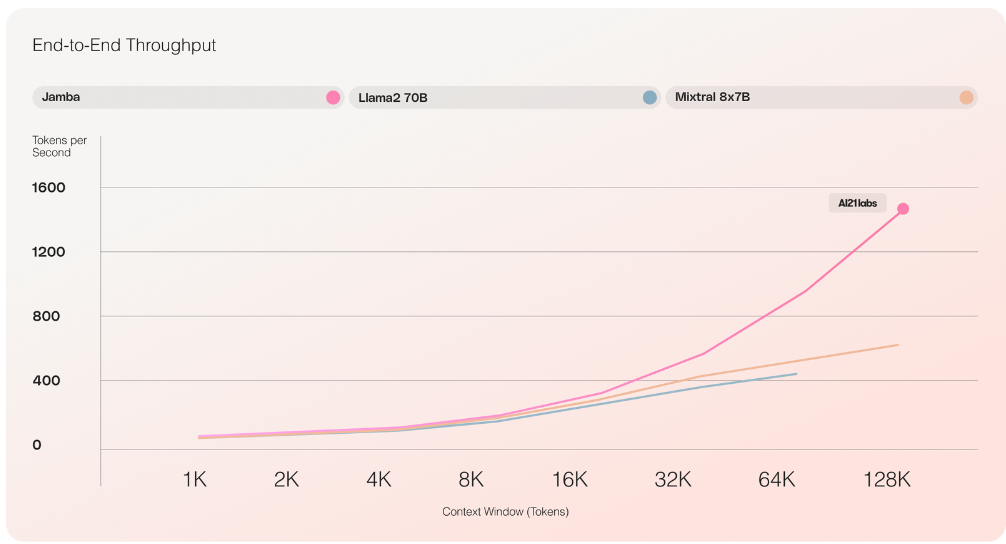

Jamba拥有256K个令牌的广泛上下文窗口,相当于大约210页文本,同时可以在单个80GB GPU上容纳多达140K个令牌。这一令人瞩目的成就得益于其混合SSM-Transformer架构,该架构利用混合专家(MoE)层,在推理过程中仅利用其可用的52B参数中的12B。结果是,与大多数同类产品相比,如Meta的Llama 2,其上下文窗口为32000个令牌,Jamba能够处理更长的上下文,同时保持高吞吐量和效率。

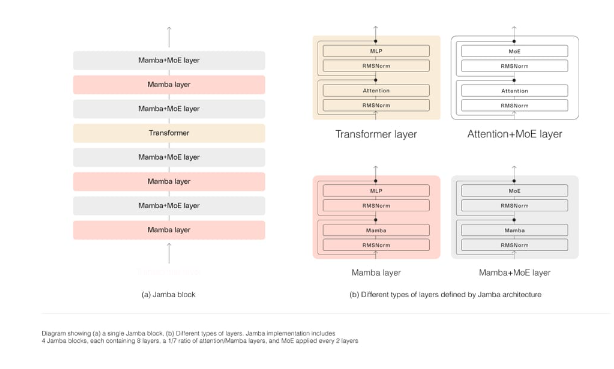

Jamba的一个关键优势是,与类似大小的基于Transformer的模型(如Mixtral 8x7B)相比,它在长上下文上的吞吐量提高了3倍。这得益于模型独特的混合架构,该架构由Transformer、Mamba和混合专家(MoE)层组成,同时优化了内存、吞吐量和性能。

它采用了块和层的方法,每个Jamba块包含一个注意力层或一个Mamba层,后跟一个多层感知器(MLP)。这导致每八个总层中只有一个Transformer层。AI21 Labs表示,这种方法允许模型在单个GPU上最大化质量和吞吐量,为常见的推理工作负载留出足够的内存。

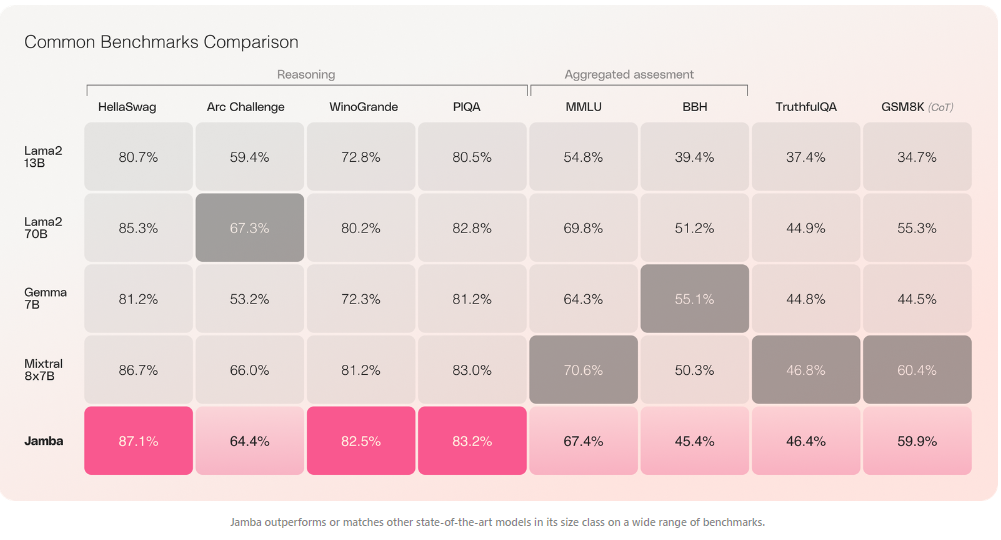

Jamba的出色表现不仅体现在效率和成本效益上。该模型已经在各种基准测试中展示了令人瞩目的结果,在广泛的任务中,其性能与同类尺寸的最先进模型相匹敌或更胜一筹。

Jamba以Apache 2.0许可证的形式开放权重发布。它可以在Hugging Face上获得,并将作为NVIDIA NIM推理微服务从NVIDIA API目录中访问,企业应用开发人员可以使用NVIDIA AI Enterprise软件平台部署它。

目前,Jamba作为研究模型发布,尚不具备商业使用所需的必要保障措施。然而,AI21 Labs计划在未来几周内发布一个经过微调、更安全的版本。随着AI社区继续探索和完善新架构,我们可以期待在性能、效率和可及性方面取得更多令人印象深刻的进步,为新一代更强大的AI模型铺平道路。