自然语言处理:数据质量和模型评估的探索

简介

在自然语言处理(NLP)领域,"垃圾进,垃圾出 "这句谚语引起了深刻共鸣,凸显了数据质量的关键作用。随着 NLP 向更复杂、更细微的应用迈进,数据质量成为开发准确、公平、能代表各种语言细微差别的模型的关键。本文深入探讨了 NLP 中数据质量的复杂性,研究了数据质量的维度、影响以及提高数据质量的方法。

NLP 中的数据质量范围

- 准确性和一致性: NLP 数据的准确性是指数据反映真实世界现象的精确度。与此相反,一致性则确保这种表征在整个数据集中是统一的。例如,在情感分析中,准确地将情感标记为正面、负面或中性是至关重要的。不同注释者或来源的一致标注可降低在矛盾数据上训练模型的风险,从而获得更可靠的预测结果。

- 完整性和相关性: 数据的完整性可确保包含 NLP 系统可能遇到的所有情况或语言变化。完整的数据集有助于训练能够处理各种输入的强大模型。同时,数据的相关性也至关重要;不相关或超出范围的数据会误导训练过程,导致模型无法完成指定任务。

- 及时性: 随着俚语、术语和情感的不断发展,语言的动态性要求 NLP 数据具有时效性。特别是在社交媒体情感分析等领域,过时的数据会导致模型必须与当前的语言趋势和公众情感保持一致。

- 多样性和代表性: 在日益全球化的世界中,NLP 系统理解和处理不同语言形式、方言和社会选择的能力至关重要。数据多样性可确保模型不会偏向于某种特定的语言或方言,从而促进包容性和更广泛的适用性。

- 噪音水平和偏差:NLP 数据的质量也可以通过其噪音水平和偏差来衡量。噪音是指不相关或错误的信息,会给训练过程蒙上阴影,而数据中的偏差则会导致倾斜的模型,使刻板印象或不公平的表述永久化。要创建准确且符合道德规范的 NLP 系统,就必须最大限度地减少这两方面的影响。

提高 NLP 中的数据质量

提高数据质量涉及细致的数据清理、注释、验证和可能的增强过程。数据清理可以消除不准确和不一致之处,而注释则必须仔细进行,以确保标签准确反映预期含义。由领域专家或通过自动检查进行验证可确保数据集的可靠性。此外,数据扩充可以丰富数据集,引入不同的场景和语言现象,从而增强模型的稳健性和通用性。

挑战与未来方向

尽管提高数据质量的方法取得了进展,但挑战依然存在。高质量的数据注释是资源密集型的,需要专家知识,特别是对于低资源语言或专业领域。如果管理不慎,自动注释工具可能会引入偏差或误差。未来的发展方向包括利用先进的机器学习技术更好地清理和扩充数据,以及开发更复杂的指标来评估 NLP 中的数据质量。

代码

下面是一个完整的 Python 代码示例,使用合成数据集演示了 NLP 中的数据质量问题。代码将涵盖数据创建、特征工程、模型训练、评估指标和绘图,所有这些都侧重于说明数据质量问题和解决方案:

import numpy as np

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, confusion_matrix

import matplotlib.pyplot as plt

import seaborn as sns

# Synthetic dataset creation

np.random.seed(0)

size = 500 # total number of samples

good_quality_texts = ["Good product. I love it!" for _ in range(size // 2)]

bad_quality_texts = ["Bad product. I hate it!" for _ in range(size // 2)]

texts = good_quality_texts + bad_quality_texts

labels = [1] * (size // 2) + [0] * (size // 2) # 1 for positive, 0 for negative

# Introduce some noise to simulate poor data quality

noise_level = 0.1 # 10% of the data will be noisy

noisy_indices = np.random.choice(range(size), int(size * noise_level), replace=False)

for index in noisy_indices:

texts[index] = "This is a neutral statement." # irrelevant data

labels[index] = 0 if labels[index] == 1 else 1 # incorrect labeling

df = pd.DataFrame({'text': texts, 'label': labels})

# Feature engineering with TF-IDF

vectorizer = TfidfVectorizer(max_features=1000)

X = vectorizer.fit_transform(df['text'])

y = df['label']

# Split the data

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Model training

model = MultinomialNB()

model.fit(X_train, y_train)

# Prediction and Evaluation

y_pred = model.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

precision = precision_score(y_test, y_pred)

recall = recall_score(y_test, y_pred)

f1 = f1_score(y_test, y_pred)

# Results and interpretation

print(f"Accuracy: {accuracy}")

print(f"Precision: {precision}")

print(f"Recall: {recall}")

print(f"F1 Score: {f1}")

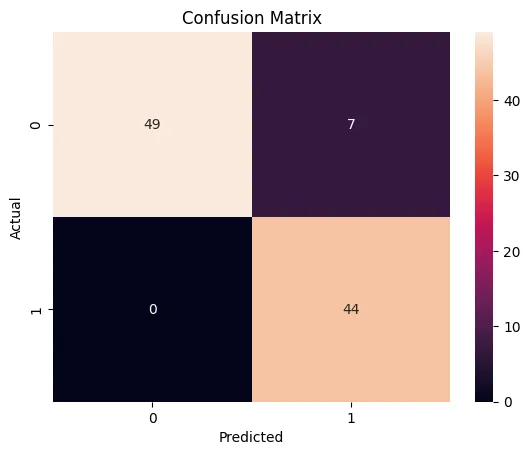

# Plotting the confusion matrix

cm = confusion_matrix(y_test, y_pred)

sns.heatmap(cm, annot=True, fmt='d')

plt.title('Confusion Matrix')

plt.xlabel('Predicted')

plt.ylabel('Actual')

plt.show()

在本代码中,我们创建了一个用于情感分析的合成数据集,其中包含故意制造的噪音,以模拟较差的数据质量。特征工程步骤使用 TF-IDF,通过强调关键词语来减轻有害的数据质量影响。我们使用各种指标对模型的性能进行了评估,并绘制了混淆矩阵,以直观地评估模型处理数据质量问题的能力。这个例子说明了数据质量如何影响 NLP 任务,以及全面评估指标对充分了解模型性能的重要性。

Accuracy: 0.93

Precision: 0.8627450980392157

Recall: 1.0

F1 Score: 0.9263157894736842

混淆矩阵显示,在 100 个实例(49 + 7 + 44)中,该模型正确预测了 49 个阴性样本(真阴性)和 44 个阳性样本(真阳性)。没有出现假阴性样本(II 类错误),这意味着所有阳性样本都被正确识别。但有 7 例假阳性(I 型错误),即阴性样本被错误地识别为阳性样本。

随附的指标提供了进一步的见解:

- 准确率(0.93): 高准确率表明该模型正确预测了 93% 的测试数据。不过,仅凭准确率可能会产生误导,尤其是在数据集不平衡的情况下。

- 精确度(0.8627): 精确度衡量的是模型仅将相关实例识别为正向实例的能力。精确度约为 0.86 意味着,当模型预测出阳性结果时,其正确率约为 86.27%。

- 召回率(1.0): 召回率或灵敏度表示模型正确识别了所有实际阳性结果。在这种情况下,模型具有完美的召回率,这对于遗漏一个阳性实例(如医学诊断中的疾病)至关重要的情况是理想的。

- F1 分数(0.9263): F1 分数是精确度和召回率的调和平均值。F1 得分为 0.9263 是非常高的,这意味着模型很好地平衡了精确度和召回率。这一点在平衡误报和漏报时尤为重要。

总之,该模型在识别阳性样本方面表现出色,但也付出了一些误报的代价。考虑到完美的召回率,该模型似乎特别适用于这样的场景,即检测不到阳性样本比错误地将阴性样本识别为阳性样本更糟糕。这可以根据应用领域中错误的具体代价进行调整。结果表明,假定合成数据集的特征与真实世界的复杂性一致,即使在数据集中引入噪声(模拟数据质量问题),该模型仍能可靠地运行。

结论

总之,数据质量是高效可靠的 NLP 系统的基石。它影响着这些系统的准确性、公平性和包容性。随着 NLP 的不断发展,必须坚持不懈地提高数据质量,确保这些技术能够有效地、合乎道德地服务于全球不同社区。因此,在 NLP 中提高数据质量不仅仅是一项技术工作,更是对创造更具包容性和代表性的语言技术的承诺。