SambaNova宣布Samba-CoE v0.2已经击败Databricks DBRX

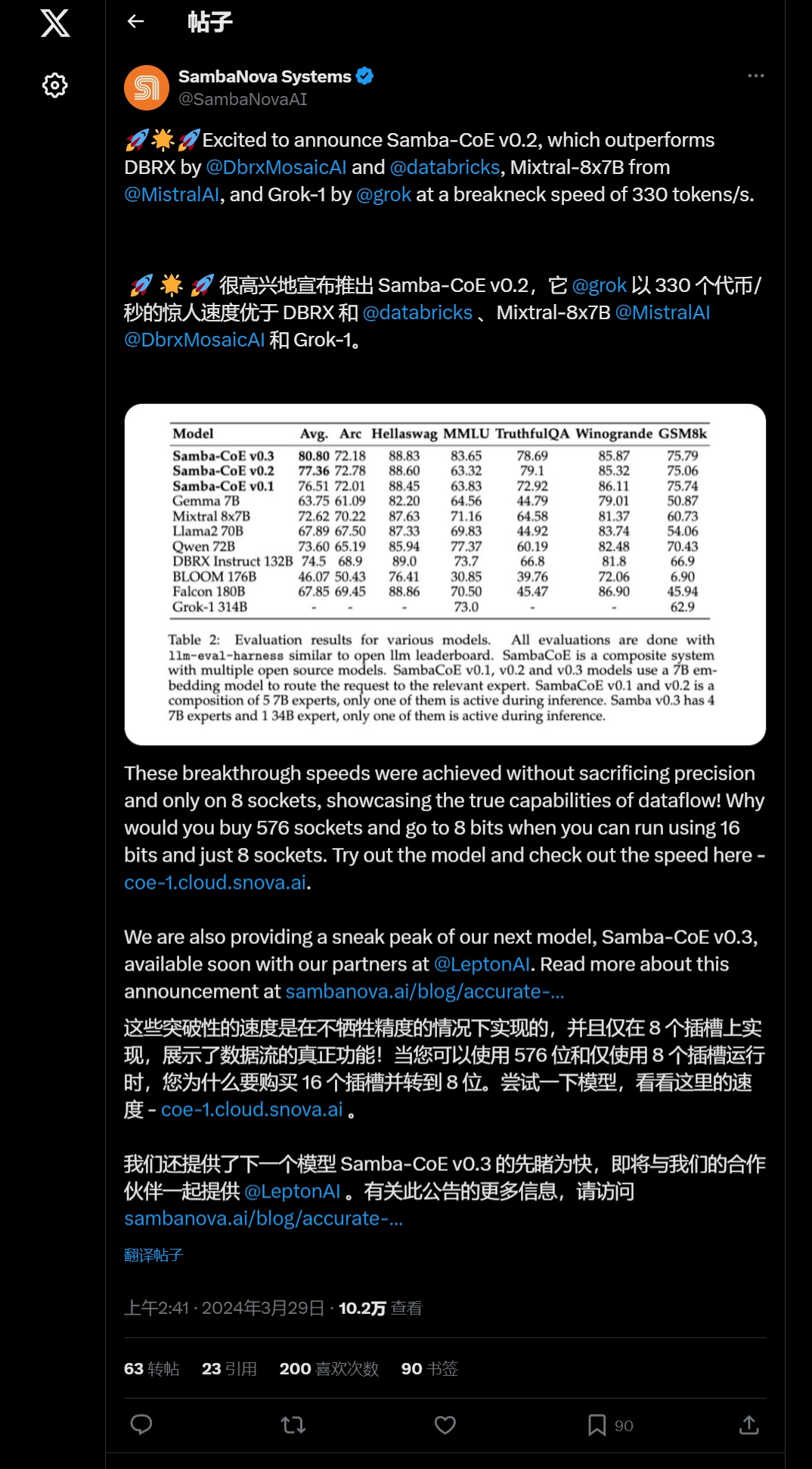

AI芯片制造商SambaNova Systems宣布,其Samba-CoE v0.2大型语言模型(LLM)取得了重大突破。这款模型每秒能够处理330个标记,这一速度超越了众多知名竞争对手,如近期发布的Databricks DBRX、MistralAI的Mixtral-8x7B以及Elon Musk的xAI推出的Grok-1等模型。

值得特别注意的是,Samba-CoE v0.2模型的高效性。它在保持高精度的同时实现了这一速度,而且仅需要8个插槽来运行,相较于其他需要576个插槽并以较低比特率运行的替代方案,其优势显而易见。

在我们对LLM的测试中,该模型展现出了惊人的响应速度。对于涉及银河系的425字问题,它仅用330.42秒就给出了答案。同样,对于量子计算的相关问题,它也能在一秒内处理高达332.56个标记,其反应之快令人瞩目。

SambaNova强调,通过使用较少的插槽并保持高比特率,实现了计算效率和模型性能的显著提升。此外,公司还透露正在与LeptonAI合作,预示着即将发布的Samba-CoE v0.3版本将带来持续的进步和创新。

这些令人瞩目的进展建立在SambaNova的Samba-1和Sambaverse开源模型之上,采用了独特的集成和模型合并方法。这种方法不仅支撑着当前版本的强大性能,还预示着未来可扩展且创新的发展方向。

与其他顶级AI模型如GoogleAI的Gemma-7B、MistralAI的Mixtral-8x7B、Meta的llama2-70B、阿里巴巴集团的Qwen-72B、TIIuae的Falcon-180B和BigScience的BLOOM-176B相比,Samba-CoE v0.2在竞争中展现出了明显的优势。

这一宣布无疑将引起AI和机器学习社区的广泛关注,并引发关于模型效率、性能以及AI未来发展方向的深入讨论。

SambaNova Systems自2017年在加利福尼亚州帕洛阿尔托成立以来,一直由Kunle Olukotun、Rodrigo Liang和Christopher Ré这三位联合创始人领导。起初,公司专注于定制AI硬件芯片的研发,但随后迅速扩展业务范围,推出了一系列全面的企业AI产品套件,包括机器学习服务以及SambaNova Suite等综合性平台。今年早些时候,公司还发布了由50个较小模型组成的、拥有1万亿参数的AI模型Samba-1。

从一家以硬件为中心的初创公司,到如今的全方位AI创新者,SambaNova的演变展现了其创始人致力于推动可扩展、易访问的AI技术的坚定信念。随着公司在AI领域的深入发展,它已成为与Nvidia等业界巨头竞争的有力对手。在2021年,SambaNova以超过50亿美元的估值成功融资了6.76亿美元,进一步巩固了其在AI市场的地位。如今,该公司正与Groq等专注于AI芯片的初创公司以及老牌企业如Nvidia展开激烈竞争,共同推动AI技术的发展。