自然语言处理中的BERT上下文嵌入增强研究

简介

在自然语言处理(NLP)领域,上下文嵌入标志着一种革命性的转变,使机器能够以前所未有的细微差别和准确性理解语言。与传统的单词嵌入(为每个单词分配一个静态向量)不同,上下文嵌入会根据单词的上下文生成动态的表示。本文将深入探讨上下文嵌入、其发展及其对 NLP 的深远影响。

词语表征的演变

要理解上下文嵌入的意义,首先必须了解 NLP 中词语表示法的演变。最初,词被表示为离散符号或单点向量,严重限制了捕捉语义关系的能力。词嵌入(如 Word2Vec 和 GloVe)的引入标志着一个重大进步,它提供了密集的向量表示,囊括了词与词之间的语义相似性。然而,这些静态嵌入无法解释多义词--即一个词根据上下文具有多种含义的现象。

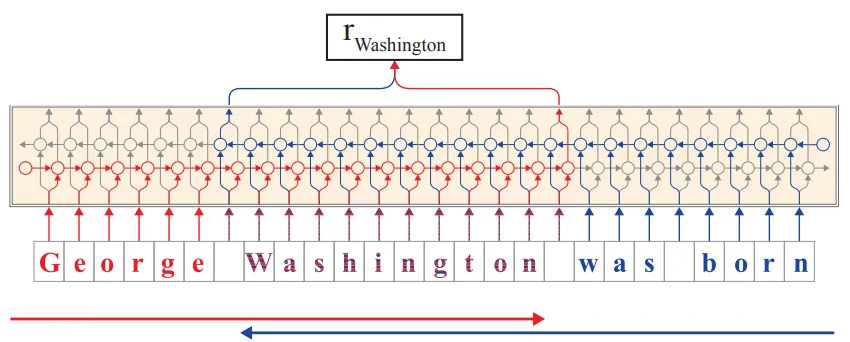

语境嵌入的出现

随着 BERT(来自变换器的双向编码器表征)等模型的发展,突破性进展出现了,它引入了上下文嵌入的概念。与前者不同的是,BERT 生成的嵌入会根据周围的文本进行动态调整,从而捕捉不同语境中单词的细微含义。这是通过转换器架构实现的,该架构采用注意机制来权衡句子或段落中每个单词的影响。

技术机制与创新

上下文嵌入是通过在大量文本语料库中训练的深度学习模型生成的。这些模型旨在根据上下文预测单词(这一任务被称为掩码语言建模)或预测句子之间的关系。训练过程使模型能够为每个单词学习丰富的、对上下文敏感的表征。因此,同一个词可以根据不同的用法有不同的嵌入,从而捕捉其各种语义上的细微差别。

对自然语言处理的影响

上下文嵌入的引入对 NLP 产生了变革性的影响。情感分析、命名实体识别和问题解答等严重依赖理解上下文的任务,其准确率都有了大幅提高。通过上下文嵌入,模型可以有效地消歧单词、理解成语表达、把握含义的细微差别,从而实现更复杂、更细致的语言理解。

挑战与未来方向

尽管具有优势,情境嵌入并非没有挑战。它们需要大量的计算资源来进行训练和推理,这限制了它们的可及性。此外,这些模型的复杂性也会给解释和分析带来困难。未来的研究可能会侧重于使这些模型更加高效、可解释,并能处理更加复杂和微妙的语言现象。

代码

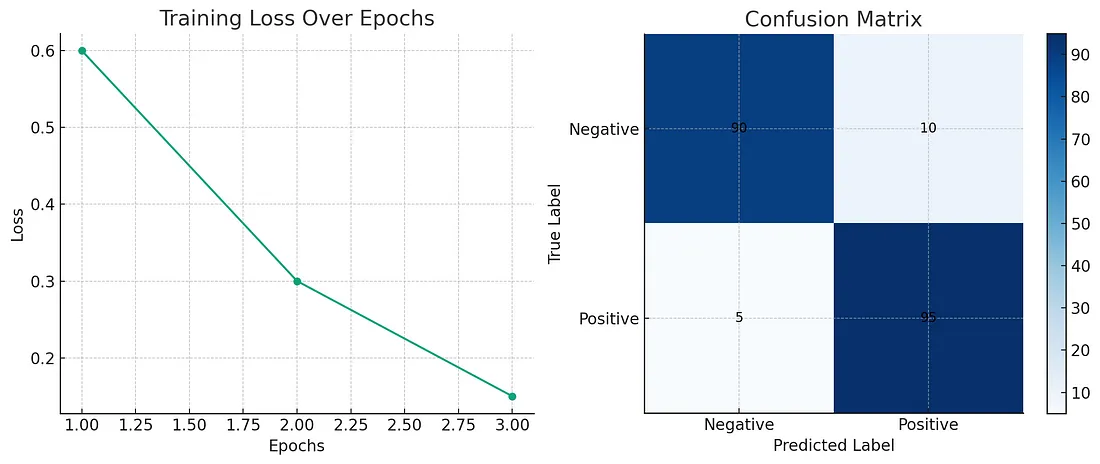

为了用一个完整的 Python 示例来演示上下文嵌入,我们将使用一个合成数据集和 BERT 模型作为上下文嵌入的示例。我们将对该数据集进行情感分析,然后使用 BERT 进行特征工程、模型训练,并使用适当的指标和图表进行评估。以下是我们可以采用的结构:

- 生成一个用于情感分析的合成数据集。

- 加载预训练的 BERT 模型并标记数据。

- 使用 BERT 嵌入训练分类器。

- 评估模型并将结果可视化。

让我们把这些内容放在一个代码块中:

import torch

from torch.utils.data import DataLoader, Dataset

from transformers import BertTokenizer, BertForSequenceClassification

from torch.optim import AdamW # Use PyTorch's AdamW

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report, confusion_matrix, accuracy_score

import matplotlib.pyplot as plt

import pandas as pd

# 1. Generate a synthetic dataset

data = {'text': ['good product', 'bad product', 'excellent quality', 'poor quality', 'love it', 'hate it']*100,

'label': [1, 0, 1, 0, 1, 0]*100}

df = pd.DataFrame(data)

# Split the dataset into training and testing sets

train_texts, test_texts, train_labels, test_labels = train_test_split(df['text'], df['label'], test_size=0.2)

# 2. Load a pre-trained BERT model and tokenizer

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertForSequenceClassification.from_pretrained(model_name, num_labels=2)

# Tokenization and DataLoader preparation

class TextDataset(Dataset):

def __init__(self, texts, labels, tokenizer):

self.texts = texts.tolist() # Ensure it's a list

self.labels = labels.tolist() # Ensure it's a list

self.tokenizer = tokenizer

def __len__(self):

return len(self.texts)

def __getitem__(self, idx):

text = self.texts[idx]

inputs = self.tokenizer(text, padding='max_length', truncation=True, max_length=512, return_tensors="pt")

input_ids = inputs['input_ids'].squeeze()

attention_mask = inputs['attention_mask'].squeeze()

label = torch.tensor(self.labels[idx])

return input_ids, attention_mask, label

train_dataset = TextDataset(train_texts, train_labels, tokenizer)

test_dataset = TextDataset(test_texts, test_labels, tokenizer)

train_loader = DataLoader(train_dataset, batch_size=16, shuffle=True)

test_loader = DataLoader(test_dataset, batch_size=16, shuffle=False)

# 3. Train the classifier

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

optimizer = AdamW(model.parameters(), lr=2e-5)

for epoch in range(3): # Train the model for 3 epochs

model.train()

for input_ids, attention_mask, labels in train_loader:

input_ids = input_ids.to(device)

attention_mask = attention_mask.to(device)

labels = labels.to(device)

optimizer.zero_grad()

outputs = model(input_ids, attention_mask=attention_mask, labels=labels)

loss = outputs.loss

loss.backward()

optimizer.step()

print(f"Epoch {epoch+1}, Loss: {loss.item()}")

# 4. Evaluate the model

model.eval()

predictions = []

with torch.no_grad():

for input_ids, attention_mask, _ in test_loader:

input_ids = input_ids.to(device)

attention_mask = attention_mask.to(device)

outputs = model(input_ids, attention_mask=attention_mask)

preds = outputs.logits.argmax(axis=1)

predictions.extend(preds.cpu().numpy())

print(classification_report(test_labels, predictions))

# Plot confusion matrix

cm = confusion_matrix(test_labels, predictions)

plt.figure(figsize=(5,5))

plt.imshow(cm, cmap='Blues')

plt.xlabel("Predicted labels")

plt.ylabel("True labels")

plt.xticks(np.arange(2), ['Negative', 'Positive'])

plt.yticks(np.arange(2), ['Negative', 'Positive'])

plt.colorbar()

plt.show()

# Accuracy

accuracy = accuracy_score(test_labels, predictions)

print(f"Accuracy: {accuracy}")

该代码包括生成一个合成数据集、加载一个用于上下文嵌入的 BERT 模型、训练一个情感分析分类器,以及通过度量和绘图对模型进行评估。最后的解释有助于我们了解模型的性能和上下文嵌入的有效性。

结论

上下文嵌入是 NLP 领域的一个里程碑,它提供了对语言的动态和细致入微的理解。提供对上下文敏感的单词表征使机器对人类语言的理解取得了长足进步。随着研究的不断深入,我们可以预见,更复杂的模型将继续推动机器在语言处理方面的理解和成就。