微软Azure AI推出创新安全功能,提升客户模型使用安全性与便利性

微软首席产品官Sarah Bird在接受《The Verge》采访时透露,她的团队设计了一系列新的安全功能,这些功能专为Azure客户打造,使其即便不雇佣红队也能轻松测试其构建的AI服务。微软表示,这些基于大型语言模型(LLM)的工具能够检测潜在漏洞,监控那些看似合理却无依据的幻觉,并实时阻止Azure AI平台上任何模型中的恶意提示。

Bird解释道:“我们深知,并非所有客户都具备深入了解提示注入攻击或不良内容的专业知识。因此,我们的评估系统会自动生成模拟这些攻击所需的提示,客户随后可以获取分数并查看结果。”

这些创新功能有助于解决由不受欢迎或意外回应引发的生成式AI争议,例如近期出现的明星伪造图像(如微软设计师图像生成器产生的)、历史不准确的画面(如Google Gemini的失误)或荒诞的搜索结果(如Bing上的马里奥驾驶飞机冲向双子塔)。

目前,Azure AI已推出三个预览版功能:

- 提示屏蔽:防止外部文档中的恶意提示或注入的提示,确保模型不会违背其训练目的。

- 稳定性检测:识别并消除可能导致幻觉的不稳定因素。

- 安全评估:全面评估模型的漏洞,提升整体安全性。

此外,微软还计划很快推出两项新功能,旨在引导模型输出安全内容,并跟踪提示以识别潜在的问题用户。

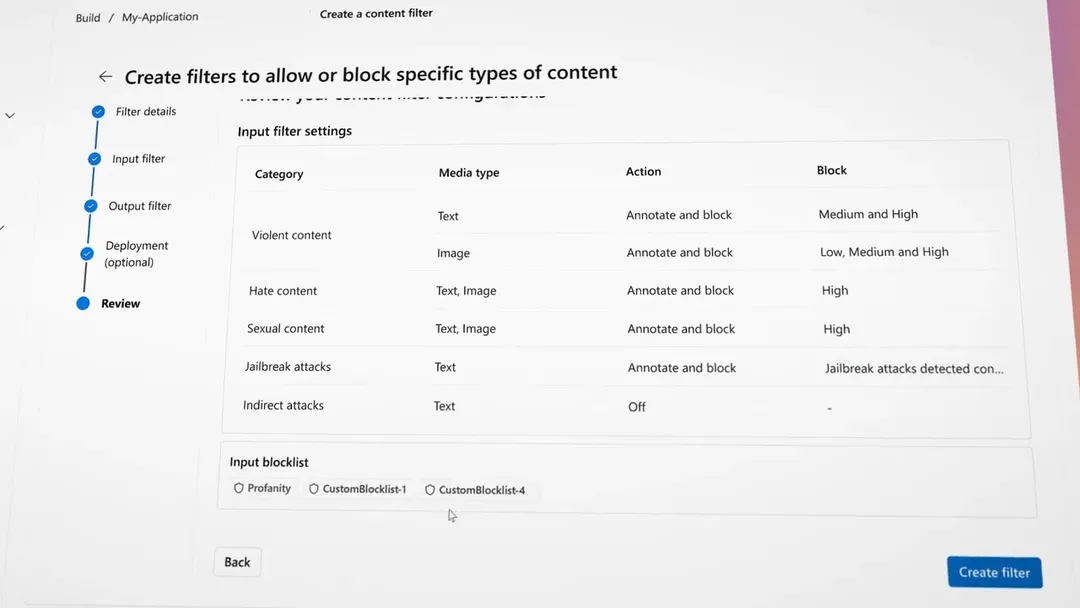

在Azure AI Studio中,内容过滤设置提供了强大的支持。这些设置能够防止提示攻击和不适宜内容的出现,并决定在遇到问题时如何处理。无论是用户输入的提示还是模型正在处理的第三方数据,监控系统都会进行仔细评估,确保没有触发任何禁用词汇或隐藏提示,然后才会将其发送给模型进行回答。此外,系统还会对模型的响应进行审查,确保模型没有产生任何文档或提示中未提及的信息。

关于Google Gemini图像的争议,其旨在减少偏见的过滤器意外产生了不良影响,这也正是微软Azure AI工具希望提供更精细化控制的领域。Bird承认,外界对于微软和其他公司可能决定AI模型适宜性的担忧是合理的,因此她的团队为Azure客户提供了一种方法,可以切换模型所见并阻止的仇恨言论或暴力内容。

未来,Azure用户还将能够获取关于试图触发不安全输出的用户报告。Bird表示,这将有助于系统管理员区分哪些是公司的红队成员,哪些是可能具有恶意意图的用户。

值得一提的是,这些安全功能已经能够直接应用于GPT-4和其他流行模型(如Llama 2)。然而,由于Azure的模型库包含众多AI模型,那些使用较小或不常用的开源系统的用户可能需要手动将这些安全功能指向他们的特定模型。

微软一直在积极利用AI技术增强其软件的安全性,特别是在越来越多客户对使用Azure访问AI模型表现出浓厚兴趣的背景下。同时,该公司还致力于扩大其强大AI模型的数量,最近更是与法国AI公司Mistral达成独家协议,在Azure平台上提供Mistral Large模型。