AI新框架ToXCL:检测并解释隐性毒性言论

在社交媒体上,有毒言论可以像野火一样蔓延,针对个人和边缘群体。虽然明显的仇恨言论相对容易标记,但隐性毒性——它依赖于刻板印象和编码语言而不是公然辱骂——却构成了更棘手的挑战。我们如何训练人工智能系统不仅检测这种隐性的毒性,还要解释为什么它是有害的?

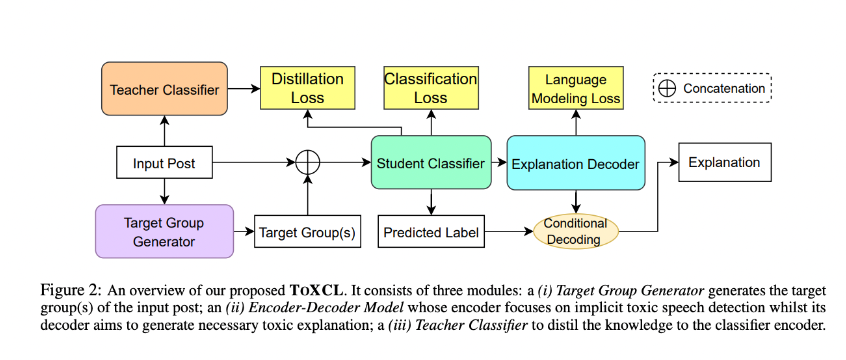

新加坡南洋理工大学、新加坡国立大学和信息通信研究院的研究人员正面应对了这一挑战,提出了一种名为ToXCL的新型框架,其概述如图2所示。与以前将检测和解释整合到一个文本生成任务中的系统不同,ToXCL采用多模块方法,将问题分解成几个步骤。

首先,有一个目标群体生成器——一个文本生成模型,用于识别特定帖子中可能针对的少数群体。接下来是编码器-解码器模型,它首先使用其编码器将帖子分类为有毒或无毒。如果被标记为有毒,解码器则会在目标群体信息的帮助下生成一个解释,说明为什么它有问题。

但这里有一个巧妙之处:为了增强编码器的检测技能,研究人员引入了一个强大的教师分类器。使用知识蒸馏技术,这个教师模型在训练过程中将其专业知识传授给编码器,从而提高了其分类能力。

研究人员还添加了一个条件解码约束——这是一个巧妙的技巧,确保解码器只为被分类为有毒的帖子生成解释,从而消除了相互矛盾的输出。

那么它的表现如何呢?在两个主要的隐性毒性基准测试中,ToXCL的表现优于最先进的基线模型,甚至超过了仅专注于检测或解释的模型。与其他领先的系统相比,人类评估员对其输出的正确性、流畅性和减少有害性的评分更高。

当然,仍有改进的空间。该模型有时会在需要外部知识的编码符号或缩写上出错。而隐性毒性的主观性意味着“正确”的解释通常是多方面的。但总体而言,ToXCL标志着人工智能系统在识别隐性仇恨和阐明其有害影响方面迈出了令人印象深刻的一步。随着这项技术的进一步发展,我们还必须应对可能存在的风险,如强化偏见或生成有毒语言本身。但只要我们小心谨慎,它就能为增强边缘化群体的声音和遏制网络上的压迫性言论提供一条道路。