OctoAI推出OctoStack平台简化企业AI模型托管

OctoAI公司推出了OctoStack软件平台,该平台使公司能够在其内部基础设施上托管人工智能模型。

许多大型语言模型都是通过基于云的应用程序接口交付的。这些模型托管在各自开发者的基础设施上,这要求客户将他们的数据发送到该基础设施进行处理。在内部硬件上托管神经网络就无需将数据共享给外部供应商,这可以简化企业的网络安全和法规遵从性。

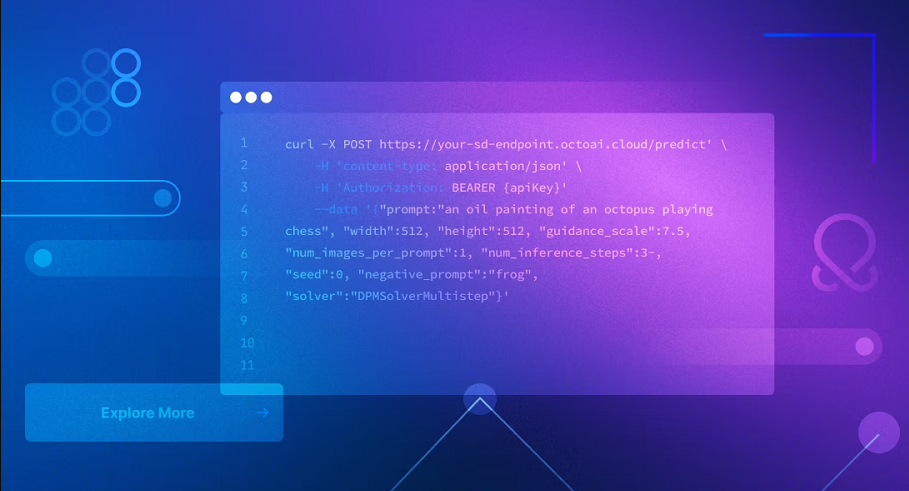

OctoAI表示,其新推出的OctoStack平台使得在公司内部基础设施上托管AI模型变得更加容易。该平台可以在内部硬件、主要公共云以及AI优化的基础设施即服务平台(如CoreWeave)上运行。OctoStack同样适用于Nvidia公司和Advanced Micro Devices公司的多款AI加速器,以及亚马逊网络服务中可用的AWS Inferentia芯片。

该平台部分基于OctoAI创始人开发的开源技术Apache TVM。Apache TVM是一个编译器框架,可以简化优化AI模型以在多个芯片上运行的任务。

在创建神经网络的初始版本后,开发人员可以通过多种方式优化它以提升性能。一种技术称为运算符融合,它能够将AI执行的一些计算压缩成更少的、更高效的硬件计算。另一种技术称为量化,它减少了神经网络产生准确结果所需处理的数据量。

这些优化并不总是适用于不同类型的硬件。因此,针对一块显卡优化的AI模型在另一个芯片制造商的处理器上并不一定能够高效运行。OctoStack所采用的开源技术TVM可以自动化针对不同芯片优化神经网络的过程。

OctoAI表示,其平台可以帮助客户更高效地运行其AI基础设施。据该公司称,与从头开始构建的AI集群相比,由OctoStack驱动的推理环境可使显卡利用率提高四倍。该公司还承诺将运营成本降低50%。

OctoAI联合创始人兼首席执行官路易斯·塞泽表示:“帮助客户构建可行且面向未来的生成式AI应用程序,不仅需要经济实惠的云推理,还需要硬件可移植性、模型集成、微调、优化、负载均衡等全方位的解决方案。这些都是需要全方位解决方案的全栈问题。”

OctoStack支持流行的开源LLM,如Meta Platforms Inc.的Llama和初创公司Mistral AI开发的Mixtral混合专家模型。公司还可以运行内部开发的神经网络。据OctoAI称,OctoStack使得能够在推理环境中随着时间的推移更新AI模型,而无需对其支持的应用程序进行重大更改。