苹果推出MobileCLIP:高效移动设备AI图像文本模型

苹果持续深化并拓展设备端AI的边界,其最新研究成果是MobileCLIP,这是一种专为移动设备性能优化而设计的高效图像文本模型系列。同时,他们还引入了一种新型多模态强化训练方法,通过知识迁移显著提升了学习效率。

大型图像文本基础模型,如CLIP,在各种任务中展现出了令人惊叹的零样本性能及增强的鲁棒性。然而,将这些模型部署到移动设备上却是一项挑战,因为它们体积庞大且响应时间较长。

MobileCLIP模型采用混合CNN-transformer架构,在图像和文本编码器中进行了结构重参数化,从而大大减少了模型大小和响应时间。新模型包括S0、S1、S2和B等多种变体,满足了不同移动应用对于大小和响应时间的多样化需求。

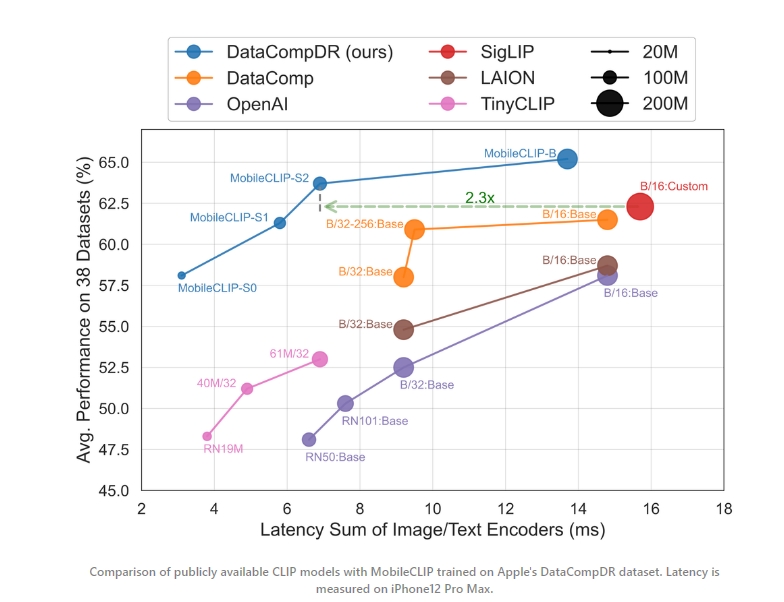

其中,最小的变体在零样本性能上与OpenAI的ViT-B/16模型相近,但速度却提升了4.8倍,大小也缩小了2.8倍。而MobileCLIP-S2在平均零样本性能上超过了SigLIP的ViT-B/16模型,速度提升了2.3倍,大小缩小了2.1倍,同时使用的训练样本数量还减少了3倍。至于MobileCLIP-B(LT),它在ImageNet上的零样本性能达到了77.2%,这一成绩显著优于具有相似架构的近期工作,如DFN和SigLIP,甚至超过了OpenAI的ViT-L/14@336。

为了进一步提高MobileCLIP模型的学习效率,苹果推出了一种新的训练策略——多模态强化训练。这种策略融合了从预训练图像字幕模型和一系列强大的CLIP模型中迁移的知识。通过将额外知识存储在强化数据集中,这种方法避免了训练时的计算开销。

这个强化的数据集被称为DataCompDR,它有两种变体:DataCompDR-12M和DataCompDR-1B。与标准的CLIP训练相比,使用DataCompDR进行训练可以显著提升学习效率,提升幅度高达10-1000倍。例如,利用DataCompDR-12M,基于ViT-B/16的CLIP模型可以在大约一天内,使用单个节点上的8×A100 GPU,在ImageNet-val上实现61.7%的零样本分类。

MobileCLIP的核心在于其图像和文本编码器的混合CNN-transformer架构。在图像编码器方面,他们引入了MCi架构——一个基于最近FastViT模型的改进型混合视觉变换器。关键优化措施包括减少前馈块中的MLP扩展比,并增加模型深度以提高参数效率。

在文本编码方面,苹果开发了Text-RepMixer——一个卷积令牌混合器。它能够实现训练时和推理时架构的解耦。通过策略性地用卷积块替换自注意力层,Text-RepMixer在保持与纯变换器模型相似精度的同时,实现了更小的体积和更快的速度。

多模态强化训练的关键创新在于其能够迁移从图像字幕模型和一系列预训练的CLIP模型中获取的知识。这种方法受到了离线知识蒸馏技术的启发,避免了在训练期间运行大型教师模型的计算开销。相反,它将额外知识存储在强化的数据集中,从而提高了训练效率。

这项研究具有深远的影响,尤其是对于即将推出的iPhone等消费设备来说。MobileCLIP等设备上AI技术的运用,意味着更智能的图像搜索、实时视觉查找、更精确的物体检测以及新颖的增强现实体验等功能可以在无需网络连接的情况下无缝运行。想象一下,你使用iPhone摄像头或Vision Pro对准一个陌生的植物或地标,并立即获取相关信息,所有这些信息都在你的设备上本地处理,以实现最快的速度和最高的隐私保护。

鉴于苹果在移动设备AI模型领域的持续研究与创新,我们有望在今年晚些时候在其消费设备上见证新一代智能、响应迅速且注重隐私保护的用户体验。先进的计算机视觉和语言理解能力可能将成为标准功能,并与专用的AI硬件协同工作。这让我们瞥见了未来的美好愿景,即强大的AI不再局限于云端,而是融入了我们每天随身携带的设备中。