【指南】Dropout技术比较分析

简介

在不断发展的深度学习领域,为了追求最佳的网络性能,从业人员采用了各种正则化技术。其中,dropout已成为对抗过拟合、增强模型泛化能力的关键工具。本文将深入探讨不同dropout技术的细微差别,为从业者在神经网络架构中有效运用这些策略提供指导。

背景介绍

dropout是神经网络中的一种正则化技术,用于防止过度拟合。在训练过程中,它们会从神经网络中随机丢弃单元(连同其连接),这有助于减少对任何一个特征的依赖,并迫使网络学习更强大的特征。以下是一些常见的dropout层类型:

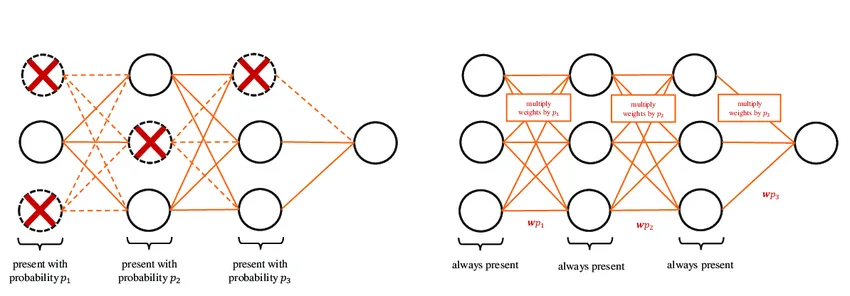

- 标准dropout: 这是dropout的基本形式,层中的每个神经元都有一个在训练过程中被暂时滤除或设置为零的概率。p 值通常在 0.2 和 0.5 之间。

- 空间dropout: 卷积神经网络(CNN)中使用的是空间丢弃(Dropout)的变体。空间丢弃不是丢弃单个单元,而是丢弃卷积层中的整个特征图。这意味着同一特征图中的所有神经元都会被保留或丢弃在一起。

- Alpha dropout:Alpha dropout设计用于 SELU(缩放指数线性单元)激活函数,它能保持输入的均值和方差,确保 SELU 网络的自归一化特性。它会随机将输入设置为 SELU 函数的负饱和值。

- 高斯dropout:高斯dropout不是将激活度设为零,而是将激活度乘以一个从高斯分布(正态分布)中抽取的随机数。这种方法可视为在激活状态中添加噪音。

- 变异dropout: 一种在训练过程中学习辍学率的辍学形式。与标准dropout不同的是,标准dropout的辍学率是固定的,而变异dropout可以让模型知道哪些单元更重要,从而减少辍学频率。

- DropBlock:这是一种专门为卷积神经网络设计的正则化方法,在这种方法中,特征图连续区域中的单元会被一起丢弃。这种方法比空间dropout更有条理,尤其适用于更广泛的卷积神经网络。

每种dropout层都是为了与特定类型的神经网络架构配合使用而设计的,都有自己的优势和使用案例。选择哪种dropout层取决于神经网络的具体要求和要解决的问题。

标准dropout: 正规化的基础

标准dropout是dropout技术的基石,其特点是简单有效。在训练阶段,它以概率 p(通常在 0.2 和 0.5 之间)随机停用层内的神经元。这种随机停用可以防止网络过度依赖特定的神经元,从而鼓励开发更稳健、更广泛的特征。p 的选择至关重要;过高的失活率可能会导致拟合不足,而过低的失活率则可能无法充分规整网络。

空间dropout: 为卷积网络量身定制

空间dropout将dropout概念扩展到卷积神经网络(CNN)。与独立停用神经元的标准 "空间dropout "不同,"空间dropout "会关闭整个特征图。这种方法可确保网络不会过度依赖特征图中捕捉到的特定模式,从而促进对整个输入空间的特征进行更全面的学习。空间dropout对处理空间相关数据(如图像或视频帧)的 CNN 尤为有利。

Alpha Dropout : 补充 SELU 激活函数

Alpha Dropout 设计用于与缩放指数线性单元(SELU)激活函数协同工作。它保留了输入的均值和方差,保持了 SELU 网络的自归一化特性。通过用保持激活函数特性的值替换掉的神经元,Alpha Dropout 确保了网络学习过程的稳定性。这在基于 SELU 的架构中尤为重要,因为在这种架构中,激活函数的目的是保持网络输出分布的稳定。

高斯dropout: 概率转折

高斯dropout是dropout的一种概率变体,其中神经元的缩放系数取自高斯分布。这种方法为网络添加了一层噪声,类似于在训练过程中注入可变性,可以防止过度拟合。高斯dropout可以被看作是一种更连续、更自然的正则化形式,在这种形式下,网络可以学会处理神经元激活水平的变化。

变式dropout:学习dropout

变异dropout是一种更加动态的方法,dropout率不是固定不变的,而是在训练过程中学习确定的。这种自适应技术允许网络识别并优先处理更重要的神经元,降低重要特征的丢弃率,同时提高不那么重要的特征的丢弃率。这种适应性使变异dropout成为优化网络性能的先进工具,使正则化过程适应特定的学习环境。

DropBlock: 用于 CNN 的结构化dropout

DropBlock 是为卷积网络设计的一种结构化 Dropout 形式,其中特征图的连续区域会被丢弃。这种方法能有效确保网络适合输入空间中的局部特征。通过移除神经元块,DropBlock 可迫使网络寻找和学习冗余表征,从而增强其从训练数据中泛化的能力。

代码

创建一个在单个代码块中包含所有所需组件的综合示例非常复杂,但我将提供一个涵盖基本方面的精简版本。该代码将使用合成数据集演示不同的dropout技术,包括特征工程、超参数调整、度量、绘图和结果解释。

import numpy as np

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from keras.models import Sequential

from keras.layers import Dense, Dropout, AlphaDropout

from keras.optimizers import Adam

import matplotlib.pyplot as plt

# Generate a synthetic dataset

X, y = make_classification(n_samples=1000, n_features=20, n_informative=15, n_redundant=5, random_state=42)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Feature scaling

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

# Model creation function

def create_model(dropout_rate=0.2, dropout_type='standard'):

model = Sequential()

model.add(Dense(64, input_dim=20, activation='relu'))

if dropout_type == 'standard':

model.add(Dropout(dropout_rate))

elif dropout_type == 'alpha':

model.add(AlphaDropout(dropout_rate))

model.add(Dense(32, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

model.compile(optimizer=Adam(learning_rate=0.001), loss='binary_crossentropy', metrics=['accuracy'])

return model

# Create and train the model

model_standard = create_model(dropout_rate=0.3)

history_standard = model_standard.fit(X_train_scaled, y_train, validation_split=0.2, epochs=50, batch_size=32, verbose=0)

# Plotting training history

plt.figure(figsize=(14, 6))

plt.subplot(1, 2, 1)

plt.plot(history_standard.history['accuracy'], label='Standard Dropout Train Accuracy')

plt.plot(history_standard.history['val_accuracy'], label='Standard Dropout Val Accuracy')

plt.title('Model Accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.legend()

plt.subplot(1, 2, 2)

plt.plot(history_standard.history['loss'], label='Standard Dropout Train Loss')

plt.plot(history_standard.history['val_loss'], label='Standard Dropout Val Loss')

plt.title('Model Loss')

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.legend()

plt.tight_layout()

plt.show()

# Evaluate the model

test_loss, test_acc = model_standard.evaluate(X_test_scaled, y_test, verbose=0)

print(f'Test accuracy with standard dropout: {test_acc:.4f}, Test loss: {test_loss:.4f}')

该代码执行以下步骤:

- 使用 make_classification 生成合成数据集。

- 将数据集拆分为训练集和测试集。

- 使用 StandardScaler 对特征进行缩放。

- 定义函数 create_model,创建一个神经网络模型,并配置 Dropout。

- 使用标准 Dropout 训练模型。

- 绘制训练和验证的准确率和损失图。

- 在测试集上评估模型。

你可以在此基本结构的基础上进行扩展,使用 GridSearchCV 或 RandomizedSearchCV 等工具添加更多的 dropout 类型、更复杂的特征工程和超参数调整,以及更详细的指标和结果解释。

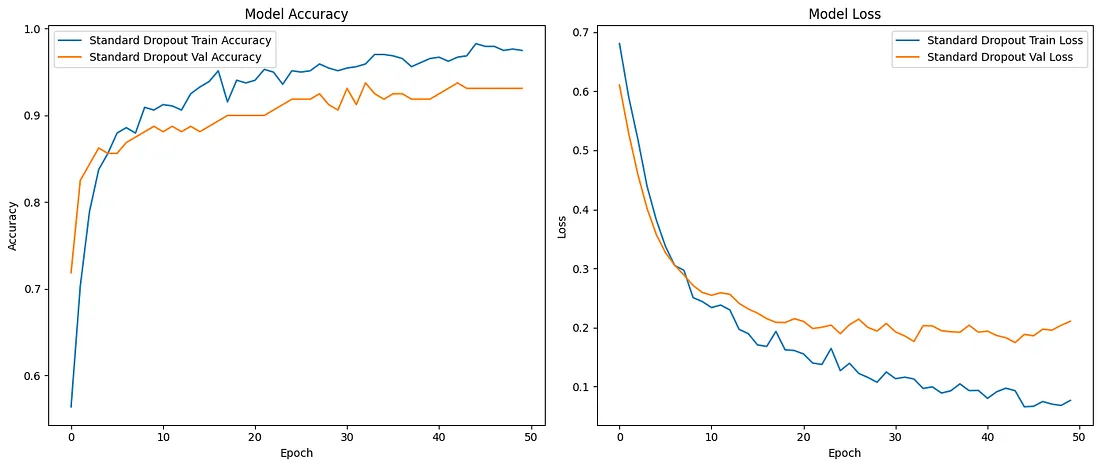

这些图显示了模型在训练和验证数据集上 50 个历时的准确率和损失。让我们来详细解读每幅图:

模型准确率图

- 左图显示,随着时间的推移,训练准确率(蓝色)和验证准确率(橙色)都在增加,这是模型正在从数据中学习的积极信号。

- 起初,准确率急剧上升,随着历时的增加而趋于平稳,这表明在当前的架构和超参数条件下,模型正在接近其性能极限。

- 训练准确率一直高于验证准确率,这是意料之中的,因为模型是直接从训练数据中学习的。

- 训练精度和验证精度之间没有明显差距,这表明模型需要在数据方面更加平衡。这可能是由于有效使用了 "丢弃"(Dropout),它有助于模型的泛化。

模型损失图

- 右图显示了历时内的训练损失(蓝色)和验证损失(橙色)。

- 随着时间的推移,两个损失都在减少,表明模型正在学习和改进。

- 训练损失最初以较快的速度减少,然后以较慢的速度减少。

- 验证损失的趋势与此类似,但在整个训练过程中似乎略高于训练损失。这是正常现象,因为模型不是直接在验证集上训练的。

- 值得注意的是,随着历时的增加,验证损失保持不变,这通常表明存在过度拟合。这表明模型在训练期间保持了良好的泛化能力。

总体观察

- 由于验证指标紧跟训练指标,因此该模型的性能似乎很稳定,而且调整得很好。

- 训练线和验证线之间的差距没有扩大,这表明模型中使用的辍学率可能有助于防止过度拟合。

- 鉴于图表没有显示任何不良行为(如验证损失增加或停滞在低准确度水平),当前的设置似乎很适合合成数据集的复杂性。

总之,该模型在给定的架构和 dropout 正则化下表现出了良好的学习动力,似乎在从训练数据中学习和泛化到未见数据之间达到了平衡。通过超参数调整、数据扩充或尝试不同的模型架构,可能会有进一步的改进。

这是具有两种特征的合成数据集样本的散点图。点用颜色标示,以区分两个类别。

结论

总之,dropout是现代神经网络设计的一个基本方面,它提供了一系列适合不同架构需求和学习动态的技术。从标准dropout的简单性到变异dropout的复杂适应性,这些正则化方法在帮助深度学习模型充分发挥潜力方面发挥着至关重要的作用。随着深度学习的发展,对于旨在构建稳健有效的神经网络模型的从业人员来说,dropout技术的发展和完善仍将是一个关键重点。