Hugging Face发布强大的Idefics2多模态模型

Hugging Face发布了功能强大的Idefics2模型,它不仅能理解和生成基于图像和文本的文本响应,而且在视觉问答、视觉内容描述、图像故事创作、文档信息提取以及基于视觉输入的算术运算等方面都达到了新的高度。

相比其前身Idefics1,Idefics2实现了飞跃式的进步,它凭借仅80亿的参数和开放的Apache 2.0许可,展现了出色的通用性,同时还显著增强了光学字符识别(OCR)功能。

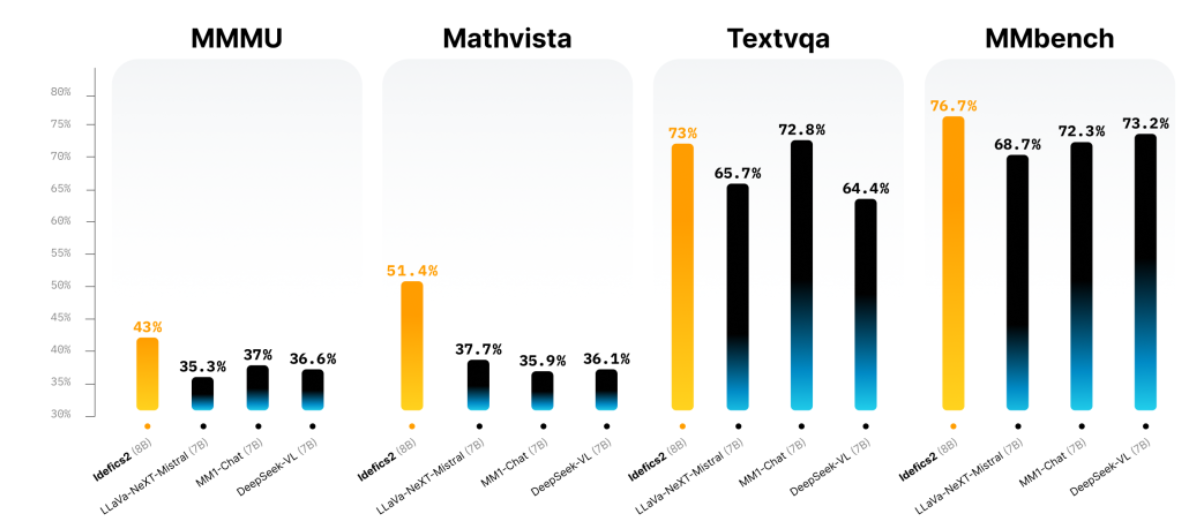

在视觉问答基准测试中,Idefics2展现出了令人瞩目的性能,甚至与更大规模的模型如LLava-Next-34B和MM1-30B-chat相比也毫不逊色。

值得一提的是,Idefics2从一开始就与Hugging Face的Transformers实现了集成,这使得对各类多模态应用的微调变得轻而易举。对于希望深入研究的人来说,Hugging Face Hub上已经提供了可供实验的模型。

Idefics2的训练理念非常全面,它融合了多种公开可用的数据集,包括网页文档、图像-字幕对和OCR数据等。此外,它还引入了一个名为“The Cauldron”的创新微调数据集,该数据集融合了50个精心策划的数据集,旨在实现更全面的对话训练。

在图像处理方面,Idefics2采用了更加精细的方法,它保持了图像的原生分辨率和纵横比,这与传统的计算机视觉调整大小规范有着显著的区别。其架构受益于先进的OCR功能,能够熟练地识别图像和文档中的文本内容,并在解析图表和图形方面展现出卓越的性能。

通过将视觉特征融入语言基础,Idefics2实现了对其前身架构的改进,采用了学习的Perceiver池化和MLP模态投影,从而提升了整体效率。

这一视觉-语言模型的进步为探索多模态交互提供了全新的途径,使Idefics2有望成为该领域的基础工具。其性能提升和技术创新充分展示了将视觉和文本数据相结合,创建复杂、上下文感知的AI系统的巨大潜力。