AI2更新OLMo模型,采用Dolma 1.7数据集

近期,艾伦人工智能研究所(AI2)宣布对其拥有70亿参数的开放语言模型OLMo 1.7-7B进行了更新。这次更新中,该人工智能采用了更为广泛和多样化的Dolma数据集,并对教育过程进行了改进。

OLMo模型于今年2月首次发布,被誉为“一个真正开源、技术领先的大型语言模型”。其完整的框架包括了预训练数据、训练代码、模型权重以及评估,为研究者提供了丰富的资源。

从Dolma 1.5到1.7

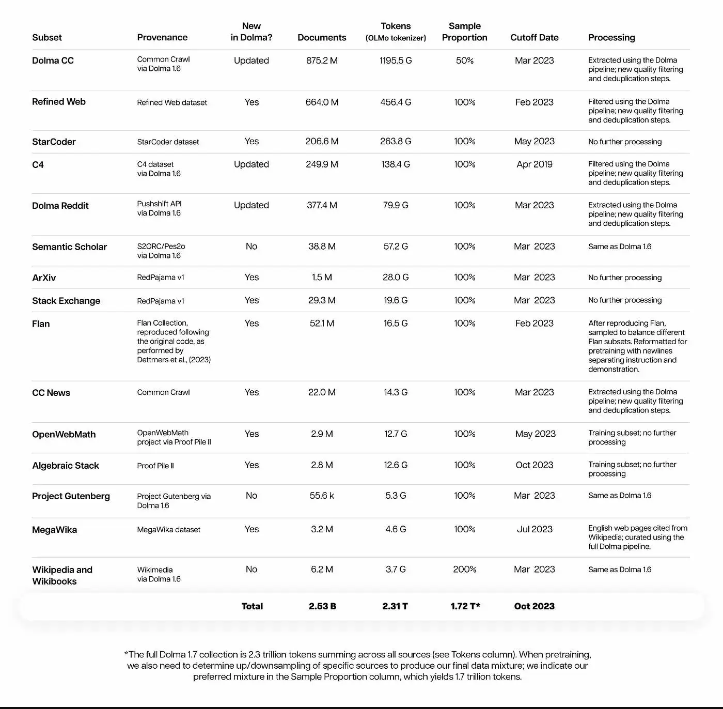

此次更新使得OLMo 1.7-7B支持更长的上下文长度,从原先的2048个令牌扩展到了4096个令牌。同时,由于训练过程和架构的改进,其性能也得到了显著提升。在数据集方面,AI2研发了Dolma 1.7,该数据集包含了来自多个渠道的2.3万亿个令牌,涵盖了Dolma CC、精炼网页、StarCoder、C4、Stack Exchange、OpenWebMath、Project Gutenberg、维基百科等多个领域。

相比之前使用的Dolma 1.5,新版本的数据源更加多样化,旨在更好地应对需要专业知识、复杂推理和编码的任务。此外,Dolma 1.7还提供了更为强大的去重功能,通过计算段落级重复得分的长度归一化平均值,有效删除了重复分数超过阈值α的整篇文档。

Dolma 1.7在质量过滤方面也进行了优化。利用FastText分类器,系统能够区分出高质量和低质量的文本。高质量文本通常格式规范,且涵盖了语言模型训练所需的多个有用领域,如维基百科、小型Web RSS源和Semantic Scholar等。而低质量文本则主要包括成人娱乐和假新闻网站等内容。据悉,该分类器是在约25GB的数据上进行训练的,确保了其准确性和可靠性。

在训练过程方面,OLMo 1.7采用了全新的两阶段课程。在第一阶段,研究人员从零开始训练模型,确保其基础性能的稳定性。进入第二阶段后,模型则利用经过筛选的Dolma 1.7子集进行进一步的训练,涉及额外500亿个令牌的处理。同时,在训练过程中,学习率会逐渐降低至0,以优化模型的性能。

AI2表示,通过这些更新,OLMo 1.7-7B在MMLU任务上的表现已经超越了Llama 2-7B,同时在GSM8K任务上也优于Llama-2-13B。

值得一提的是,更新的OLMo模型采用了Apache 2.0许可证,而Dolma 1.7则采用了ODC-BY许可证。目前,这两款产品均已在Hugging Face平台上发布,供广大研究者和开发者使用。