LLaVA:分析图像和文本数据的开源模型

在过去的几个月里,ChatGPT 等各种大型语言模型(LLM)已进入商业市场,许多公司已成功地将 LLM 集成到其产品和服务中,极大地改变了我们与设备和互联网的交互方式。尽管取得了成功,但 LLM 有一个很大的局限性--它们无法摄取和分析图像。

图像是互联网上可用信息的主要组成部分(据估计,在线图像达 7500 亿张)。这些图片蕴含着大量有用的信息,如最新的美食、旅游或时尚趋势,能够从图片中分析和提取洞察力将使我们能够为企业及其客户带来更多价值。在这篇文章中,我们将探讨一个能够同时分析图像和文本数据的开源模型--LLaVA,它于去年 2023 年刚刚发布。

LLaVA LMM 聊天机器人简介

LLaVA 是一个端到端训练有素的大型多模态(LMM)模型,它将 CLIP 视觉编码器与 Vicuna 开源聊天机器人相结合,创建了一个通用的多模态聊天机器人。用户通过输入图像和包含一系列指令的文本提示与 LLaVA 进行交互。然后,LLaVA 将根据指令分析输入的图像,并输出描述图像内容的文本。

LLaVA 的创新研究贡献

LLaVA 论文对 LMM 的发展做出了以下贡献:

- 数据创建过程后的多模式指导。

高质量的数据是创建高性能模型的关键,而缺乏注释数据则是一大障碍。为了克服这一问题,LLaVA 提出了一种新方法,即使用 GPT-4 创建用于训练 LLaVA 的指令跟随图像-文本对。

- LMM 模型架构。

LLaVA 将 CLIP 视觉编码器与 Vicuna 聊天机器人相结合,创建了端到端的多模态管道,表明即使是如此相对简单的设置也能产生最先进的结果。

- LMM 基准。

基准对于验证模型性能至关重要,而具有挑战性的基准更能充分测试模型的能力。LLaVA 引入了两个新的挑战性基准,旨在实现这一目标。

- 开放源代码。

与最近的其他开发成果不同,LLaVA 是开放源代码的,允许公众研究和审查其内容,并开展进一步的工作!

指令跟随图像文本数据生成

由于目前缺乏指令跟读图像文本数据,LLaVA 建议使用(仅文本)GPT-4 生成训练数据。

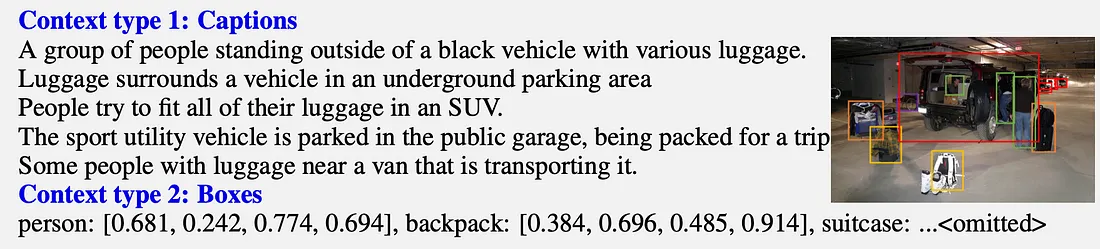

如上图所示,图像通过两种不同类型的符号表示编码成纯文本提示:

- 描述图像中视觉场景的标题、

- 指定图像中物体位置的边界框。

然后,将这些包含图像文本描述的标题和边界框输入纯文本 GPT-4,以创建以下三种不同类型的指令跟随数据来训练 LLaVA。

- 对话:关于图像内容的简单扼要的陈述。

- 详细描述:关于图像内容的详细而冗长的描述。

- 复杂推理:关于图像内容的合理且合乎逻辑的理由。这一步最为复杂,要求模型遵循循序渐进的逻辑推理过程。

下图显示了 GPT-4 根据上述图像创建的三种不同指令数据类型的示例。

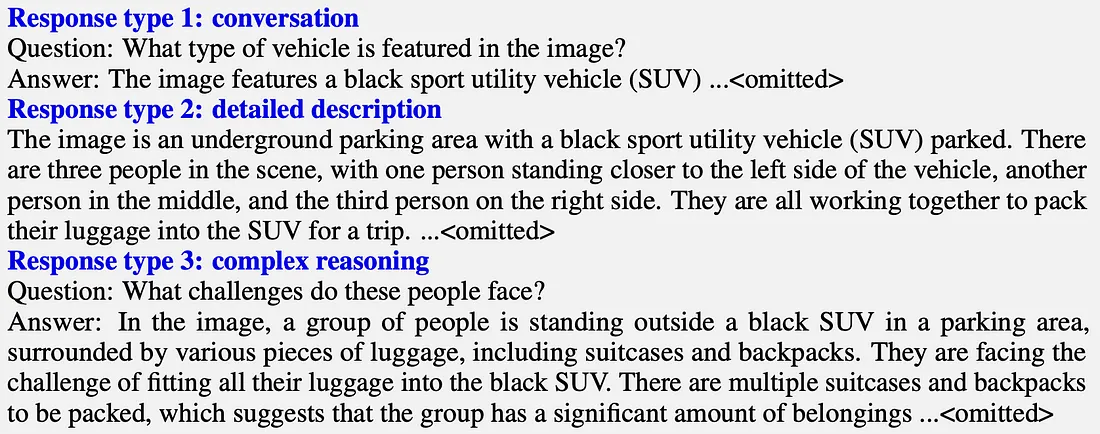

LLaVA 模型架构和训练

LLaVA 通过简单地将视觉编码器与语言模型相结合,创建了端到端的多模态聊天机器人。理论上,只要采取步骤将视觉编码器的标记投射到语言模型的标记空间,任何视觉编码器和语言模型都可以工作。

如上图所示,用户通过输入图像和包含指令的文本提示与 LLaVA 进行交互。文本提示直接由语言模型的标记器进行标记,而图像则首先由视觉编码器进行标记,然后将生成的标记投射到语言模型的空间。

在训练过程中,首先对投影矩阵 W 进行微调,同时冻结语言模型的权重,使视觉编码器与语言模型保持一致。然后对模型进行如下端到端训练:

- 对于每个输入图像,生成一个包含一系列提示和回复的多轮对话。

- 第一个提示包含视觉和文本输入,而随后的提示只包含文本输入。对模型进行训练,使其能够对有关图像的一系列连续文本提示做出响应。

在整个训练过程中,视觉编码器一直处于冻结状态。

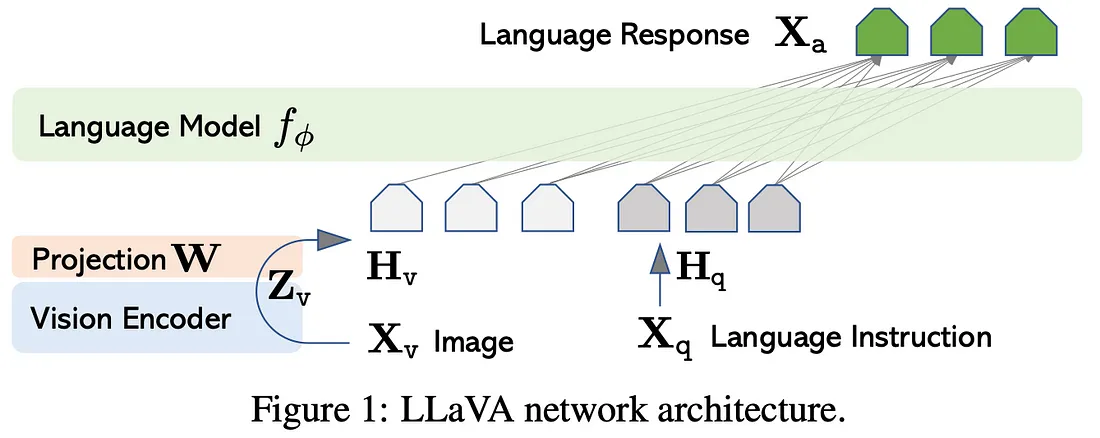

LLaVA 与 SOTA 聊天机器人

尽管 LLaVA 只在一个相对较小的数据集上进行过训练,但我们发现它能够提供与 SOTA 模型相媲美的响应,特别是 LLaVA 能够提供与 GPT-4 类似水平的推理能力。

LLaVA 与 SOTA 聊天机器人

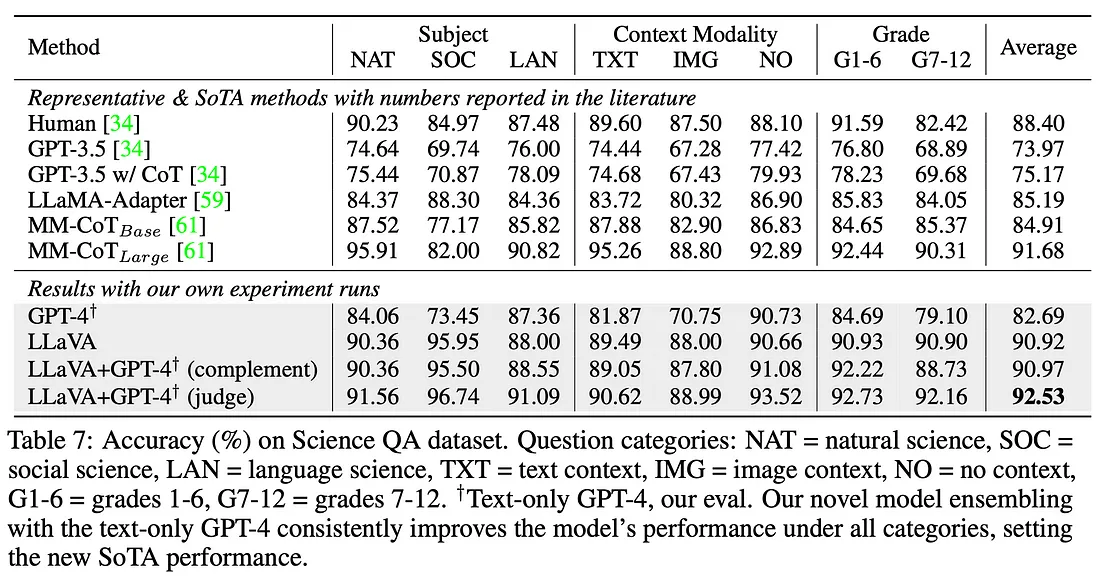

由于很难定量测量聊天机器人对开放式回答的输出,LLaVA 也在科学 QA 数据集上进行了训练和测试,该数据集包含 21,208 道来自小学和高中科学课的多模式多项选择科学问题。该数据集有明确的答案,可以更好地量化回答的准确性。

在科学质量保证数据集上进行微调后,LLaVA 在 GPT-4 判定的文本回复质量方面优于人类和一些 SOTA 模型。此外,当 LLaVA 与 GPT-4 组合在一起时,其性能甚至超过了最好的 SOTA。

在 HuggingFace 上试用 LLaVA

公众可以通过 HuggingFace 空间轻松访问 LLaVA!该空间自带聊天机器人图形用户界面,允许任何人上传图片并开始与 LLaVA 聊天。更令人惊喜的是,该空间由 T4 GPU 驱动,运行时间大大缩短!

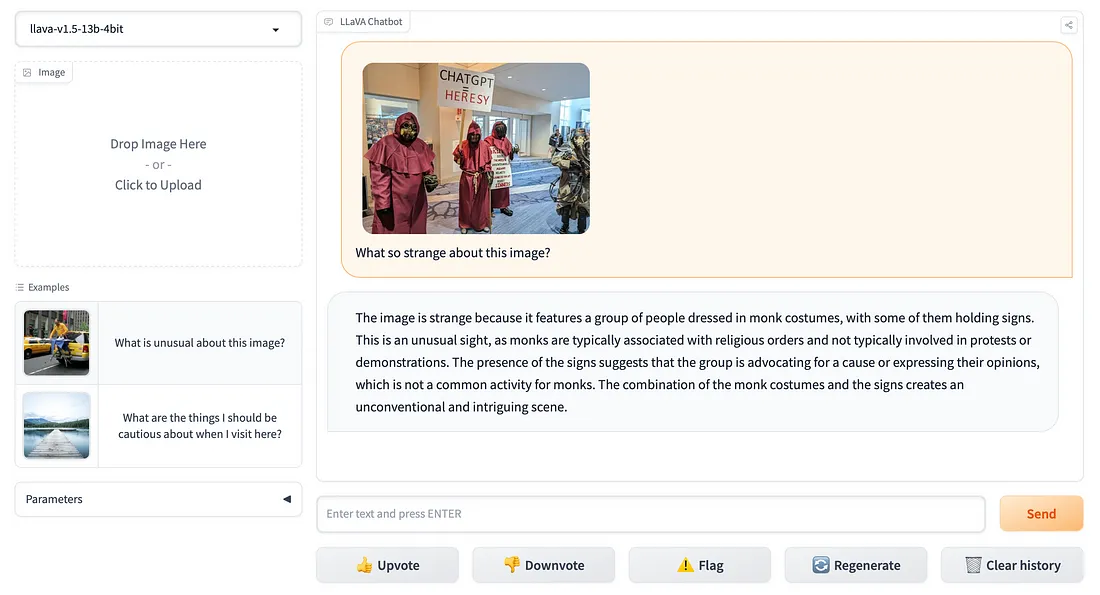

举个例子,让我们问问 LLaVA,下面这张上传到 Reddit 的图片有什么奇怪的地方:

如下图所示,LLaVa 不仅能描述场景的视觉内容,还能对场景的奇怪之处做出合理的逻辑解释。我认为可以肯定地说,不仅 ChatGPT 是异端邪说,LLaVA 也是异端。

LMM 业务使用案例

与 ChatGPT 等 LLM 一样,我们可以期待 LLaVA 等 LMM 改变企业的运营方式。在本节中,我们将提供一些涉及 LLM(如 LLaVA)的可信商业想法。

- 教材中充满了图像和文字。我们可以期待 LMM 进一步改善教职员工和学生的生活质量。例如,学生可以将 LLM 用作学习工具,进一步提高视觉推理能力。

- 目前,安防系统充分利用计算机视觉模型(如物体检测和跟踪)来监控闭路电视摄像机镜头。然而,这些模型的功能极其有限。LMM 将能够利用安全录像生成安全事件报告,从而改进安全流程。

- 社交技术可以帮助无法完全处理周围世界的视障人士(我应该知道--我的一只眼睛部分失明了近两年!)更好地浏览世界。通过在智能手机等智能设备上加载 LLaVA 等 LMM,社交技术公司可以开发导航应用程序和服务,帮助视障人士更好地独立导航和探索世界!

- 文件、社交媒体和新闻网站充满了图形和图像。虽然 LLM 已被用于消化和总结文档内容,但却无法处理图像。LMM 能够处理图像,并将提供重大能力更新,使企业能够全面分析文本和图像内容。

总结

尽管 LLaVA 是在由 GPT-4 生成的小型指令图像-文本数据集上进行训练的,并且是由开源视觉编码器与开源语言模型堆叠而成的,但它在作为聊天机器人和科学推理方面都取得了非常可喜的成果。我们可以预见,在训练数据生成和模型架构方面的新发展将进一步将其能力提升到一个全新的水平。LMM 将像 LLM 一样腾飞,我们可以期待这一领域即将取得的各种进展。未来确实令人兴奋,充满机遇!