苹果发布CoreNet和OpenELM模型助力AI开放研究

苹果公司推出了全新的深度神经网络训练库CoreNet以及先进的开放语言模型系列OpenELM。这些模型现已在Hugging Face hub上公开提供,并且附带了一套完整的框架,用于在公开数据集上进行训练和评估。

CoreNet,可在GitHub上找到,是一款功能强大的工具包,支持多种任务,包括目标检测和语义分割。OpenELM模型,是基于CoreNet构建的,通过优化转换器模型中的参数分配,实现了更高的准确性。目前,苹果已经发布了四个不同参数规模的预训练和指令调整模型,分别是2.7亿、4.5亿、11亿和30亿参数版本。

OpenELM的独特之处在于其独特的分层缩放策略。这种策略在转换器层中,对靠近输入的注意力和前馈模块的潜在维度进行了缩小,随着它们逐渐接近输出而逐渐扩大。这种设计使参数预算的利用更为高效,从而提高了模型的准确性,与现有模型相比具有显著优势。

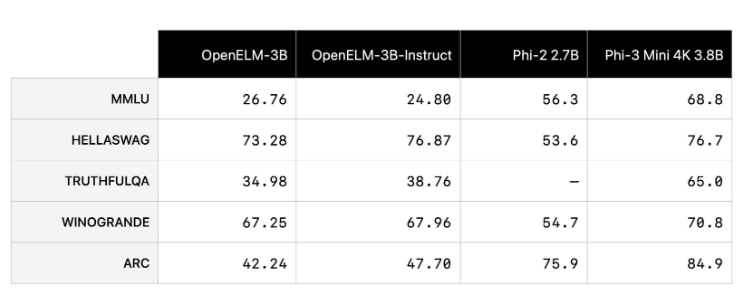

值得一提的是,OpenELM的10亿参数版本在仅需要一半预训练令牌的情况下,性能比类似的OLMo模型高出2.36%,但相比微软最近发布的Phi-3小型语言模型,仍有一定差距。

苹果发布CoreNet和OpenELM,无疑是对开放研究社区的一大贡献,也是这家科技巨头在这一领域的首次尝试。公司不仅公开了模型权重和推理代码,还分享了训练日志、检查点和预训练配置,以便让更多的人能够使用和改进这些模型。此外,苹果还提供了将模型转换为MLX库的代码,使得这些模型能够在苹果设备上实现高效推理和微调。

苹果决定将OpenELM开源,可能受到了谷歌、微软和Meta等同行的影响。这些公司都积极为AI社区贡献出先进的开放模型,受到了广泛的好评。苹果的这一举措,既反映了行业对创新和开放性的需求,也体现了苹果在保持竞争力和行业相关性方面的努力。

另外,苹果对小型参数模型(如OpenELM)的重视,也与其在设备上而非云端运行AI的战略相吻合。这种方式既有助于保护用户隐私,又能实现高效的设备端推理,对苹果的产品和服务生态系统具有重要意义。