通义千问开源千亿参数模型Qwen1.5-110B,基础能力与Chat评估显著提升

2024年04月28日 由 neo 发表

660

0

近日,通义千问团队宣布开源了其首个千亿参数模型——Qwen1.5-110B,该模型在基础能力和Chat评估中展现出卓越表现,相较同类模型有了显著的提升。这一突破性的进展标志着通义千问在人工智能领域的又一次重大突破。

据了解,Qwen1.5-110B采用了先进的Transformer解码器架构,支持多种语言,并引入了高效的分组查询注意力机制。在Chat评估中,该模型相较于之前的版本表现更为出色,展现出了更大规模模型在对话生成方面的潜力。

值得一提的是,Qwen1.5-110B模型性能的提升主要得益于模型规模的扩大,而训练方法并未进行大幅改变。这充分证明了模型规模扩展在提升性能方面的重要性,即便在训练方法保持不变的情况下,也能通过增加模型参数数量来显著提升模型效果。

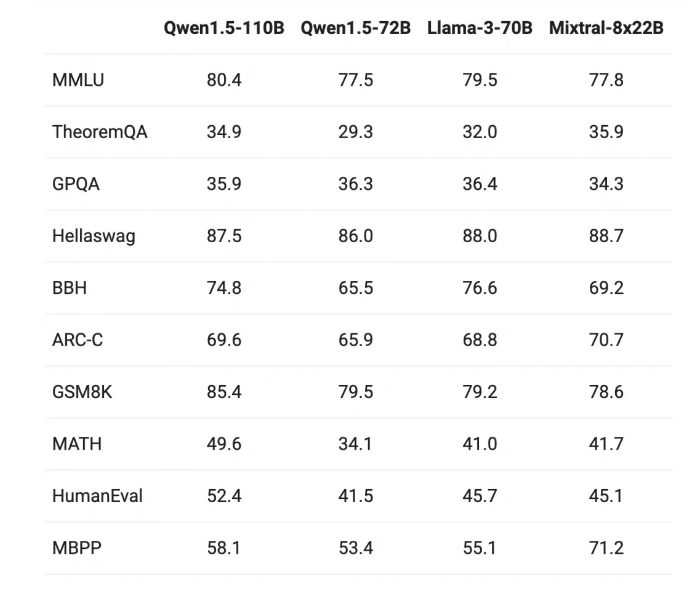

作为通义千问系列中规模最大的模型,Qwen1.5-110B拥有超过1000亿参数,这也是该团队首个突破千亿参数大关的模型。在与最近发布的SOTA模型进行性能比较时,Qwen1.5-110B同样表现出色,显示出在模型大小扩展方面仍有巨大的提升空间。

展望未来,通义千问团队将继续探索模型规模提升和扩展预训练数据规模两种方法带来的优势,以推动人工智能技术的不断进步。随着技术的不断发展,我们有理由相信,Qwen1.5-110B将成为未来人工智能领域的重要基石,为人们的生活带来更多便利和创新。

文章来源:https://qwenlm.github.io/zh/blog/qwen1.5-110b/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消