优化LLM性能:GeckOpt系统降低计算成本

大型语言模型(LLM)作为计算平台的基石,正推动着一系列广泛技术应用的革新。这些模型在海量数据的处理与解读中扮演着核心角色,但高昂的运营成本以及工具使用上的效率问题一直困扰着它们。

如何在不增加高额计算费用的情况下,提升LLM的性能,成为业内的一大挑战。传统上,LLM在系统中运行时,往往会为各种任务启动众多工具,而不去细致考虑每个操作的实际需求。这种广撒网式的工具启动方式,无疑会大量消耗计算资源,导致数据处理任务的成本剧增。

如今,新兴的方法论正在优化LLMs中的工具选择方式,更加注重根据任务的具体需求来精准部署工具。通过运用先进的推理能力,这些系统能够洞察用户命令的潜在意图,从而有针对性地精简执行任务所需的工具集。这种策略性的减少工具启动,直接提升了系统效率,降低了计算开销。

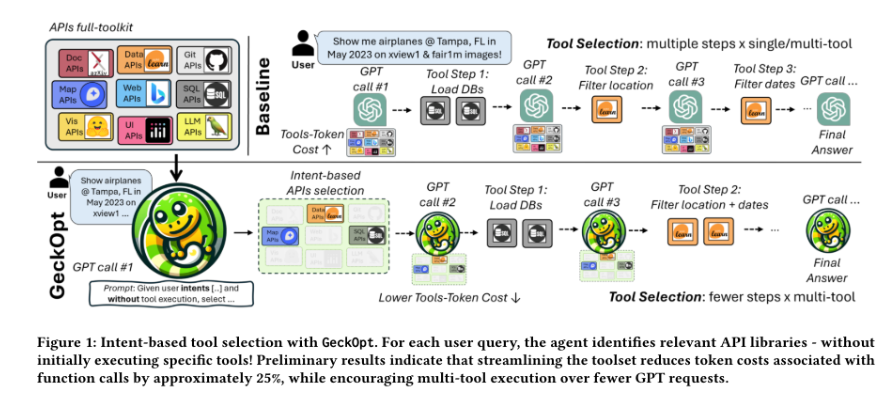

微软公司的研究人员开发的GeckOpt系统,就是基于意图进行工具选择的先进方法的代表。这种方法在用户意图的预分析基础上,优化API工具的选择,确保在任务执行前就已经选定了最符合特定任务要求的工具。通过缩小潜在工具的选择范围,GeckOpt最小化了不必要的工具启动,将计算能力集中在了最需要的地方。

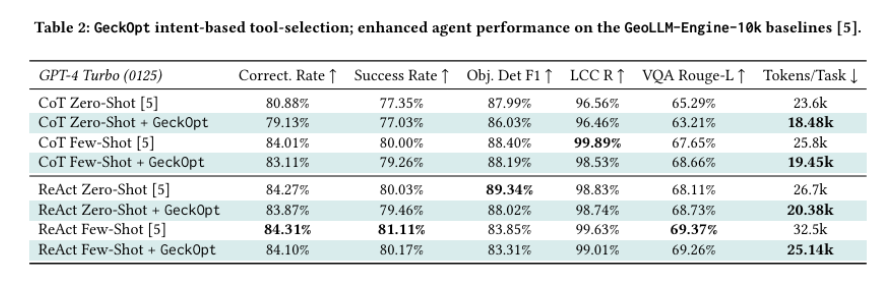

在拥有超过100个GPT-4-Turbo节点的Copilot平台上实施GeckOpt,初步结果令人振奋。在维持高运营标准的同时,该系统成功减少了高达24.6%的令牌消耗。这些效率提升不仅体现在系统成本的降低和响应时间的缩短上,而且并未对性能质量产生显著影响。实验数据显示,成功率的偏差在可忽略不计的1%范围内,这充分证明了GeckOpt在不同操作条件下的可靠性。

GeckOpt在简化LLM操作方面的成功,为广泛采用基于意图的工具选择方法提供了强有力的支撑。通过有效减轻运营负担和优化工具使用,该系统不仅降低了成本,还提高了LLM在不同平台上的可扩展性。引入此类技术有望改变计算效率的现状,为大规模AI实施提供一个可持续且成本效益高的模型。

总的来说,通过整合如GeckOpt这样的基于意图的工具选择系统,我们在优化大型语言模型基础设施方面取得了重要进展。这种方法显著降低了LLM系统的运营需求,促进了成本效益高且高效的计算环境的形成。随着这些模型的不断发展和应用范围的扩大,保持经济可行性的同时充分利用AI的潜力,将是我们技术进步的关键所在。