AI技术突破:模仿人类行走跑步的机器人

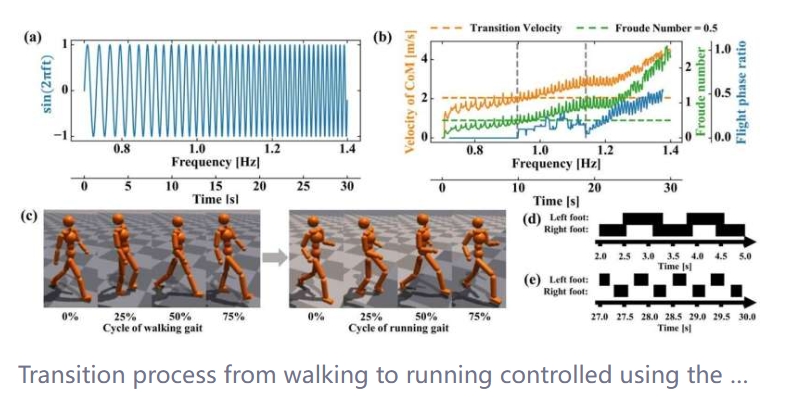

一组国际研究团队通过将中枢模式生成器(CPGs)与深度强化学习(DRL)相结合,开发出了一种新的技术,能够模仿人类的运动方式。这种技术不仅成功模仿了行走和跑步的动作,还能在没有预先的运动数据支持下生成运动,实现了行走和跑步之间的顺畅切换,并且能够应对不稳定的地表环境。

这项具有突破性的研究成果已在2024年4月15日的《IEEE机器人与自动化快报》上发布。

我们通常不会特别注意到,但行走和跑步都是基于人体固有的生物冗余性,使我们能够轻松适应各种环境或改变行走/跑步的速度。然而,要在机器人中复制这种类似人类的动作却异常困难,因为这其中涉及到的复杂性和多变性非常高。

现有的模型在面对未知或具有挑战性的环境时,往往难以适应,导致其效率低下且效果不佳。这是因为AI系统通常只能生成一个或少数几个正确的解决方案。然而,对于生物体和它们的运动来说,并不存在唯一正确的模式。实际上,存在一系列可能的运动方式,而且并不总是清楚哪一种最好或最有效。

深度强化学习(DRL)是研究人员试图克服这一难题的方法之一。DRL通过利用深度神经网络来处理更复杂的任务,并直接从原始感官输入中学习,从而扩展了传统的强化学习,使其具有更灵活和强大的学习能力。然而,其缺点也很明显,即探索庞大的输入空间所需的计算成本巨大,特别是在系统具有高度自由度时。

另一种方法是模仿学习,机器人通过学习执行相同运动任务的人的运动测量数据来进行学习。虽然模仿学习在稳定的环境中表现良好,但面对训练过程中未遇到的新情况或环境时,其效果就会大打折扣。其修改和有效导航的能力受限于其学习行为的狭窄范围。

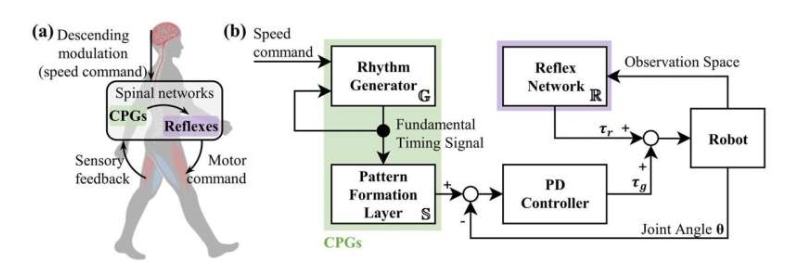

“我们通过将这两种方法结合,克服了它们的许多限制,”东北大学研究生院教授Mitsuhiro Hayashibe解释说,“我们没有直接将深度学习应用于CPG本身,而是将其应用于支持CPG的反射神经网络的一种形式,通过模仿学习来训练类似CPG的控制器。”

CPG是位于脊髓中的神经回路,就像生物体内的指挥家一样,产生肌肉活动的节奏模式。在动物中,反射回路与CPG协同工作,提供足够的反馈,使它们能够调整速度和行走/跑步运动以适应地形。

通过采用CPG及其反射对应物的结构,自适应模仿CPG(AI-CPG)方法在模仿人类运动时展现出了卓越的运动生成适应性和稳定性。

Hayashibe教授进一步补充说:“这一突破为机器人学中生成类似人类的运动设定了新的标准,具有前所未有的环境适应能力。我们的方法代表了机器人控制中生成性AI技术发展的重大进步,具有跨行业的潜在应用价值。”

该研究团队由东北大学研究生院和洛桑联邦理工学院(或洛桑的瑞士联邦理工学院)的成员组成。