使用Groq和Jan AI打造自己的AI编程助手

大家都在致力于构建更好的大型语言模型(LLM),而Groq则专注于AI的基础设施方面,使这些大型模型运行得更快。

在本教程中,我们将学习Groq LPU Inference Engine(LPU推理引擎)以及如何使用API和Jan AI在本地笔记本电脑上使用它。我们还将把它集成到VSCode中,以帮助我们生成代码、重构代码、记录文档和生成测试单元。我们将免费创建一个自己的AI编程助手。

Groq LPU Inference Engine是什么?

Groq LPU(语言处理单元)推理引擎旨在为具有顺序组件的计算密集型应用(如LLMs)生成快速响应。

与CPU和GPU相比,LPU具有更大的计算能力,这减少了预测一个单词所需的时间,使文本序列的生成速度大大提高。此外,LPU还解决了内存瓶颈问题,从而在LLMs上比GPU提供更好的性能。

简而言之,Groq LPU技术使你的LLMs变得超级快速,实现了实时AI应用。

安装Jan AI

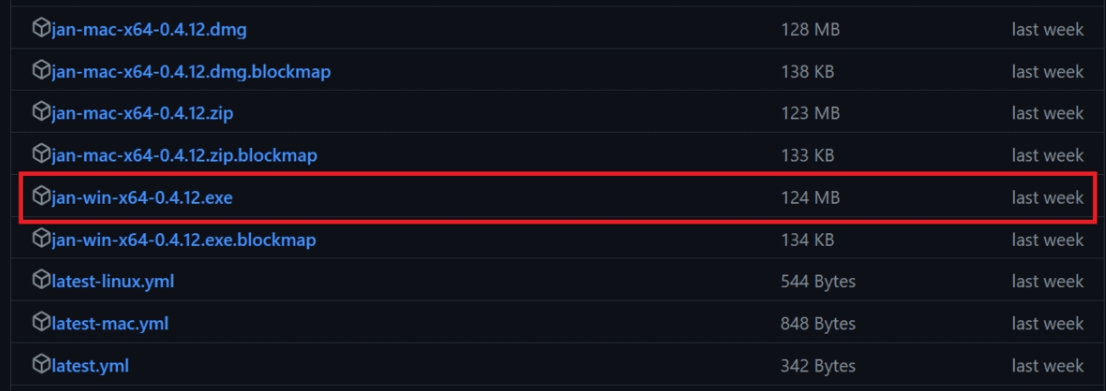

Jan AI是一款桌面应用程序,用于在本地运行开源和专有的大型语言模型。它可以在Linux、macOS和Windows上下载。我们将通过访问Releases · janhq/jan(github.com)并点击具有.exe扩展名的文件来在Windows上下载并安装Jan AI。

创建Groq Cloud API

为了在Jan AI中使用Grog Llama 3,我们需要一个API。为此,我们将通过访问https://console.groq.com/来创建一个Groq Cloud账户。

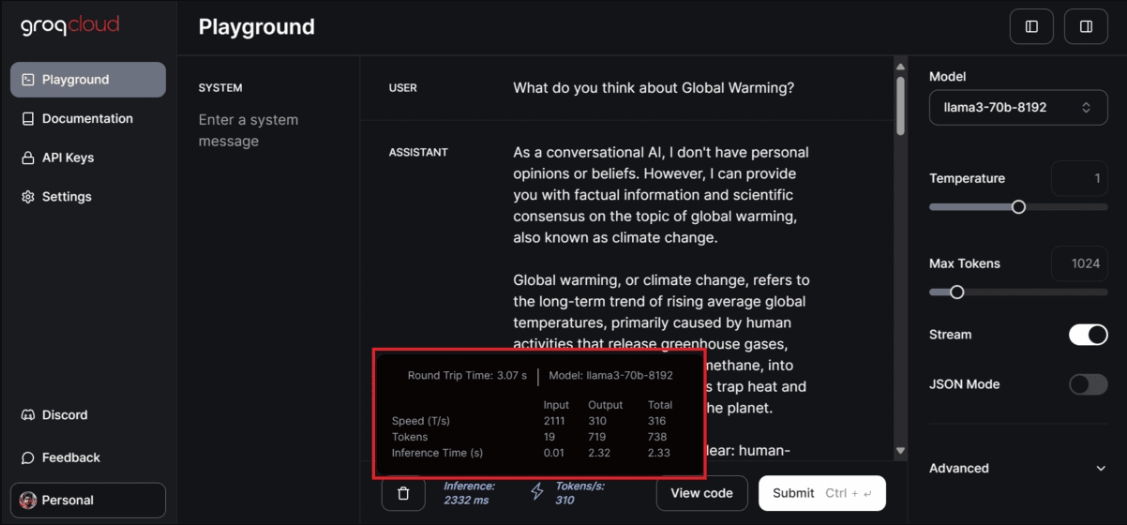

如果你想测试Groq提供的各种模型,你可以无需设置任何东西,只需转到“Playground”选项卡,选择模型,并添加用户输入即可。

在我们的情况下,它非常快。它每秒生成了310个tokens,这是我见过的最快的速度。即使是Azure AI或OpenAI也无法产生这样的结果。

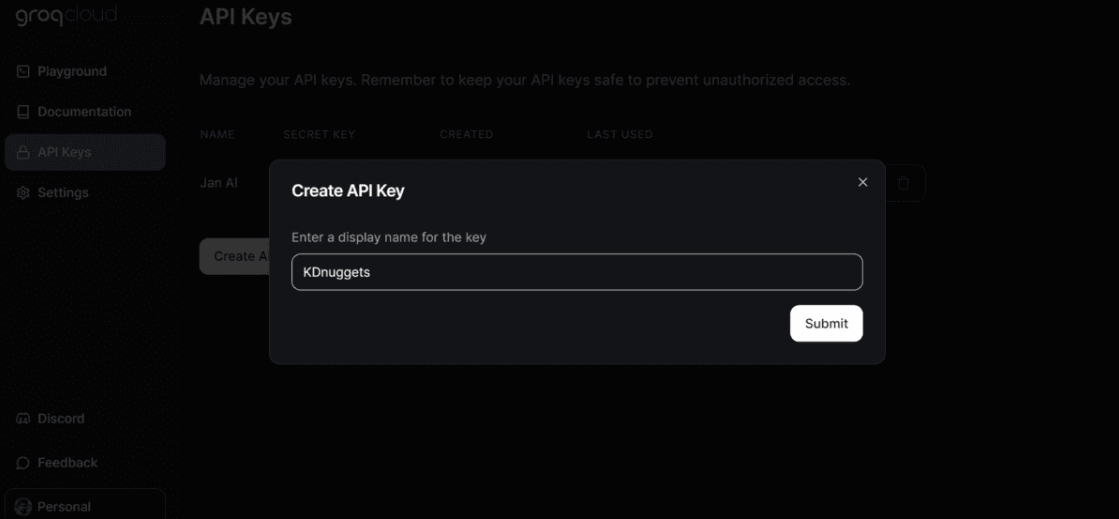

要生成API密钥,请点击左侧面板上的“API Keys”按钮,然后点击“Create API Key”按钮来创建并复制API密钥。

在Jan AI中使用Groq

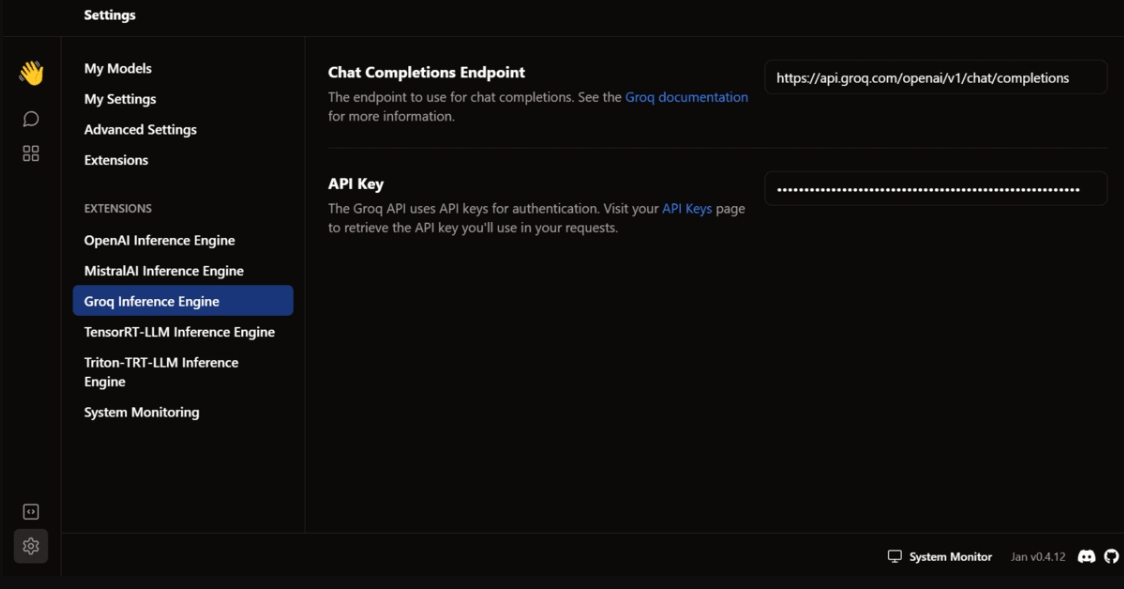

接下来,我们将把Groq Cloud API密钥粘贴到Jan AI应用程序中。

启动Jan AI应用程序,转到设置,在扩展部分选择“Groq Inference Engine”选项,并添加API密钥。

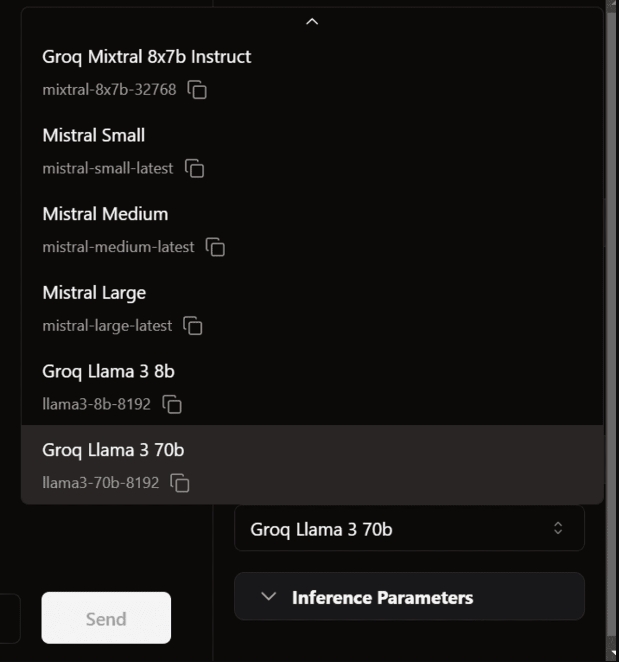

然后,返回线程窗口。在模型部分,从“远程”部分选择Groq Llama 3 70B,并开始提示。

响应的生成速度如此之快,我甚至跟不上它。

在VSCode中使用Groq

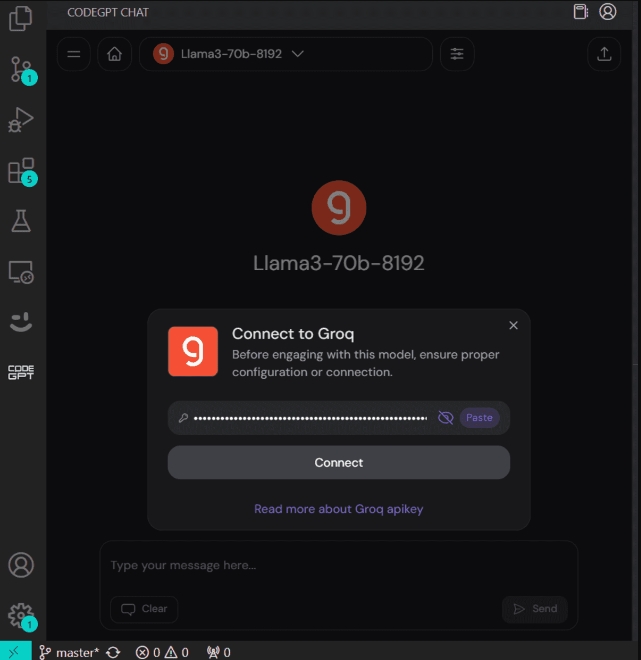

接下来,我们将尝试将相同的API密钥粘贴到CodeGPT VSCode扩展中,并构建我们自己的免费AI编码助手。

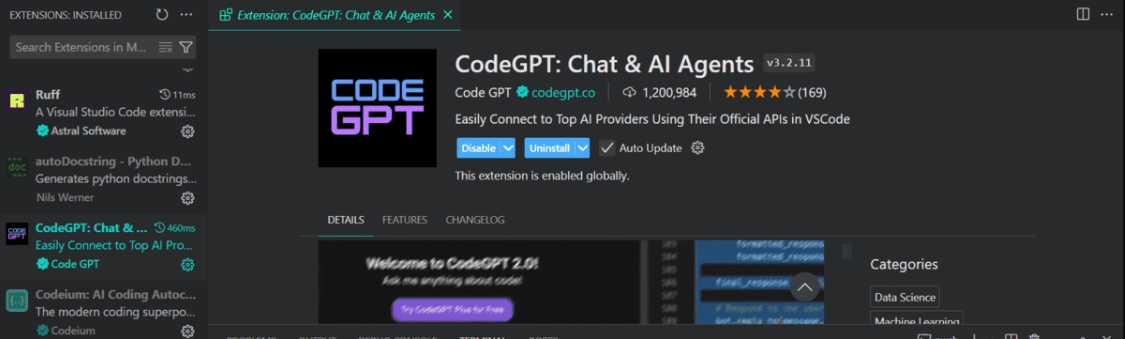

通过在扩展选项卡中搜索来安装CodeGPT扩展。

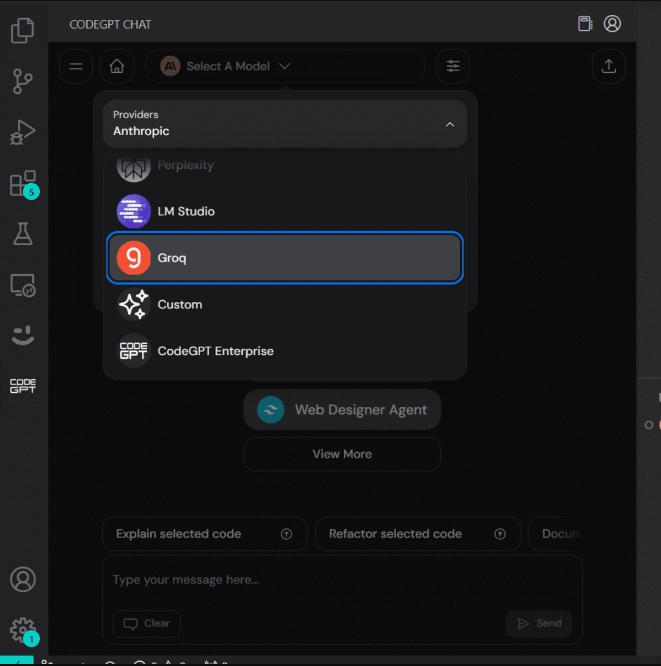

CodeGPT选项卡将出现,供您选择模型提供商。

当您选择Groq作为模型提供商时,它将要求您提供API密钥。只需粘贴相同的API密钥即可开始使用。您甚至可以为CodeGPT生成另一个API密钥。

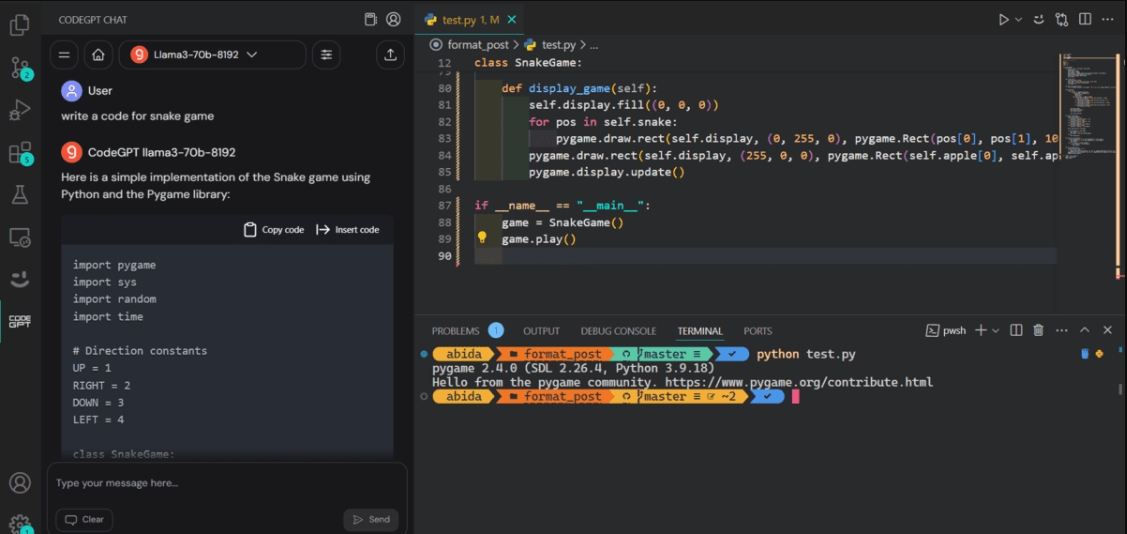

现在,我们将要求它编写蛇游戏的代码。它用了10秒钟来生成并运行代码。

这是我们的蛇游戏如何工作的演示。

了解前五名AI编码助手,成为AI驱动的开发者和数据科学家。请记住,AI是来协助我们的,而不是取代我们,所以要开放接受它,并使用它来改进你的代码编写。

结论

在本教程中,我们了解了Groq Inference Engine以及如何使用Jan AI Windows应用程序在本地访问它。最重要的是,我们已经通过使用CodeGPT VSCode扩展将其集成到我们的工作流程中,这非常棒。它为更好的开发体验实时生成响应。

现在,大多数公司都会开发自己的推理引擎以匹配Groq的速度。否则,Groq将在几个月内成为佼佼者。