普林斯顿大学与Meta AI联合推出Lory模型,重塑自回归语言模型预训练

2024年05月13日 由 neo 发表

555

0

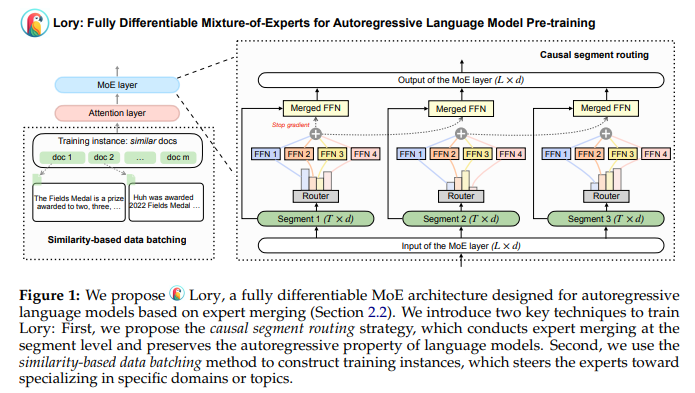

近日,普林斯顿大学与Meta AI的研究团队宣布了一项突破性的研究成果——Lory模型,该模型通过将专家混合(MoE)架构扩展到自回归语言模型预训练中,为自然语言处理领域带来了显著的性能提升。

MoE架构一直以其稀疏激活的特性在模型大小缩放和高效训练推理方面表现出色。然而,传统MoE模型在训练过程中面临着非可微分、离散目标的优化挑战。针对这一问题,普林斯顿大学和Meta AI的研究人员开发了Lory模型,该模型通过两种创新技术解决了传统MoE模型的局限性。

Lory模型的核心技术之一是因果段路由策略。该策略将输入令牌序列分割成固定长度的较小段,并利用原始段获取路由器的权重,评估后续段的合并专家。这种策略在保持语言模型自回归性质的同时,实现了专家合并的高效操作。

另一项关键技术是基于相似性的数据批处理方法。通过在训练期间将相似文档分组创建连续段,Lory模型克服了推理过程中段级路由导致的专家专业化不足问题。这种技术显著提高了专家路由的训练效率,使得Lory模型在多个方面都展现出卓越的性能。

Lory在多个方面均表现出色:

- · 训练效率和收敛性:Lory在训练令牌数量不到一半的情况下达到了相当的损失水平,对于0.3B和1.5B模型而言,这意味着在相同的训练计算下实现了更好的性能。

- · 语言建模:该MoE模型在所有领域均超越了密集基线模型,显著降低了困惑度。例如,与0.3B密集模型相比,0.3B/32E模型在书籍领域实现了13.9%的相对改进。

- · 下游任务:0.3B/32E模型在常识推理、阅读理解等多个下游任务上均实现了性能提升,分别达到了+3.7%、+3.3%、+1.5%和+11.1%的平均性能提高。

这一突破性成果得到了业界的广泛关注。专家表示,Lory模型的推出将极大地推动自然语言处理领域的发展,为各种应用场景带来更加高效、准确的解决方案。

普林斯顿大学和Meta AI的研究人员表示,未来将继续扩大Lory模型的规模,并通过开发高效解码方法,整合令牌和段级路由,进一步提升模型的性能。同时,他们也将积极探索Lory模型在其他领域的应用潜力,为人工智能技术的发展贡献更多力量。

文章来源:https://www.marktechpost.com/2024/05/12/researchers-from-princeton-and-meta-ai-introduce-lory-a-fully-differentiable-moe-model-designed-for-autoregressive-language-model-pre-training/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消