MIT推出突破性QoQ算法和QServe系统,大幅提升大型语言模型部署效率

在人工智能领域,大型语言模型(LLMs)的计算需求一直是一个重大挑战。然而,这一难题在近日得到了重大突破。由MIT、NVIDIA、UMass Amherst和MIT-IBM Watson AI Lab的研究人员联合推出的Quattuor-Octo-Quattuor(QoQ)算法和QServe系统,为高效部署LLMs提供了革命性的解决方案。

量化技术作为管理LLMs庞大计算需求的关键手段,一直备受关注。然而,传统的量化方法往往伴随着计算开销和准确性损失的双重挑战。为了克服这些难题,MIT领衔的研究团队开发了QoQ算法,这一创新方法采用渐进式群组量化,有效减轻了准确性损失,并通过两阶段量化过程显著提升了计算吞吐量和减少了延迟。

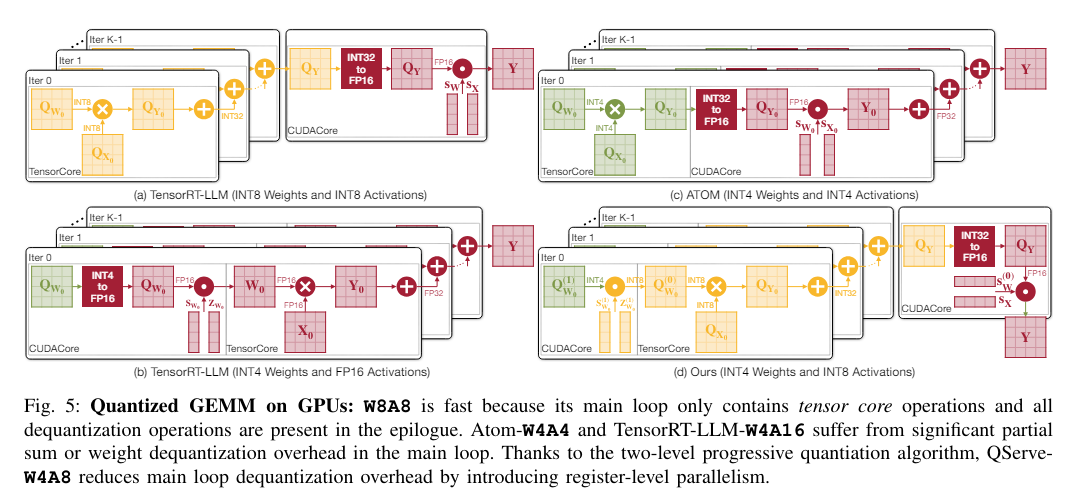

在详细解析中,QoQ算法首先将权重量化为8位,再进一步量化为4位,使得在INT8张量核心上进行通用矩阵乘法(GEMM)操作成为可能。这一技术革新不仅提高了计算效率,还结合了SmoothAttention技术进一步优化了模型性能。

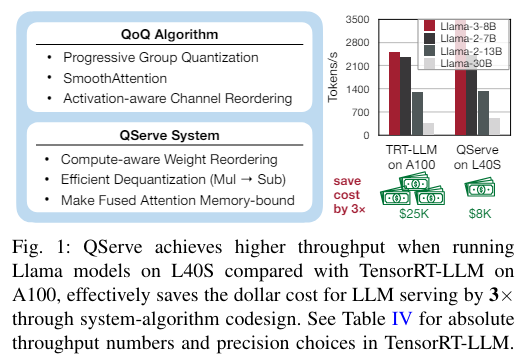

为了支持QoQ算法的部署,研究团队还开发了QServe系统。该系统量身定制的运行时环境充分利用了算法的潜力,通过计算感知的权重重排序和融合注意力机制,显著减少了量化开销,为实时应用中的吞吐量和延迟优化提供了强大支持。

性能测试结果显示,QoQ算法在NVIDIA A100和L40S GPUs上均实现了显著的吞吐量提升。特别是在L40S平台上,QServe系统实现了高达3.5倍的吞吐量增强,显著降低了LLM服务的成本。这一成果不仅证明了QoQ算法和QServe系统的有效性,也展示了它们在处理大规模计算任务时的卓越性能。

业内专家表示,QoQ算法和QServe系统的推出将极大地推动LLMs在实际应用中的广泛采用和高效使用。它们不仅解决了传统量化方法中的计算开销和准确性损失问题,还通过提高处理速度和降低经济成本,为人工智能领域的发展注入了新的活力。

展望未来,研究人员将继续优化QoQ算法和QServe系统,以适应更广泛的应用场景和更复杂的计算需求。这一突破性成果将为人工智能领域的持续发展提供强有力的技术支持和推动力量。