谷歌重磅推出Project Astra,挑战GPT-4o

在今年的谷歌年度I/O开发者大会上,谷歌宣布了一系列关于AI的新进展,其中引人注目的包括Project Astra——一个旨在构建未来通用AI代理的宏伟计划。

会议上,谷歌展示了一个Project Astra的早期版本,其核心理念是构建一个多模态AI助手,能够观察并理解世界的动态,并实时响应以帮助用户完成日常任务或解答问题。这一想法与OpenAI昨日展示的由GPT-4o驱动的ChatGPT有着异曲同工之妙。

然而,随着GPT-4o即将在未来几周内为ChatGPT Plus订阅者推出,谷歌在这方面的动作似乎稍显滞后。目前,谷歌仍在深入研究Astra项目,并未透露成熟的AI代理何时能够正式推出。但该公司表示,Project Astra的一些功能将在今年晚些时候率先在Gemini助手中亮相。

Project Astra将带来哪些新功能?

基于Gemini Pro 1.5和其他特定任务模型的进步,Project Astra——这个高级看和说响应代理——将使用户能够在分享周围复杂动态的同时与AI助手进行交互。该助手能够理解它所看到和听到的内容,并实时给出准确的回应。

谷歌DeepMind的首席执行官Demis Hassabis在博客文章中写道:“要真正对用户有用,AI代理需要像人类一样理解和响应复杂多变的世界——它必须能够吸收并记住所看到和听到的一切,以理解上下文并采取行动。此外,它还需要具备主动性、可教性和个性化,这样用户就可以自然地与之交谈,无需担心延迟或拖延。”

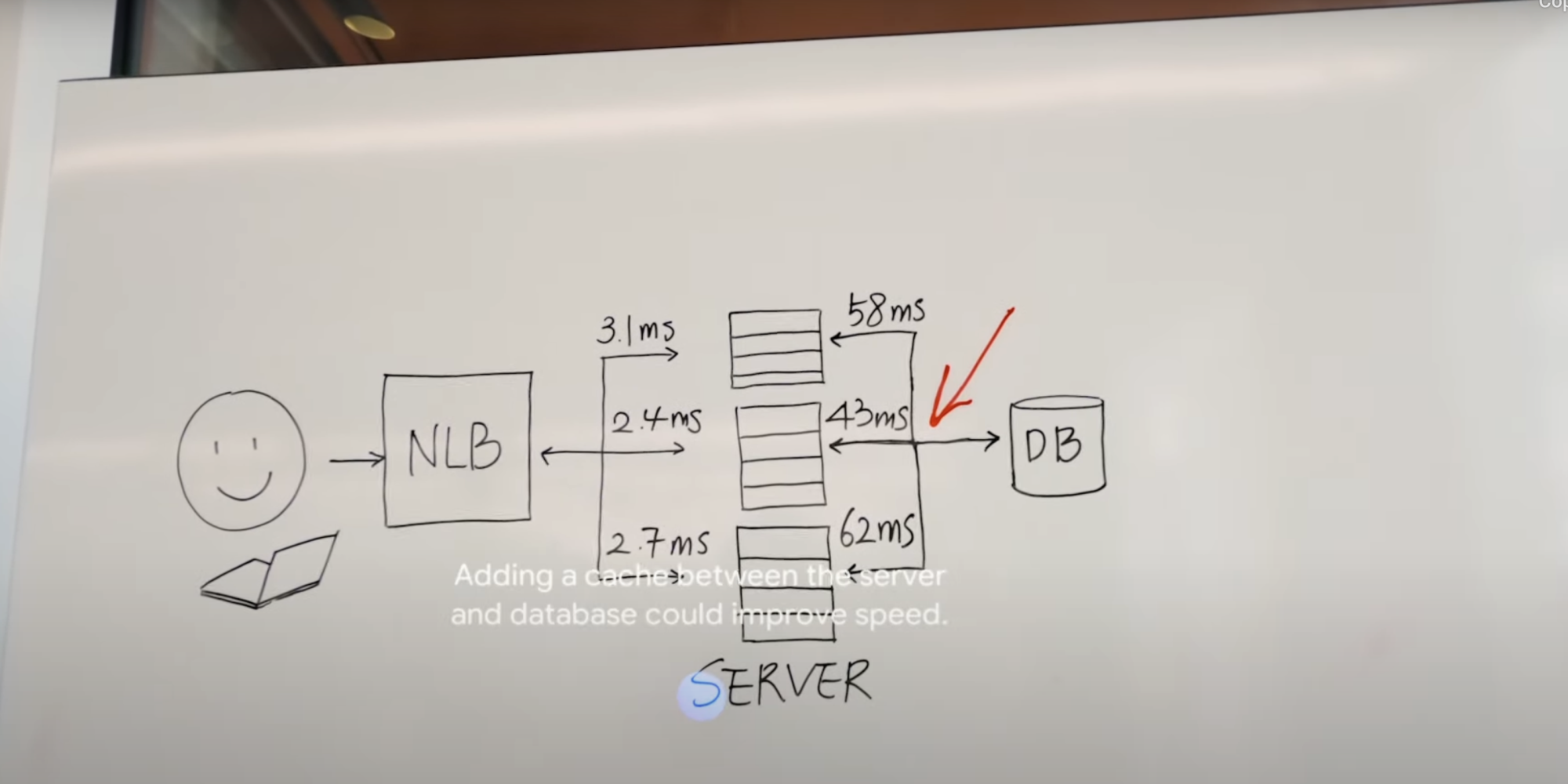

在谷歌发布的一个演示视频中,一个原型Project Astra代理在Pixel智能手机上运行,它能够识别物体、描述它们的特定组件,并理解白板上写的代码。更令人惊讶的是,它甚至能够通过相机取景器识别出邻居,并通过告诉用户他们把眼镜放在哪里来展示其记忆能力。

另一个演示视频则展示了代理建议改进系统架构的场景,同时在用户视野中实时覆盖了一副眼镜的图像。

Hassabis指出,尽管谷歌在跨多模态输入的推理方面取得了显著进展,但将代理的响应时间降低到接近人类对话水平仍是一个挑战。为了解决这个问题,谷歌的代理采用了连续编码视频帧的方式来处理信息,将视频和语音输入合并成事件时间线,并缓存这些信息以便高效回忆。

他补充说:“通过利用我们领先的语音模型,我们还增强了代理的声音表现,使它们具备更广泛的语调。这些代理能够更好地理解它们所处的上下文,并快速地进行对话响应。”

值得注意的是,OpenAI在GPT-4o中并未使用多个模型,而是对模型进行了端到端的训练,涵盖了文本、视觉和音频,使其能够处理所有输入和输出,并以平均320毫秒的时间响应。谷歌尚未公布Astra的具体响应时间,但随着项目的推进,任何潜在的延迟都有望得到减少。目前尚不清楚Project Astra代理是否具备与GPT-4o同等的情感理解能力。

何时能够使用?

虽然谷歌尚未公布Project Astra的具体推出时间,但该公司表示该项目的一些功能将在今年晚些时候率先在Gemini助手中亮相。Gemini是谷歌推出的一款智能助手应用,已经具备了丰富的功能和良好的用户口碑。随着Project Astra的加入,Gemini将更加强大,为用户提供更加全面、智能的服务。

在发布会上,谷歌还透露了Gemini Live的更新计划。该功能将允许用户与聊天机器人进行双向对话,并通过打开相机讨论周围环境。这一功能将使用户能够更加自然地与AI助手进行交互,进一步提升用户体验。

业界专家普遍认为,谷歌的Project Astra将是AI领域的重大突破。它不仅将推动AI技术的发展和应用,还将为用户带来更加便捷、高效的生活体验。随着项目的不断推进和完善,我们有理由相信,未来的AI代理将成为我们生活中不可或缺的一部分。

谷歌I/O大会的召开标志着科技巨头在AI领域的持续投入和创新。通过Project Astra等项目的推出,谷歌将继续引领AI技术的发展方向,为人类社会带来更多的便利和福祉。