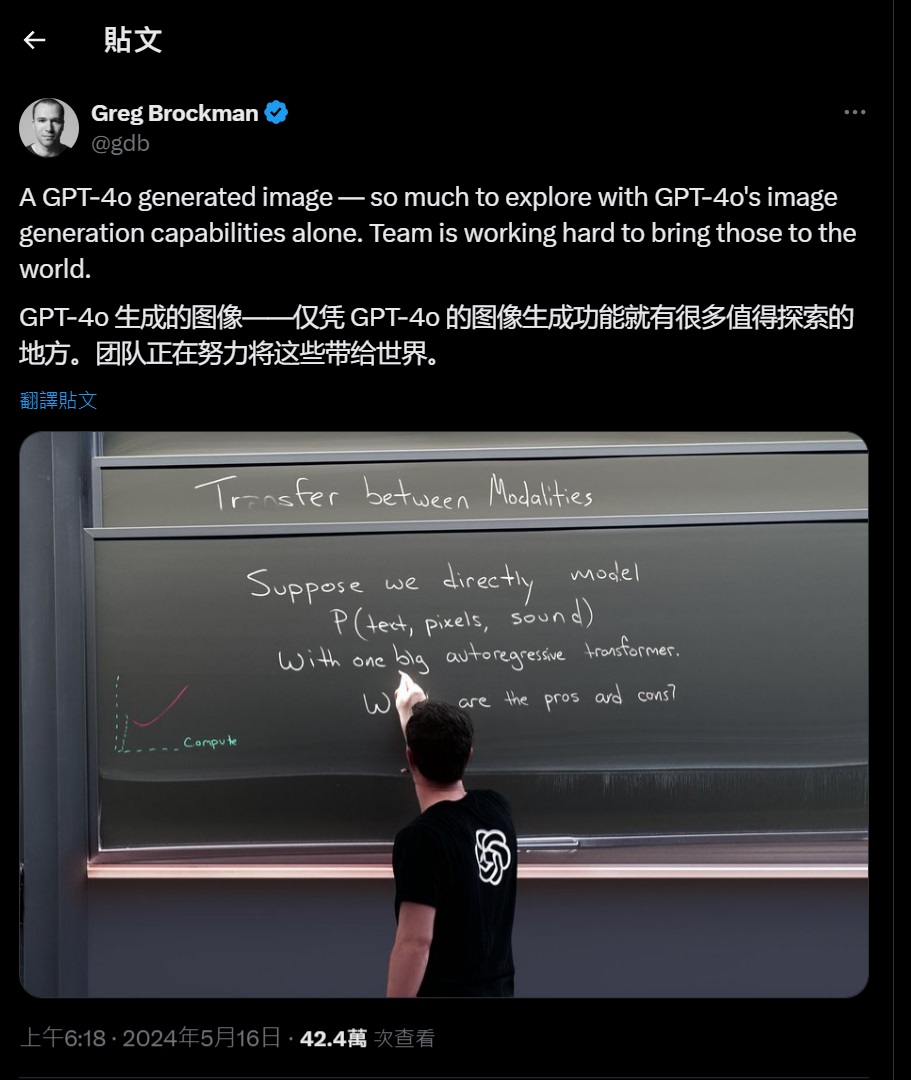

OpenAI总裁分享GPT-4o生成的第一张图像

2024年05月16日 由 neo 发表

412

0

OpenAI总裁Greg Brockman在他的X账户上发布了第一张公开图片,这张图片似乎是由该公司全新的GPT-4o模型生成的。

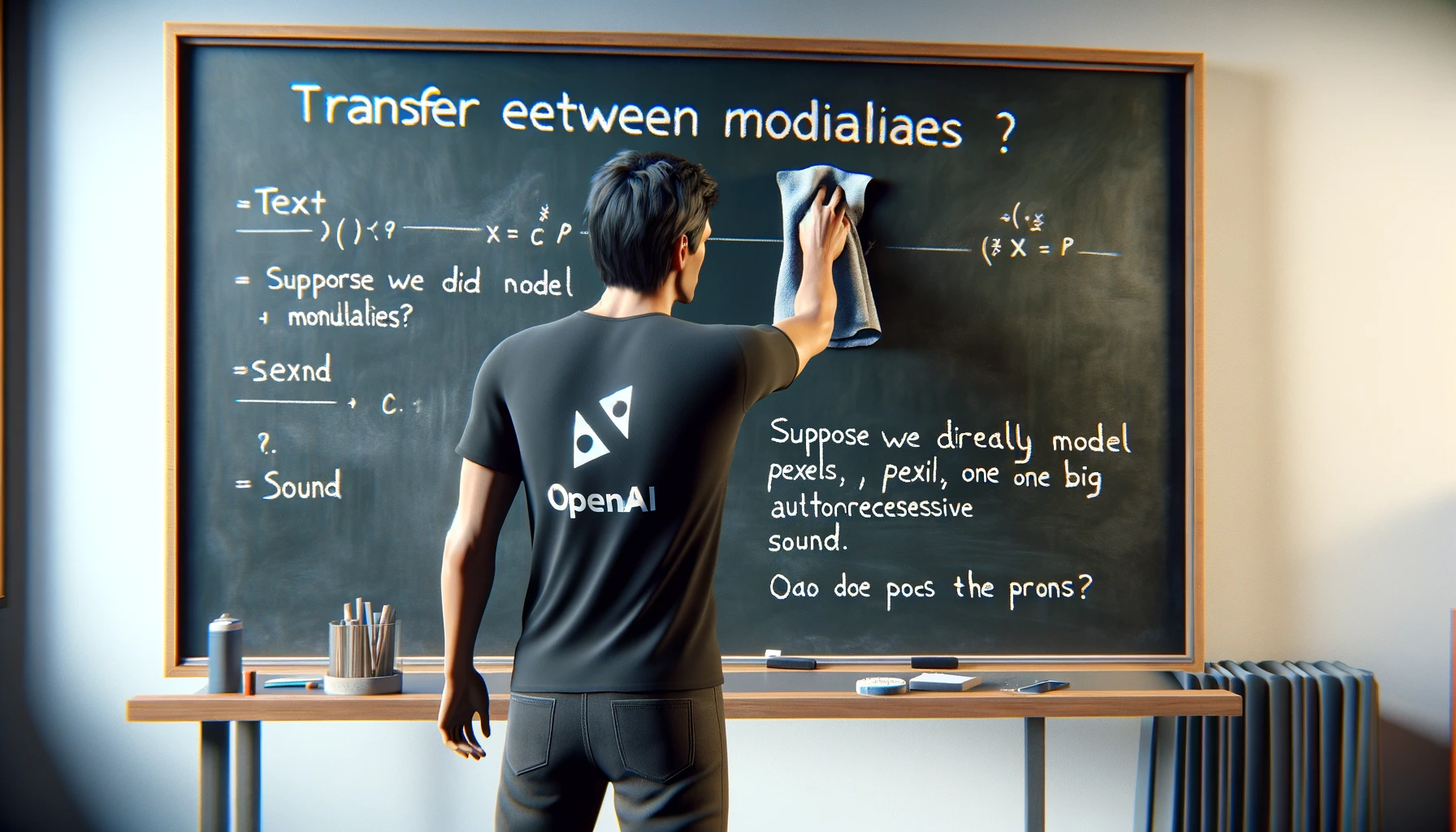

从图中我们可以看到,这张图片相当逼真,展示了一个穿着印有OpenAI标志的黑色T恤的人正在黑板上用粉笔书写:“模态间的转换。假设我们直接用一个大的自回归变换器来模拟P(文本、像素、声音)。优缺点是什么?”

GPT-4o模型于周一首次亮相,它相比之前的GPT-4系列模型(GPT-4、GPT-4 Vision和GPT-4 Turbo)在速度和成本上都更具优势,而且能够保留来自输入的更多信息,如音频和视觉数据。

之所以能取得这样的成果,是因为OpenAI采用了与以往GPT-4类大型语言模型(LLMs)不同的方法。虽然那些模型是将多个不同的模型链接起来,将音频和视觉等其他媒体转换为文本再转换回来,但GPT-4o从一开始就在多媒体令牌上进行了训练,这使它能够直接分析和解释视觉和音频数据,而无需先进行文本转换。

从上述图片可以看出,GPT-4o的新方法是对OpenAI最后一个图像生成模型DALL-E 3的显著改进,DALL-E 3于2023年9月首次亮相。我曾在ChatGPT中通过DALL-E 3运行了一个类似的提示,但GPT-4o生成的图片在质量、逼真度和文本生成的准确性方面有了显著提升。

然而,GPT-4o的原生图像生成能力目前尚未公开可用。正如Brockman在他的X帖子中所暗示的,“团队正在努力将这些功能带给全世界。”

文章来源:https://venturebeat.com/ai/openai-president-shares-first-image-generated-by-gpt-4o/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消