高效多模态大型语言模型(MLLM)的研究进展与应用

多模态大型语言模型(MLLM)作为人工智能领域的尖端创新,其将语言和视觉模型的功能巧妙结合,以应对如视觉问答和图像字幕等复杂任务。这些模型通过大规模预训练,集成多种数据模态,从而在各种应用中显著提高了性能。这种语言和视觉数据的融合使得MLLM能够执行以往单模态模型无法达成的任务,标志着人工智能领域的一大进步。

然而,MLLM也面临着一大挑战,即其对资源的高要求。训练这些模型需要巨大的计算资源,通常只有预算充足的大型企业才能负担得起。例如,训练像MiniGPT-v2这样的模型,在NVIDIA A100 GPU上需要超过800个GPU小时,这对于许多学术研究人员和小公司而言是难以企及的。此外,推理的高计算成本也进一步加剧了在资源受限环境中(如边缘计算)部署这些模型的困难。

为了应对这些挑战,目前的研究主要集中在优化MLLM的效率上。虽然OpenAI的GPT-4V和Google的Gemini等模型通过大规模预训练获得了卓越的性能,但其计算需求仍然限制了其广泛应用。因此,研究者们探索了多种策略,通过缩小模型规模和优化计算策略来创建高效的MLLM。这些策略包括利用每种模态的预训练知识,以减少从头开始训练模型的需求,从而节省资源。

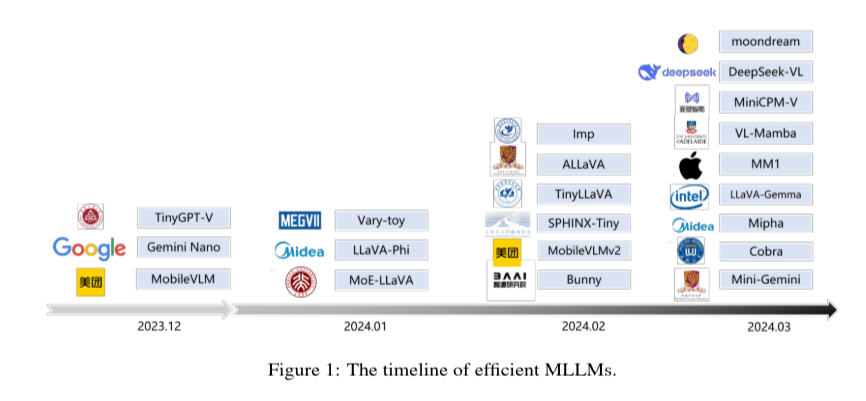

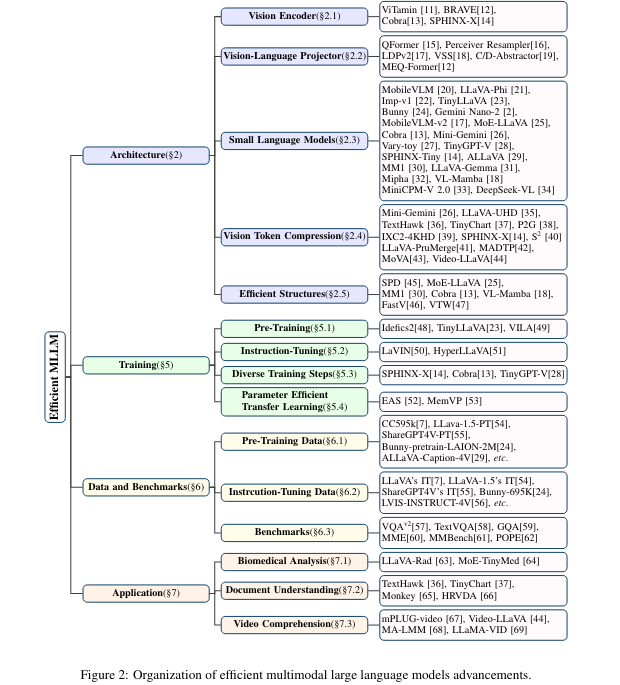

腾讯、上海交通大学、北京人工智能大学和华东师范大学的研究人员针对高效MLLM进行了深入研究,将最新进展归纳为几个关键领域:架构、视觉处理、语言模型效率、训练技术、数据使用和实际应用。他们的工作为该领域提供了全面的概述,并提出了一种在不牺牲性能的前提下提高资源效率的结构化方法。这项研究强调了开发轻量级架构和专为效率优化而定制的组件的重要性。

高效的MLLM采用了多种创新技术来解决资源消耗问题。这些技术包括引入更轻量级的架构,旨在减少参数和计算复杂度。例如,MobileVLM和LLaVA-Phi等模型通过视觉标记压缩和高效的视觉语言投影仪提高了效率。其中,视觉标记压缩技术通过将高分辨率图像压缩为更易管理的块特征来减少计算负荷,从而显著降低处理大量视觉数据所需的计算成本。

研究显示,高效MLLM的性能得到了显著提升。这些模型通过采用token压缩和轻量级模型结构,实现了计算效率的显著提高,并扩大了其应用范围。例如,LLaVA-UHD能够处理高达六倍分辨率的图像,而计算量仅为之前模型的94%。这使得在学术环境中训练这些模型成为可能,一些模型甚至仅使用8个A100 GPU在23小时内即可完成训练。这些效率提升并没有牺牲性能,如MobileVLM等模型在高分辨率图像和视频理解任务中表现出了卓越的结果。

关于高效多模态大型语言模型的调查的要点包括:

· 资源要求:高效多模态大型语言模型(MLLM)如MiniGPT-v2在NVIDIA A100 GPU上需要超过800个GPU小时的训练时间,这对于小型组织来说是一个巨大的挑战。此外,推理的高计算成本也限制了它们在资源受限环境中的部署。

· 优化策略:研究主要集中在通过减少模型大小和优化计算策略来创建高效的MLLM。这些策略充分利用了预先训练的模态知识,从而有效地节省了资源。

· 进展分类:该调查将高效MLLM的进展分为几个关键领域,包括架构、视觉处理、语言模型效率、训练技术、数据使用和实际应用,为这一领域提供了全面的概述。

· 视觉标记压缩:为了降低计算成本,研究者们采用了视觉标记压缩技术。这种技术通过将高分辨率图像压缩为更易于管理的块特征来减少计算负荷,显著提高了效率。

· 训练效率:高效的MLLM在学术环境中展现出极高的训练效率。例如,一些模型仅使用8个A100 GPU在23小时内即可完成训练。此外,自适应视觉标记减少和多尺度信息融合技术进一步增强了模型的细粒度视觉感知能力。

· 性能提升:与之前的模型相比,如LLaVA-UHD等高效MLLM能够在仅使用94%的计算量的情况下支持处理分辨率高达六倍的图像,从而显著提高了效率。

· 高效的架构:MLLM采用更轻量的架构、专门用于提高效率的组件以及新颖的训练方法,实现了显著的性能提升,同时降低了资源消耗。

· 特征信息减少:漏斗变换器和集合变换器等技术在保留必要信息的同时降低了输入特征的维数,从而提高了计算效率。

· 近似注意力:研究者们采用核化和低秩方法对高维矩阵进行变换和分解,使注意力机制更加高效。

· 文档和视频理解:高效的MLLM在文档理解和视频理解等应用中表现出色。TinyChart和Video-LLaVA等模型成功解决了高分辨率图像和视频处理的挑战。

· 知识提炼和量化:通过知识提炼,较小的模型可以从较大的模型中学习,同时通过量化降低ViT模型中的精度,以减少内存使用量和计算复杂度,同时保持准确性。

总之,对高效MLLM的研究通过提出减少资源消耗和增强可访问性的方法,解决了其更广泛使用的关键障碍。通过开发轻量级架构、优化计算策略和采用视觉标记压缩等创新技术,研究人员显著推进了MLLM领域的发展。这些努力使研究人员和组织能够更广泛地利用这些强大的模型,并增强其在现实场景(如边缘计算和资源有限的环境)中的适用性。本次调查所强调的进步为未来的研究提供了路线图,展现了高效MLLM在使高级AI功能民主化并提高其现实世界适用性方面的巨大潜力。