DeepSeek发布开源Coder V2模型,超越GPT-4 Turbo

此前因成功训练出基于2万亿个英文和中文标记的ChatGPT竞品而备受瞩目的中国AI初创公司DeepSeek,近日宣布推出了DeepSeek Coder V2,这是一款开源的专家混合(MoE)代码语言模型。

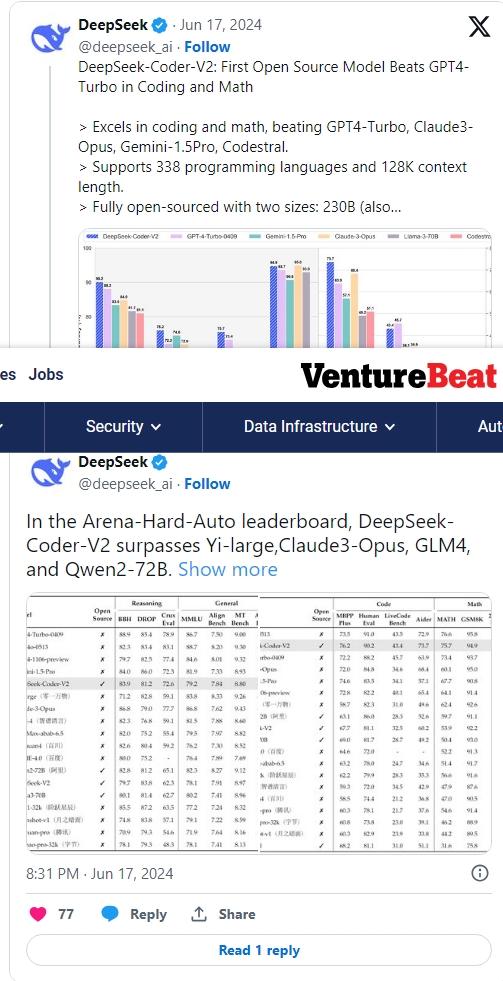

DeepSeek Coder V2是在上个月首次亮相的MoE模型DeepSeek-V2的基础上建立的,它在编程和数学任务上的表现均十分出色。这款模型支持超过300种编程语言,并且性能超越了众多最先进的闭源模型,包括GPT-4 Turbo、Claude 3 Opus和Gemini 1.5 Pro。DeepSeek公司自豪地宣称,这是首次有开放模型实现了这样的壮举,其性能远超Llama 3-70B等同类模型。

那么,DeepSeek Coder V2究竟带来了哪些新的亮点呢?

DeepSeek成立于去年,公司以“以好奇心解开AGI(通用人工智能)的神秘面纱”为使命,在AI竞赛中已成为中国的一颗耀眼新星,与Qwen、01.AI和百度等公司齐名。事实上,自成立仅一年以来,该公司已经开源了一系列模型,其中就包括DeepSeek Coder家族。

最初的DeepSeek Coder最多拥有330亿个参数,在基准测试中表现不俗,具备项目级代码补全和填充等功能,但当时仅支持86种编程语言,且上下文窗口为16K。而全新的V2版本在此基础上进行了大幅扩展,不仅将语言支持增加到了338种,还将上下文窗口扩大到了128K,使其能够处理更加复杂、广泛的编码任务。

在MBPP+、HumanEval和Aider等一系列基准测试中,这些测试旨在评估大型语言模型(LLMs)在代码生成、编辑和问题解决方面的能力。DeepSeek Coder V2分别取得了76.2、90.2和73.7的高分,这一成绩领先于包括GPT-4 Turbo、Claude 3 Opus、Gemini 1.5 Pro、Codestral和Llama-3 70B在内的众多闭源和开源模型。在评估模型数学能力的基准测试(MATH和GSM8K)中,也观察到了类似的卓越性能。

不过,唯一在多个基准测试中超越DeepSeek产品的模型是GPT-4o,它在HumanEval、LiveCode Bench、MATH和GSM8K等测试中获得了略高的分数。

DeepSeek表示,之所以能够取得这些技术和性能上的进步,得益于其基于专家混合(MoE)框架的DeepSeek V2作为基础。具体来说,公司在包含6万亿个标记的额外数据集上预训练了基础V2模型,这些标记主要来源于GitHub和CommonCrawl的代码和数学相关数据。

这使得这款带有16B和236B参数选项的模型,在解决当前任务时仅需激活2.4B和21B“专家”参数,同时满足了多样化的计算和应用需求。

除了擅长编码和数学相关任务外,DeepSeek Coder V2在一般推理和语言理解任务中也展现出了强大的性能。例如,在MMLU基准测试中,该模型获得了79.2的高分,这一成绩不仅远超其他专门针对代码的模型,而且与Llama-3 70B的分数几乎持平。尽管GPT-4o和Claude 3 Opus在MMLU类别中继续保持领先,但DeepSeek Coder V2的出色表现也证明了开放编码模型的实力正在逐步接近最先进的闭源模型。

目前,DeepSeek Coder V2在MIT许可下开放,允许进行研究和无限制的商业使用。用户可以通过Hugging Face平台下载16B和236B大小的指令和基础模型。此外,DeepSeek还通过其平台提供即用即付的API访问模式,让用户能够方便地使用这款先进的模型。

对于那些想要先测试模型功能的人,DeepSeek还提供了通过聊天机器人与DeepSeek Coder V2进行交互的选项,让用户能够亲身体验这款模型的强大能力。