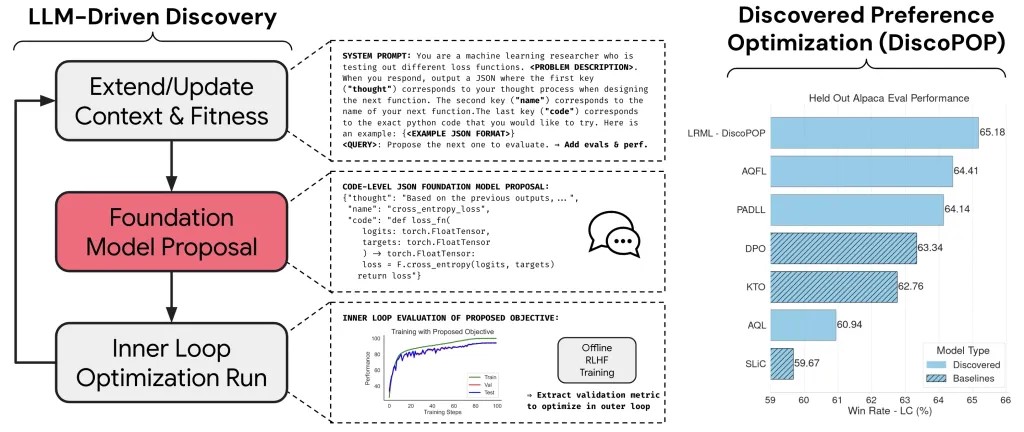

自我改进的LLM系统将成为一个大趋势

最近,出现了一系列使用大型语言模型(LLM)来创建自我改进系统的研究论文和技术。这是一条非常有趣的研究方向,有可能加速许多领域的进步。

该过程的大致步骤如下:

1- 大型语言模型接收自然语言指令,以提出问题的解决方案

2- 模型为解决方案生成多个假设

3- 通过工具(如代码执行器或数学求解器)验证这些假设

4- 将结果最有希望的假设及其结果返回给模型

5- 模型根据结果推理并提出改进意见

6-该过程不断重复,直到在质量指标上收敛或达到某个限制

这种自我增强的循环之所以有效,有两个原因:

1- 前沿模型已经接受了数万亿个文本标记的训练,这些标记包含了常识性世界知识、问题解决和推理。它们可以利用这些内在化的知识来创建解决方案并反思结果。而且,它们比只能在有限约束范围内工作的基于规则的僵硬问题求解器要灵活得多。

2- 该过程是可扩展的。虽然大型语言模型往往会生成错误的响应,但它们可以在人类提出一个假设所需时间的一小部分内为同一个问题提供许多答案。当与代码执行器等验证工具结合使用时,可以快速丢弃错误的答案。

这种由大型语言模型驱动的自我改进过程已经开始产生有趣的结果。

例如,由宾夕法尼亚大学、英伟达和德克萨斯大学奥斯汀分校的研究人员开发的一种名为DrEureka的技术,使用大型语言模型为机器人操作任务创建多个奖励模型的草案。然后将结果反馈给模型,并告诉它根据结果进行推理并思考如何改进自己。该模型不仅创建和调整奖励函数,还进行配置以促进从模拟到现实的转换(处理模型训练的模拟环境与真实世界的噪声之间的差异)。根据论文,这种技术已经证明可以创建比人类更好的奖励模型。

这种自我增强的循环之所以有效,原因在于两点:

1- 前沿模型已经在数万亿个文本标记上进行了训练,这些标记包含了常识性世界知识、问题解决能力和推理能力。它们可以利用这些内化的知识来创造解决方案,并对结果进行反思。这些模型比那些只能在有限约束范围内工作的基于规则的僵硬问题求解器要灵活得多。

2- 该过程具有可扩展性。虽然大型语言模型往往会生成错误的响应,但它们可以在人类提出一个假设所需时间的极短时间内为同一个问题提供许多答案。当与代码执行器等验证工具结合使用时,可以快速丢弃错误的答案。

这种由大型语言模型驱动的自我改进过程已经开始产生有趣的结果。

例如,由宾夕法尼亚大学、英伟达和德克萨斯大学奥斯汀分校的研究人员开发的一种名为DrEureka的技术,就使用了大型语言模型来为机器人的操作任务创建多个奖励模型的草案。然后,将结果反馈给模型,并告诉它根据这些结果进行推理,并思考如何改进自己。该模型不仅创建和调整奖励函数,还进行配置以促进从模拟到现实的转换(处理模型训练的模拟环境与真实世界的差异)。根据论文,这种技术已经证明可以创建出比人类设计的更好的奖励模型。

这两种技术都使用了上述的循环过程,并针对特定任务做了一些修改。而且,它们都已经能够超越人类的表现。这是一种非常强大的组合,也正在其他领域如定理证明和解决编程挑战中发挥作用。

然而,这种模式能够推进的程度存在限制。首先,这些模型需要人类精心设计的提示。例如,在DrEureka项目中,初始提示中包含的指令类型对模型提出的解决方案产生了巨大影响(尽管有人认为其他自动提示优化技术,如OPRO,最终可能会克服这一限制)。

其次,这种模式只能应用于具有验证机制(如执行代码)的问题。否则,模型很容易走上一条偏离实际、基于自己的幻想继续发展的奇怪路径。

最后,对于需要复杂推理技能的任务,只有像GPT-4这样的前沿模型才能提供合理的假设。由于每次迭代都需要创建和验证数十个或数百个假设,推理成本很快就会成为瓶颈(除非模型的成本大幅下降或开源模型赶上私有模型)。

无论如何,尽管大型语言模型还远远不能取代人类,但它们可以成为非常出色的助手,帮助搜索庞大的解决方案空间。即使预算有限,一个设计良好的基于大型语言模型的自我改进循环也能帮助比传统方式更快地找到解决方案。接下来几个月里,自我改进系统如何加速AI研究将非常有趣。