探索几何深度学习:基础模型和应用

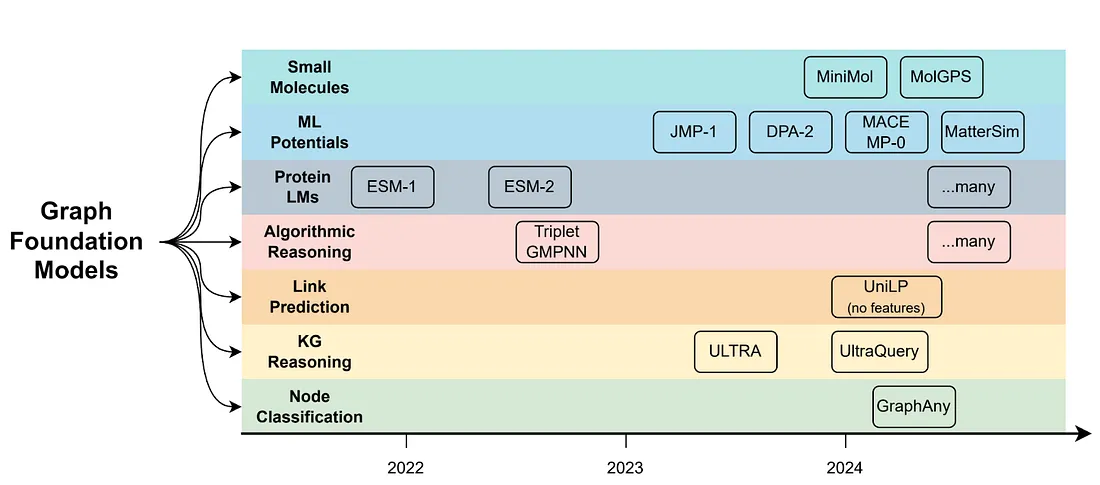

语言、视觉和音频的基础模型已成为 2024 年机器学习的主要研究主题之一,而针对图结构数据的 FM 则有些落后。在这篇文章中,我们认为图 FM 的时代已经开始,并提供了一些如何在今天使用它们的示例。

什么是图形基础模型以及如何构建图形基础模型?

由于 "基础 "模型的定义在一定程度上存在模糊性,因此我们应该从定义入手,建立一个共同的基础:

"图形基础模型是一种单一的(神经)模型,它可以学习可迁移的图形表征,并能推广到任何新的、以前从未见过的图形。

面临的挑战之一是,图的形式和形状多种多样,其连接性和特征结构也可能大相径庭。标准图形神经网络(GNN)不是 "基础",因为它们在最佳情况下只能在具有相同类型和维度特征的图形上工作。像标签传播(Label Propagation)或个性化页面排名(PageRank)这样可以在任何图形上运行的图形启发式方法也不能被视为图形 FM,因为它们不涉及任何学习。虽然我们非常喜欢大型语言模型,但目前还不清楚将图解析为序列并传递给 LLM(如 GraphText 或 Talk Like A Graph)是否是一种合适的方法,既能保留图的对称性,又能扩展到比玩具大小的数据集更大的范围。

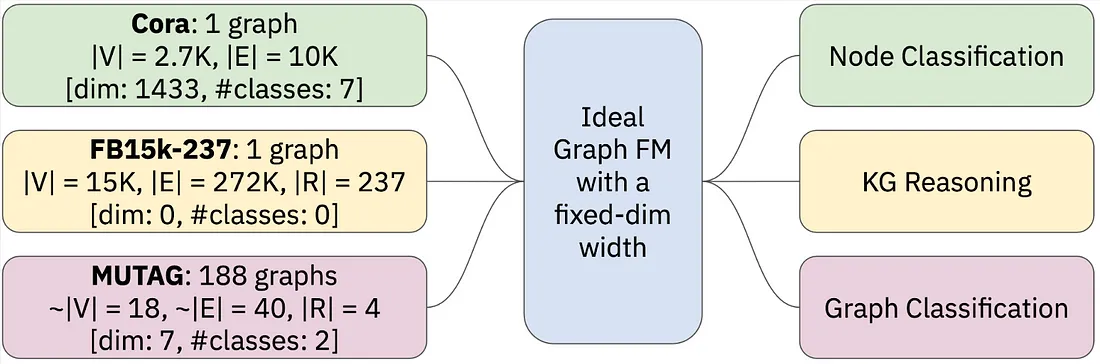

设计Graph FM的最重要问题或许是可移植的图形表示法。正如最近由 Mao、Chen 等人撰写的 ICML 2024 立场文件所建议的那样,LLM将任何语言的任何文本压缩成固定大小词汇表中的标记。视频语言调频技术采用的是始终可以从图像中提取的补丁(任何图像或视频中都有 RGB 通道)。对于可能具有多种特征的图而言,通用的特征化(如标记化)方案是什么并不明确,例如:

- 具有节点特征和一些给定节点标签的大型图(节点分类任务的典型特征)

- 一个大型图,没有节点特征和类别,但有有意义的边类型(典型用于链接预测和 KG 推理)

- 许多小图,具有/不具有节点/边特征,具有图级标签(典型用于图分类和回归)

到目前为止,图学习社区在设计图 FM 时还有几个未解决的研究问题:

- 如何在具有异构节点/边/图特征的图中进行泛化?例如,用于节点分类的流行Cora数据集是一个具有维度 1,433 的节点特征的图,而 Citeseer 数据集具有 3,703 维特征。如何为如此多样化的图定义一个单一的表示空间?

- 如何在预测任务中推广?节点分类任务可能具有不同数量的节点类别(例如,Cora 有 7 个类别,而 Citeseer 有 6 个)。更进一步,节点分类模型能否在链接预测中表现良好?

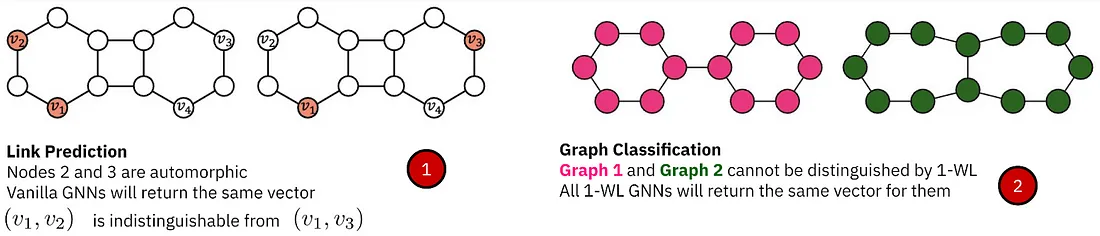

- 基础模型的表达能力应该是什么?人们对 GNN 的表达能力进行了大量研究,通常采用与 Weisfeiler-Lehman 同构测试的类比。由于图基础模型理想情况下应该处理广泛的问题,因此正确的表达能力难以捉摸。例如,在节点分类任务中,节点特征与图同质性或异质性一样重要。在链接预测中,结构模式和打破自同构更为重要(节点特征通常不会带来巨大的性能提升)。在图级任务中,图同构开始发挥关键作用。在分子生成等 3D 几何任务中,需要处理连续对称性的额外复杂性(参见《几何 GNN 的漫游指南》)。

在以下部分中,我们将展示至少在某些任务和领域中,Graph FM 已经可用。我们将重点介绍它们在可迁移特性方面的设计选择以及在对新的未见图进行归纳推理方面的实际优势。

节点分类:GraphAny

多年来,基于 GNN 的节点分类器一直局限于单个图数据集。也就是说,例如,给定具有 2.7K 个节点、1433 维特征和 7 个类的 Cora 图,必须专门在 Cora 图上训练一个带有其标签的 GNN,并在同一张图上运行推理。将训练好的模型应用于另一个图(例如具有 3703 维特征和 6 个类的 Citeseer)将遇到难以克服的困难:一个模型如何推广到不同的输入特征维度和不同数量的类?通常,预测头被硬编码到固定数量的类。

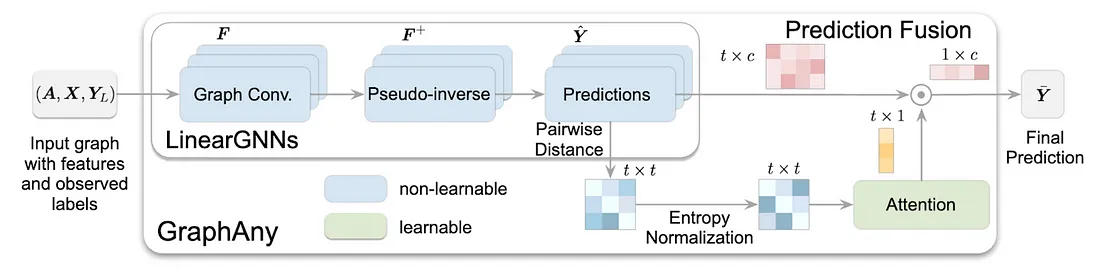

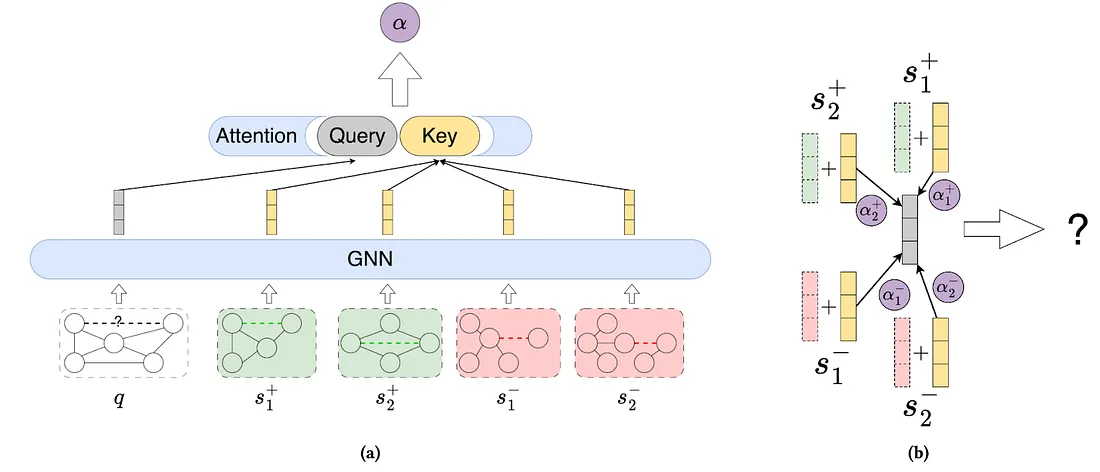

据我们所知, GraphAny是第一个 Graph FM,其中单个预训练模型可以对具有任何特征维度和任何数量类别的任何图执行节点分类。在标准威斯康星数据集的 120 个节点上进行预训练的单个 GraphAny 模型成功推广到 30 多个不同大小和特征的其他图,并且平均而言,其表现优于在每个图上从头训练的 GCN 和 GAT 图神经网络架构。

设置:半监督节点分类:给定图 G、节点特征 X 和来自 C 类的几个标记节点,预测目标节点的标签(二分类或多分类)。节点特征的维度和唯一类的数量不是固定的,并且依赖于图。

可迁移性: GraphAny 不会为所有可能的图形建模一个通用的潜在空间(这非常麻烦,甚至可能实际上是不可能的),而是绕过这个问题,专注于光谱滤波器预测之间的相互作用。给定一组类似于简化图卷积的高通和低通滤波器(例如,AX 和 (IA)X 形式的操作,在论文中称为“LinearGNN”)和已知节点标签:

- GraphAny 将过滤器应用于所有节点;

- GraphAny 通过求解封闭形式的最小二乘优化问题,从具有已知标签的节点中获得每个预测器的最佳权重(最佳权重表示为伪逆);

- 将最佳权重应用于未知节点以获得暂定的预测日志;

- 计算这些 logit 之间的成对距离并应用熵正则化(这样不同的图形和特征大小就不会影响分布)。例如,对于 5 个 LinearGNN,这将产生 5 x 4 = 20 个 logit 分数组合;

- 学习这些逻辑上的归纳注意力矩阵,以最有效地对预测进行加权(例如,将更多注意力放在异质图的高通滤波器上)。

最后,模型中唯一可学习的组件是注意力的参数化(通过 MLP),它不依赖于唯一类的目标数量,而只依赖于使用的 LinearGNN 的数量。同样,所有 LinearGNN 预测器都是非参数的,它们的更新节点特征和最佳权重可以预先计算,以便更快地进行推理。

链接预测: 尚未

设置:给定一个有或没有节点特征的图 G,预测一对节点 (v1, v2) 之间是否存在链接

对于有节点特征的图,我们还没有发现任何可用于链接预测的单一可转移模型。

对于非饱和图(或者你决定刻意省略节点特征),还有更多可说的--基本上,由于采用了统一节点特征化策略,所有具有标记技巧的 GNN 都有可能转移到新图中。

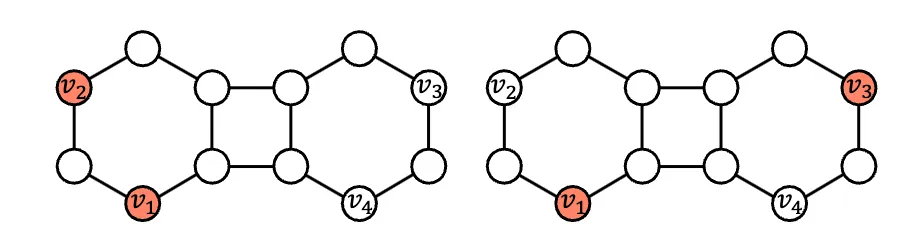

众所周知,在链接预测中,最大的障碍是自动形态节点(具有相同结构作用的节点)的存在--虚构的 GNN 会为它们分配相同的特征,这使得下图中的两个链接(v1, v2)和(v1, v3)无法区分。双半径节点标签或距离编码等标签技巧就是这种打破自动对称性的节点特征化策略。

UniLP 也许是唯一一种采用标记技巧(针对非饱和图)对未见图的链接预测进行评估的方法。UniLP 是一种上下文对比学习模型,需要为每个要预测的目标链接提供一组正样本和负样本。实际上,UniLP 使用 SEAL 作为骨干 GNN,通过固定数量的正负样本学习注意力。另一方面,SEAL 是出了名的慢,因此要使 UniLP 扩展到大型图,第一步就是用更高效的方法(如 ELPH 和 BUDDY)取代子图挖掘。

可转让的内容:通过标记技巧 GNN 学习到的结构模式--事实证明,神经 Bellman-Ford 等方法可以捕捉节点对的度量,例如个性化 PageRank 或 Katz 指数(通常用于链接预测)。

现在,我们已经知道如何处理自动变形,因此要实现用于链接预测的单一图 FM,唯一的步骤就是增加对异构节点特征的支持。

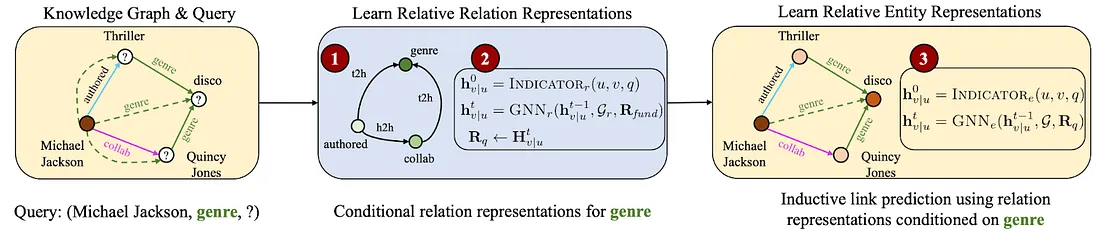

知识图谱推理: ULTRA 和 UltraQuery

知识图谱具有特定图谱的实体和关系集,例如维基百科/维基数据中的普通百科全书事实或 Hetionet 中的生物医学事实,这些关系具有不同的语义,并且不能直接相互映射。多年来,KG 推理模型都是根据给定的关系词汇硬编码的,无法转换到具有全新实体和关系的新的未知 KG。

ULTRA 是第一个用于 KG 推理的基础模型,可以在推理时以零点方式转移到任何 KG。也就是说,一个预先训练好的模型可以在任何大小和实体/关系词汇的多关系图上运行推理。根据 57 个图的平均值,ULTRA 明显优于专门针对每个图训练的基线模型。最近,ULTRA 被扩展为 UltraQuery,以支持对涉及连接词、反连接词和否定操作符的图进行更复杂的逻辑查询。UltraQuery 可以转移到未见过的图中,并在这些未见过的图中使用 10 多种复杂的查询模式,其性能大大超过了从头开始训练的基线。

设置: 给定具有 |E| 节点和 |R| 边类型、无节点特征的多关系图 G,通过返回给定图中所有节点的概率分布,回答简单的 KG 完成查询(head、relation、?)或涉及逻辑运算符的复杂查询。节点和关系类型的集合取决于图,可能会有所不同。

可转让的内容 ULTRA 依赖于关系交互建模。暂且不谈关系特性和目标图域,如果我们发现 "作者 "和 "合作 "关系可以共享同一个起始节点,而另一个图中的 "学生 "和 "合作者 "关系可以共享一个起始节点,那么这两对关系的相对结构表示可能是相似的。这适用于任何领域的多关系图,无论是百科全书还是生物医学 KG。ULTRA 更进一步,捕捉了关系之间的 4 种 "基本 "互动。这些基本互动关系(连同学习到的 GNN 权重)可以转移到任何 KG 中--这样,一个预先训练好的模型就可以用于任何未见过的图和简单或复杂的推理查询。

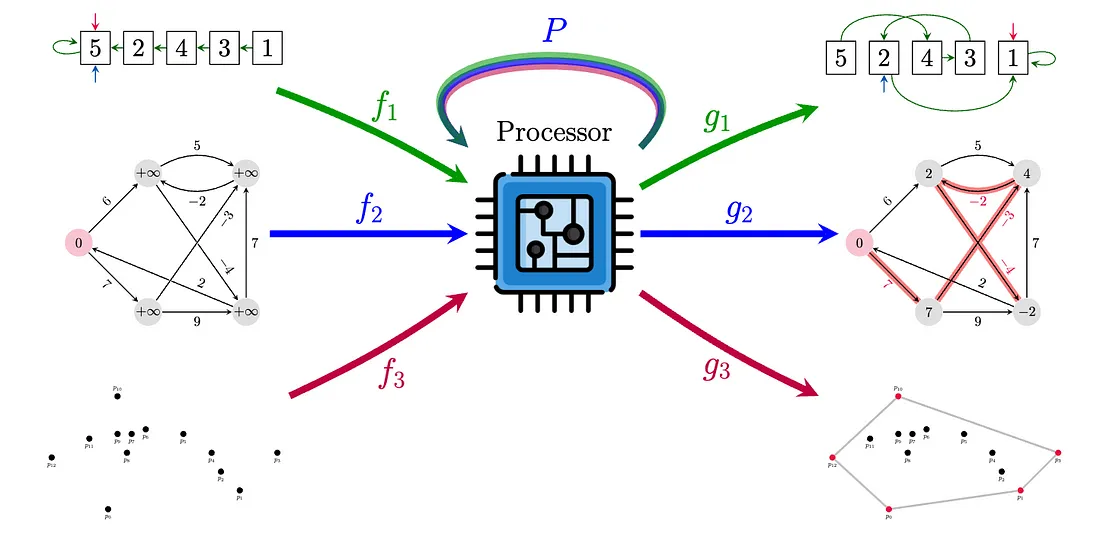

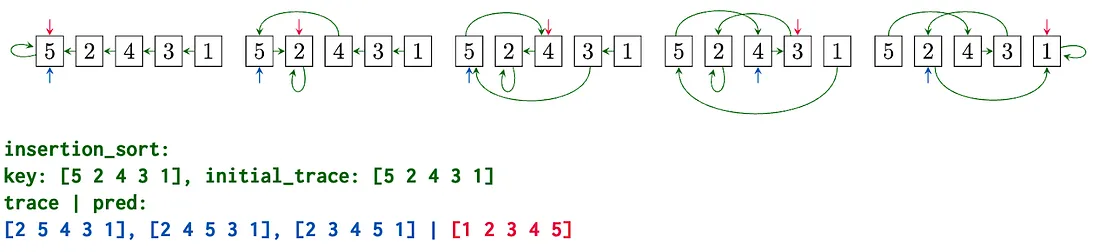

算法推理: 通才算法学习者

设置: 神经算法推理(NAR)研究在潜在空间中执行标准算法(如排序、搜索、动态编程),并将其推广到任意大小的输入。很多此类算法都可以用图输入和指针来表示。给定一个具有节点和边特征的图 G,任务就是模拟算法并产生正确的输出。你还可以选择访问提示,即算法中间状态的时间序列,它可以作为中间监督信号。显然,不同的算法需要执行的步骤数不同,因此这里的长度不是固定的。

什么是可转移的?同类算法具有相同的特征空间和相似的控制流。例如,Prim 算法和 Dijkstra 算法具有相似的结构,区别仅在于关键函数和边缘松弛子程序的选择。此外,还有一些关于消息传递和动态编程之间直接一致性的证明。这也是一个 "处理器 "神经网络的主要动机,它可以更新所有考虑过的算法(CLRS 书籍中的 30 个经典算法)的潜在状态。

Triplet-GMPNN是首个此类通用处理器神经网络(到2024年,它已成为NAR文献中的标准)--它是一个在节点及其特征的三元组上运行的GNN(类似于AlphaFold中的边缘变换器和三角注意)。该模型在多任务模式下对基准中的所有算法任务进行训练,并进行了少量优化和技巧。与单任务专家模型相比,单一模型在 30 项任务上的平均性能提高了 20% 以上(绝对数字)。

尽管如此,编码器和解码器还是要为每个任务专门设置参数--统一输入和输出格式的方法之一,还不如像最近的 CLRS 文本版那样,使用 LLM 处理器来处理文本。

2024 年和 2025 年,NAR 中最有趣的问题或许是:OOD 的算法推理思想能否成为可推广的 LLM 推理的关键?

众所周知,LLM 在复杂推理问题上举步维艰,arxiv 上每个月都会出现几十篇论文,试图用一种新的提示方法将基准性能再提高一两个百分点,但大多数方法都无法在类似图结构的任务中应用(见下文示例)。我们需要更具原则性的方法,而 NAR 有可能填补这一空白!

几何和 AI4Science 基础模型

在几何深度学习和科学应用领域,基础模型作为通用 ML 势、蛋白质语言模型和通用分子特性预测器正变得越来越普遍。虽然在大多数情况下都存在通用词汇(如小分子中的原子类型或蛋白质中的氨基酸),我们也无需考虑通用特征化问题,但主要的复杂性在于原子对象在现实世界中的物理特性--它们具有明显的三维结构和属性(如能量),而这些都有植根于化学、物理学和量子力学的理论依据。

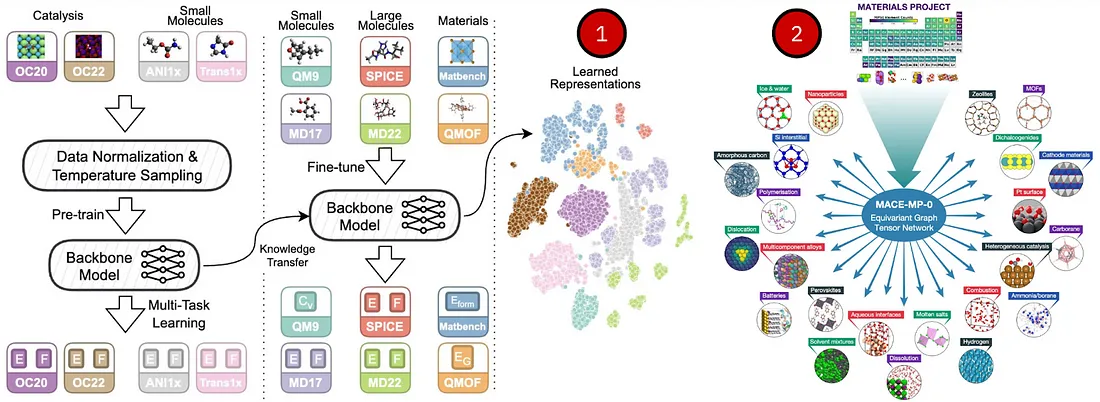

ML 电位: 用于分子的 JMP-1、DPA-2,用于无机晶体的 MACE-MP-0 和 MatterSim

设置:给定三维结构,预测该结构的能量和每个原子的作用力;

可转移的内容:元素周期表中的原子词汇。

ML 势能可根据三维坐标和可选输入(如晶体的周期性边界条件)估算化合物(如分子或周期晶体)的势能。对于任何原子模型,可能的原子词汇总是受元素周期表的约束,目前元素周期表包括 118 种元素。ML 电位的 "基础 "方面是将其推广到任何原子结构(可能有许多组合结构),并使其足够稳定,以用于分子动力学 (MD)、药物和材料发现管道。

同期发布的 JMP-1 和 DPA-2 就是这样的通用 ML 潜力模型--它们在从有机分子到晶体再到 MD 轨迹的各种结构上进行训练。例如,单个预训练的 JMP-1 在 QM9 和 rMD17(用于小分子)、MatBench 和 QMOF(用于晶体)以及 MD22 和 SPICE(用于大分子)方面表现出色,与专门的数据集模型相当或更好。同样,MACE-MP-0 和 MatterSim 是用于无机晶体的最先进的 FM(MACE-MP-0 已带有权重),已在 20 多项晶体任务(从多组分合金到燃烧和熔盐)中进行了评估。等变 GNN 是这些系统的核心,有助于处理等变特征(笛卡尔坐标)和不变特征(如原子类型)。

下一个前沿领域似乎是 ML 加速分子动力学模拟--传统的计算方法在飞秒尺度(10-15)下工作,需要数百万乃至数十亿步才能模拟一个分子、晶体或蛋白质。加快这种计算速度将产生巨大的科学影响。

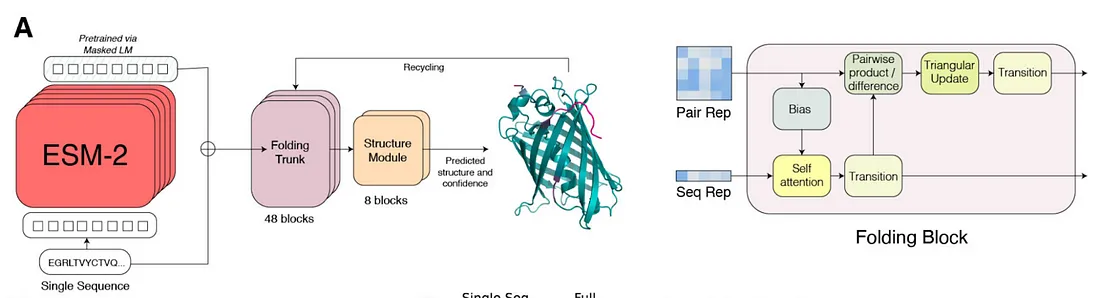

蛋白质 LM: ESM-2

设置:给定蛋白质序列,预测掩码标记,类似于掩码语言建模;

可转移的内容:20(22)个氨基酸词汇。

蛋白质序列类似于以氨基酸为标记的自然语言,而 Transformer 擅长序列数据的编码。虽然氨基酸的词汇量相对较小,但可能的蛋白质空间却非常大,因此在大量已知蛋白质上进行训练可能会提示未知组合的特性。ESM-2可能是最受欢迎的蛋白质 LM,这要归功于它的预训练数据量、各种可用的检查点和信息丰富的特征。

从预测三维结构(ESMFold)到蛋白质配体结合(DiffDock 及其后代),再到蛋白质结构生成模型(如最近的 FoldFlow 2),ESM 特征被广泛应用于各种应用中。更大的转换器和更多的数据可能会进一步提高蛋白质 LM 的性能--然而,在这种规模下,数据问题变得更加普遍(我们还将在专门章节中讨论架构与数据之间的相互作用),例如,ESM Metagenomic Atlas 已经编码了 7 亿多个结构,包括在人类以外的土壤、海洋或热液喷口中看到的结构。有没有一种方法可以像常见的 LLM 训练数据集那样编码数以万亿计的标记?

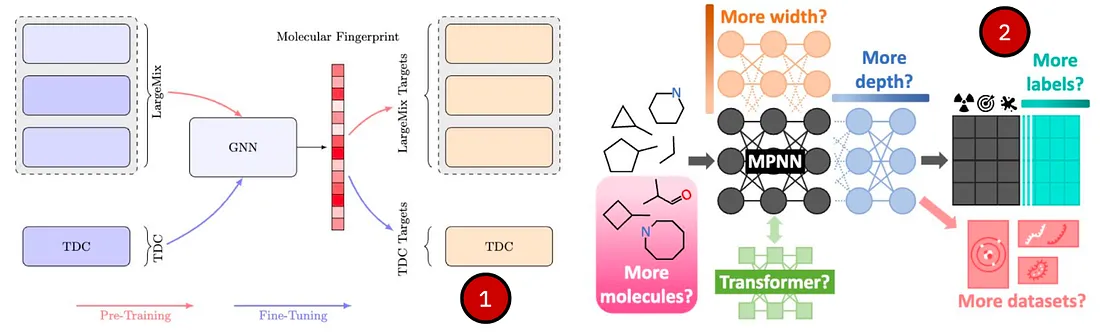

二维分子: MiniMol 和 MolGPS

设置:给定带有原子类型和键类型的二维图结构,预测分子性质

可转移的内容:元素周期表中的原子词汇和化学键类型

对于二维图形(没有三维原子坐标),通用编码和可转移性来自于原子和化学键类型的固定 词汇表,你可以将其发送给任何 GNN 或 Transformer 编码器。虽然分子指纹早在 20 世纪 60 年代就已开始使用(摩根指纹 [18]),但其主要目的是评估相似性,而不是为潜在空间建模。单个(大型)神经编码器的任务是学习可能暗示某些物理分子特性的有用表征。

最近,MiniMol 和 MolGPS 就是学习分子表征的通用模型范例,它们在大量分子图语料库上进行了训练,并在数十个下游任务中进行了探测。尽管如此,你仍然需要根据模型的表征,对单独的特定任务解码器/预测器进行微调--从这个意义上说,单一的预训练模型无法在所有可能的未见任务上运行零点推理,而只能在解码器已经训练过的任务上运行零点推理。不过,微调仍然是一个不错的廉价选择,因为这些模型比 LLM 要小得多。

表现力与缩放定律: 图形前沿模型会缩放吗?

LLM 和多模式前沿模型中的变换器是相当标准的,我们知道它们的一些基本缩放原理。变换器(作为一种架构,而非 LLM)在图上是否同样有效?在为图形前沿模型设计骨干网时,一般会遇到哪些挑战?

如果对前面介绍的模型进行分类,只有两个领域采用了变换器--具有自然顺序偏向的蛋白质 LM(ESM)和小分子(MolGPS)。其余的都是 GNN。这有几个原因:

- Vanilla 变换器无法扩展到任何大于标准上下文长度(大于 4-10k 节点)的合理大型图形。任何超过这个范围的情况都需要一些技巧,比如只输入子图(会丢失整个图结构和长程依赖关系)或线性注意(可能不具备良好的缩放特性)。相比之下,GNN 与边的数量呈线性关系,在稀疏图(V ~ E)的情况下,与节点的数量呈线性关系。

- 没有位置编码的 Vanilla 变换器的表现力不如 GNN。在一个有 V 个节点的图上挖掘位置编码(如拉普拉斯 PE)需要 O(V³)。

- 在通过变换器对图形进行编码时,什么应该是 "标记"?文献中没有明显的优胜者,例如,节点、节点 + 边或子图都是可行的选择

关于表现力,不同的图任务需要处理不同的对称性,例如,链接预测中的自动变形节点会导致无法区分的表示,而在图分类/回归中,要区分分子,就必须超越 1-WL 的范围,否则这些分子可能看起来与普通的 GNN 是同构的。

这一事实提出了两个问题:

全球飞行任务管理系统的表现力应该有多强?如何权衡表现力和可扩展性?

理想情况下,我们希望一个模型能够同样好地解决所有这些对称性问题。然而,更具表现力的模型在训练和推理时会导致更昂贵的计算架构。我们同意最近 ICML'24 关于图 ML 理论未来发展方向的立场文件,即社区应该在表现力、泛化和优化之间寻求平衡。

不过,值得注意的是,随着训练数据的可用性越来越高,推迟直接从数据中学习复杂的对称性和不变量(而不是将它们嵌入模型中)可能是一个计算成本更低的想法。AlphaFold 3 和 Molecular Conformer Fields 就是这一理论的最近几个很好的例子,它们在许多生成应用中达到了 SOTA,而无需昂贵的等变几何编码器。

说到缩放,模型和数据都应该放大。但是:

非几何图: 对于将 GNN 或转换器扩展到大型图以及节点分类和链接预测等常见任务,还没有原则性的研究。2 层 GraphSAGE 与庞大的 16 层图转换器往往相差无几。与此趋势类似,在 KG 推理领域,参数小于 20 万的单个 ULTRA 模型(上文已讨论)在 50 多个图上的表现也优于百万级别的浅层嵌入模型。为什么会出现这种情况?我们假设关键在于 1.任务性质--大多数非几何图都是有噪声的相似性图,与分子等具体物理现象无关 2.鉴于节点和边缘特征丰富,模型必须学习图结构的表示(常见于链接预测),或者仅仅学习给定特征的函数(一个很好的例子是 OGB 中的节点分类,通过添加 LLM 特征编码器实现了大部分增益)。

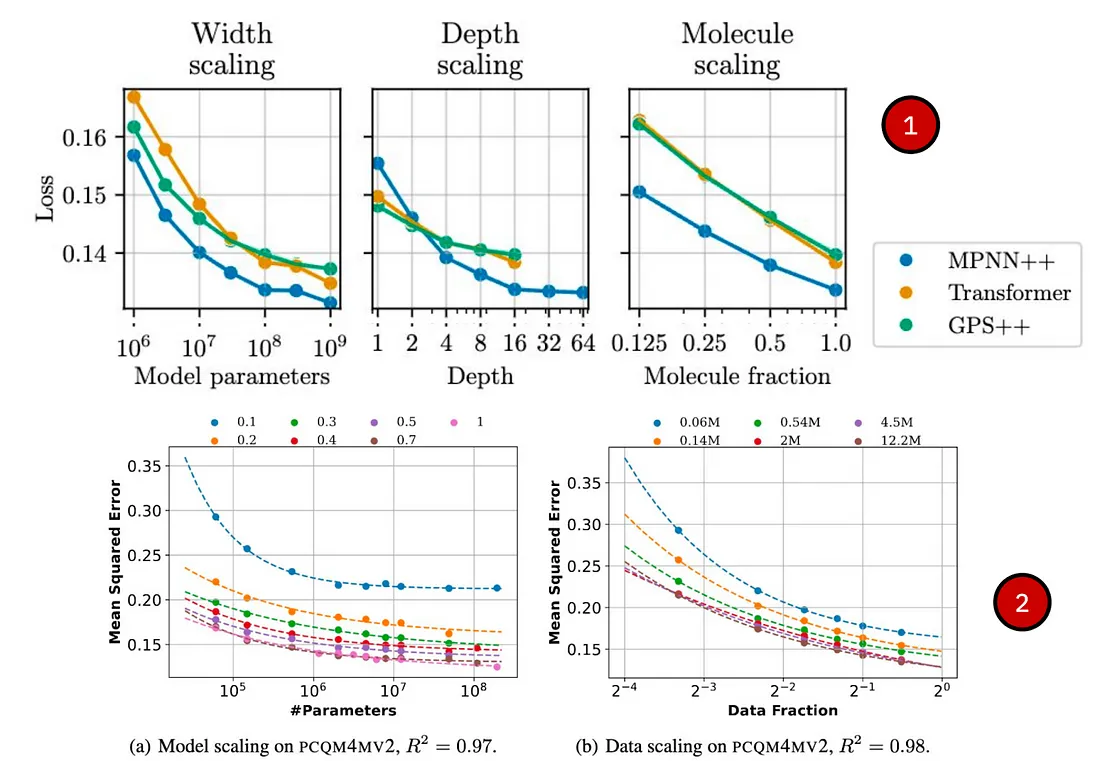

几何图谱: 最近有几项研究聚焦于分子图:

- Frey 等人(2023 年)研究了 ML 电位的几何 GNN 的缩放;

- Sypetkowski、Wenkel 等人(2024 年)介绍了 MolGPS,并研究了在 500 万个分子的大型数据集上缩放 MPNN 和图变换器,最多可缩放 1B 个参数。

- Liu 等人(2024 年)在多达 400 万个分子的分子数据集上对 GCN、GIN 和 GraphGPS 进行了高达 1 亿个参数的探测。

数据问题: 哪些数据需要缩放?是否有足够的图形数据来训练图形调频?

图表数据中什么应该缩放?节点?边?图的数量?还是其他?

文献中没有明确的答案,我们更倾向于使用更广泛的术语 "多样性",即图数据中模式的多样性。例如,在对大型产品图进行节点分类时,在具有 1 亿个节点或 10B 个节点的图上进行训练可能不会有太大影响,因为用户-项目图的性质是相同的。不过,在不同规模和稀疏程度的图中展示同亲和异亲的示例可能会非常有益。在 GraphAny 中,通过展示此类图的示例,我们可以建立一个强大的节点分类器,它可以通用于不同的图分布、

在使用 ULTRA 的 KG 推理中,我们发现预训练中关系模式的多样性在归纳概括中发挥了最大作用,例如,一个大型密集图比一系列较小但稀疏、密集、少关系和多关系图更糟糕。

在分子图级任务中,例如在 MolGPS 中,缩放具有不同物理性质的独特分子的数量有很大帮助(如上图所示👆)。

此外,UniAug 还发现,增加预训练数据中结构模式的覆盖范围,可以提高不同领域下游任务的性能。

有足够的数据来训练图谱调频吗?

公开的图形数据比自然语言标记、图像或视频要小很多个数量级,但也没有问题。这篇文章就包含了数千个语言和图像标记,但没有明确的图形(除非你尝试将这些文本解析为图形,如抽象意义表示图)。PDB 中已知结构的 "好 "蛋白质数量很少,已知的 "好 "药物分子数量也很少。

难道图形调用工具注定会因为数据稀缺而失败吗?

其实不然。有两条出路 (1) 更具样本效率的架构;(2) 使用更多黑盒数据和合成数据。

像 GraphWorld 这样的合成基准可能有助于增加训练数据的多样性,提高对真实世界数据集的泛化能力。反过来,从科学实验中获得的黑盒数据也可能成为人工智能4科学领域建立成功基础模型的关键因素--谁掌握了这些数据,谁就能在市场上占得先机。

总结

如何在具有不同节点/边/图特征的图中进行泛化?

- 非几何图形: 相对信息可以转移(例如 GraphAny 中的预测差异或 Ultra 中的关系交互),绝对信息则不能转移。

- 几何图形:由于原子集合固定,信息传递更容易,但模型必须学习一些物理概念才能可靠

如何在不同的预测任务中进行推广?

- 迄今为止,还没有一个模型(在非几何 GNN 中)能够在零次推理模式下执行节点分类、链接预测和图分类。

- 从一个角度来看待所有任务可能会有所帮助,例如,节点分类可以被视为链接预测。

什么是最佳模型表达能力?

- 节点分类、链接预测和图分类利用的是不同的对称性。

- 盲目应用表现力最强的模型很快就会导致指数级的运行复杂度或巨大的内存成本--需要保持表现力与效率之间的平衡。

- 表现力、样本复杂度(需要多少训练数据)和归纳概括之间的联系仍是未知数。

数据

- 公开的图表数据比文本/视觉数据小很多,因此模型必须具有采样效率。

- 缩放规律正处于新兴阶段,目前还不清楚应该缩放什么--节点数?边?元素?图中标记的概念是什么?

- 几何 GNN:有更多的实验数据可供使用,这些数据对领域专家来说意义不大,但对神经网络可能很有价值。