Anthropic Claude 3.5 Sonnet:可解释 AI 的未来

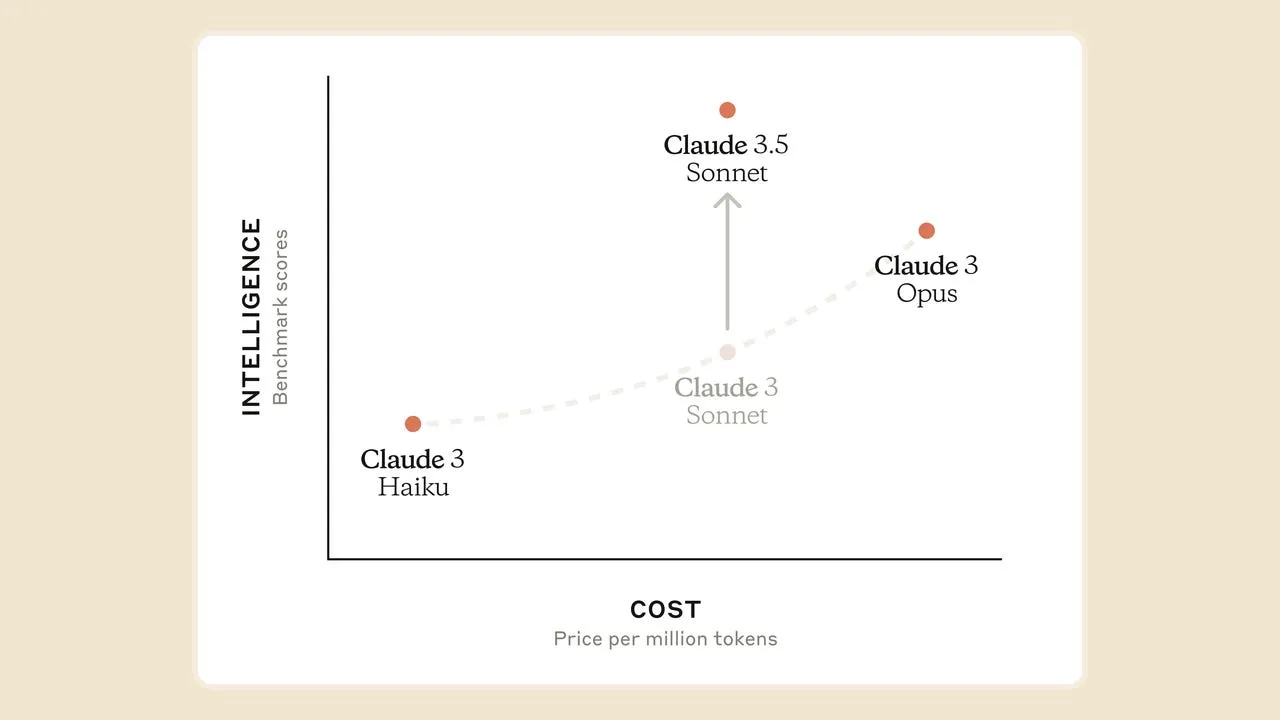

最近,Anthropic 推出了最新的 LLM 机型 Claude 3.5 Sonnet,人工智能界都为之震惊,更不用说全世界了。它不仅速度是其前身 Claude 3 Opus 的两倍,而且成本也只有后者的一半"。

以下是 Claude 3.5 sonnet 的一些亮点:

- 性能: 在各种基准测试中,包括语言能力、基于视觉的任务和编码能力等方面,它都优于以前的商用 LLM 型号,优于 GPT-4o 和 Gemini 1.5。

- 经济实惠: 它以 Anthropic 中级型号 Claude 3 Sonnet 的成本实现了性能的提升。

- 可访问性: 它可在 claude.ai 上免费使用(有每日使用限制),但付费计划可以提高使用限制。它还可以与 GCP 和 AWS 等云平台轻松集成,在一个地方构建生成式人工智能应用程序。

- 独特功能: 在最近发布的版本中,Sonnet 3.5 引入了一项名为 "artifacts "的独特功能--用户可以在侧边窗口中看到生成内容(图片、代码、视觉效果、图表等)的实时过程。

我想双击这一功能,深入了解其潜在影响。

这一看似简单的创新--允许用户在单独的窗口中查看和编辑人工智能生成的内容(如代码或文档)--有可能彻底改变可解释人工智能(XAI)领域。

可解释人工智能的精妙介绍:

在这个变革性的生成式人工智能时代,像 ChatGPT 或 DALL-E 这样的生成式模型在普通大众眼中就像魔术师一样,它们生成的文本和图像输出类似于人类的触摸。随着这些模型演变成更加复杂的系统,理解它们如何获得特定输出变得越来越具有挑战性。

这些生成式人工智能模型的 "黑箱 "性质提出了一些关键问题,如模型的可理解程度如何?其反应背后的推理是什么?它能否很好地证明自己的逻辑?这就是可解释人工智能(XAI)的作用,它是一个相当新颖的概念,旨在将生成模型的强大功能与可解释性结合起来,确保整个过程不仅透明,而且合乎道德。

让我们举个例子: 你是一名金融分析师,你正在使用人工智能来检测投资中的风险,你向人工智能模型输入数据,它进行分析并输出响应,比如投资 A 比投资 B 风险更高,现在你如何向你的经理进一步解释这一分析背后的原因?该模型得出这一结论的假设和偏差是什么? 诸如此类的问题还有很多。

在这里,了解底层算法如何得出这些答案是至关重要的。让我们深入了解可解释人工智能是如何诞生的。

Black Box里有什么?

像 GPT-4 和克劳德 3 这样的生成式人工智能模型被称为 "黑盒模型"。它们将用户的提示作为输入,通过数十亿个参数进行运算,然后给出适当的响应。由于它们的复杂性,要跟踪它们从输入到输出的具体过程几乎是不可能的。

对可解释人工智能的需求是什么?

对可解释人工智能的需求产生于以下一些原因:

1. 对人工智能模型缺乏信任 由于人工智能模型的黑箱性质,决策者很难指出模型是如何得出最终结果的,因此依赖这类系统变得相当困难。可解释的人工智能可以让利益相关者了解整个过程,并深入了解模型的推理过程。

2. 无法调试或排除故障 在使用人工智能模型时,由于其缺乏透明度,很容易成为不准确或不可靠输出的目标。可解释的人工智能可以帮助你尽早调试和排除模型的错误。可解释的人工智能可以帮助找出错误发生的原因,并防止它在未来发生。

3. 难以发现的偏差和其他模型缺陷 人工智能模型在训练过程中容易出现偏差,或数据集偏斜,或任何 "n "种原因。在这种情况下,"可解释的人工智能 "通过识别偏差的真正来源并采取适当的措施来解决它们,从而起到了拯救作用。

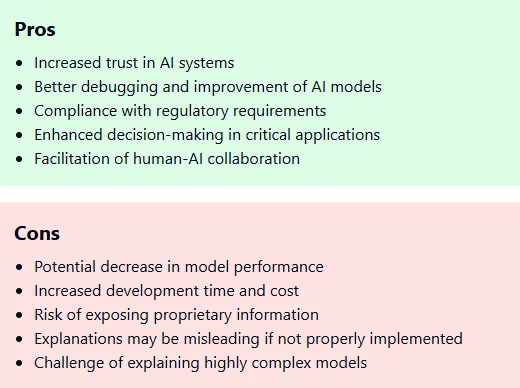

可解释人工智能的优缺点:

回到Claude

结合Claude 3.5 首十四行诗: 传统上,LLM 因其运作缺乏透明度和可解释性而受到批评。用户在没有完全理解其背后过程的情况下就得到了回应。有了克劳德最新的 "人工制品"(Artifacts)功能,用户就有了进入 "黑盒子 "的秘密通道。有了显示幕后情况的侧窗功能,用户就可以将回复隔离开来,切分其布局/结构,分析其中的组成部分,并找出潜在的偏差或错误。

如果用户发现工件中存在不准确之处,他可以自行编辑并修正输出。这就形成了一个调试、测试和不断改进 LLM 生成输出的迭代过程。也许经过一段时间后,未来的模型就能从交互中学习并提高其整体准确性。

结论

Artifacts 功能是朝着建立一个功能强大且可解释的生成式人工智能生态系统迈出的重要一步。虽然当前版本的 sonnet 支持从编辑角度看人工制品,但未来的修订版可能会允许用户从底层看到每个生成组件背后的原理。这种程度的透明度将改变游戏规则,加深对人工智能决策过程的理解和信任。