腾讯混元DiT升级:推出6G小显存版本,支持Kohya训练

腾讯近期宣布,其混元文生图大模型(混元DiT)已推出小显存版本,该版本对硬件要求显著降低,仅需6G显存即可运行,极大地方便了个人电脑用户进行本地部署和开发。此版本已与Diffusers库中的LoRA、ControlNet等插件完成适配,并新增了对Kohya图形化界面的支持,进一步降低了开发者训练个性化LoRA模型的门槛。

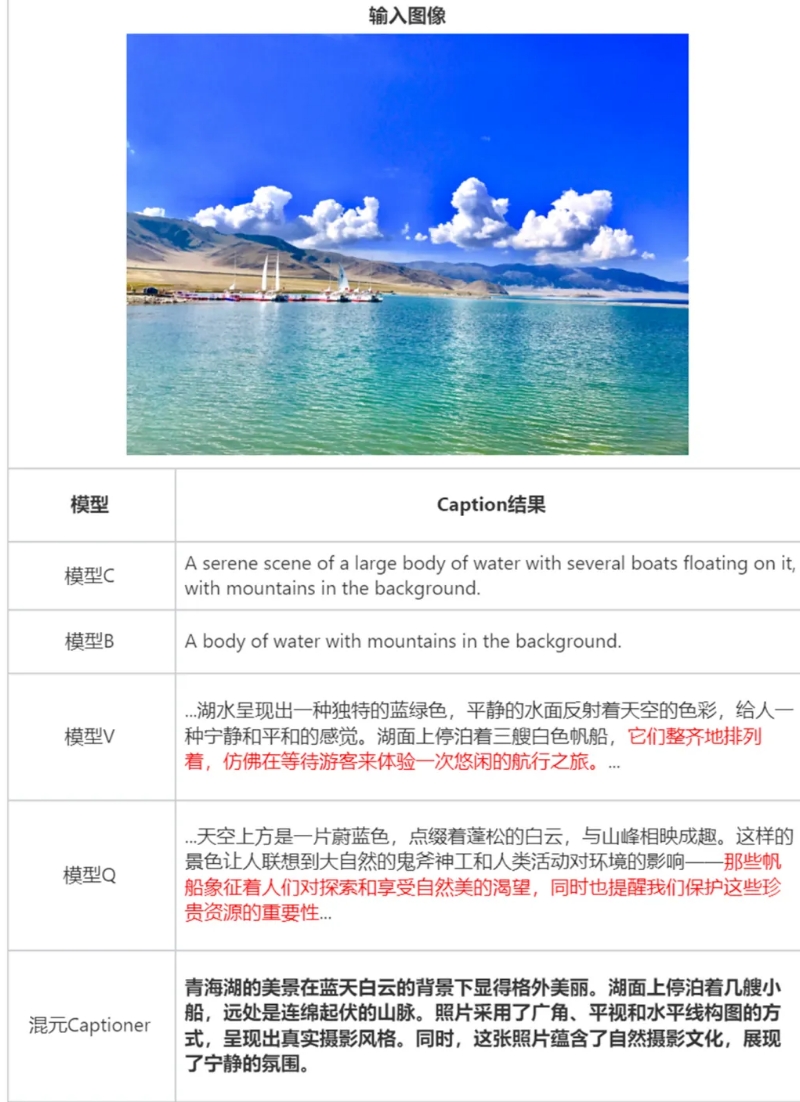

同时,混元DiT模型升级至1.2版本,在图像生成的质量和构图能力上均有所提升,为用户带来更加优质的文生图体验。此外,腾讯还正式开源了“混元Captioner”打标模型,该模型专注于文生图场景,支持中英文双语,能够更精准地理解与表达中文语义,生成的图片描述更为结构化、完整和准确,尤其擅长识别知名人物与地标。

混元Captioner的开源,意味着开发者可以快速生成高质量的文生图数据集。通过将原始图片集或图片与描述导入该模型,开发者可以获得结构化的、高质量的标注,从而提升数据集的质量。该模型还允许开发者补充和导入个性化的背景知识,以满足特定需求。

值得注意的是,混元DiT小显存版本的推出,是与Hugging Face合作的结果,双方共同将这一版本及LoRA、ControlNet插件适配至Diffusers库,简化了调用流程,使得开发者仅需简单几行代码即可实现功能调用。此外,混元DiT还接入了Kohya平台,通过图形化界面,开发者可以方便地进行模型的全参精调和LoRA训练,进一步降低了技术门槛。

混元Captioner模型则针对文生图场景进行了优化,通过构建结构化的图片描述体系和注入多种来源的背景知识,提升了描述的完整性和准确性。这一模型的出现,有望解决业界在图片描述文本生成方面存在的描述简单、繁琐或缺乏背景知识等问题,尤其对于中文用户来说,其精准的中文描述能力将是一大亮点。

自全面开源以来,混元DiT模型凭借其易用性和高性能,受到了众多开发者的关注和支持。短短两个月内,其在Github上的Star数已超过2.6k,成为最受欢迎的国产DiT开源模型之一。腾讯方面表示,将继续致力于完善混元DiT的生态建设,为开发者提供更加便捷、高效的工具和服务。