InternLM开源发布最新大型语言模型InternLM2.5-7B-Chat

近日,InternLM正式推出了其最新的开放大型语言模型——InternLM2.5-7B-Chat,该模型以创新的GGUF格式呈现,完美兼容llama.cpp这一前沿的LLM(大型语言模型)推理开源框架。这一兼容性使得InternLM2.5-7B-Chat能够在从本地到云端的各种硬件平台上自由驰骋,满足多样化的应用需求。

GGUF格式的引入,为模型提供了丰富的版本选择,包括半精度和多种低位量化版本(如q5_0、q5_k_m、q6_k、q8_0),极大地提升了模型在不同场景下的灵活性和效率。

作为InternLM系列的又一力作,InternLM2.5-7B-Chat在继承前代模型优势的基础上,实现了全面升级。该模型不仅拥有70亿参数的强大基础,还精心打造了一个专为实际聊天场景设计的模型版本。其卓越的推理能力,尤其是在数学推理方面,已超越Llama3、Gemma2-9B等业界知名模型,展现出非凡的竞争力。

尤为值得一提的是,InternLM2.5-7B-Chat拥有令人瞩目的100万上下文窗口,这在LongBench等评估长上下文任务的基准测试中,几乎达到了完美的表现。这一特性使得模型在处理复杂对话、从海量文档中精准检索信息等方面具有得天独厚的优势。

为了进一步发挥模型的长处,InternLM2.5-7B-Chat特别推出了-1M变体,专为100万长上下文推理而设计。然而,这一高性能版本的运行需要强大的计算资源支持,如配备4xA100-80G GPU的服务器。

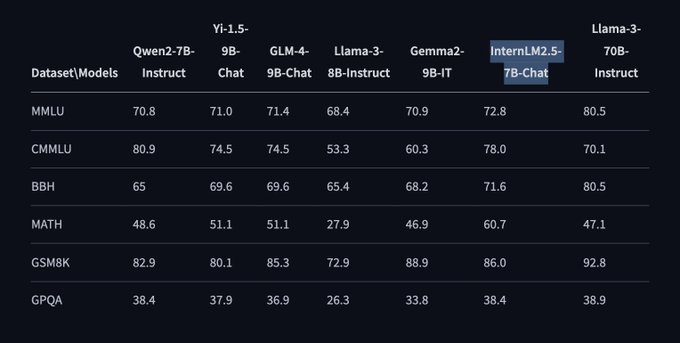

在OpenCompass工具的性能评估下,InternLM2.5-7B-Chat在学科能力、语言能力、知识能力、推理能力和理解能力等多个维度均展现出卓越表现。在MMLU、CMMLU、BBH、MATH、GSM8K、GPQA等一系列权威基准测试中,该模型均以优异成绩领跑,如MMLU基准测试得分高达72.8,遥遥领先于Llama-3-8B-Instruct和Gemma2-9B-IT等竞争对手。

此外,InternLM2.5-7B-Chat还具备出色的工具使用能力,能够支持从超过100个网页收集信息,为用户带来前所未有的便捷体验。即将发布的Lagent将进一步增强这一功能,使模型在指令跟随、工具选择和反思等方面更加智能和高效。

为了方便用户快速上手,InternLM提供了详尽的安装指南、模型下载说明以及模型推理和服务部署的示例代码。用户还可以利用lmdeploy框架对量化模型进行批量离线推理,享受INT4权重量化和部署(W4A16)带来的高效能。在兼容的NVIDIA GPU上,该设置相比FP16格式可提升2.4倍的推理速度,为用户带来极致的性能体验。