英伟达推出一种新颖的RAG框架:引领LLM性能飞跃

在大型语言模型(LLM)处理专业知识、提供最新信息及适应特定领域的征程中,检索增强生成(RAG)技术已成为不可或缺的关键一环,且无需改动模型核心权重。然而,当前RAG流程遭遇的瓶颈不容忽视:LLM在高效整合海量分块信息时显得力不从心,尤其是在确保高召回率的同时筛选有限数量的高质量上下文方面面临挑战。尽管排序模型能在一定程度上优化上下文选择,但其零样本泛化能力常受限于LLM的多元化功能。因此,探索一种更高效的RAG方法,以平衡高召回率与高质量内容生成,成为当务之急。

面对这些挑战,研究界已展开广泛探索,从检索器与LLM需求对齐,到多步检索与上下文过滤策略,再到指令调优技术的引入,均旨在提升RAG系统的效能。尽管排序方法作为中间环节提高了信息检索的质量,但其依赖的附加模型如BERT或T5,在捕捉查询-上下文相关性和零样本泛化方面仍显不足。而LLM自身强大的排序潜力,在RAG系统中的整合尚待深入挖掘。

在此背景下,NVIDIA与乔治亚理工学院的研究团队携手推出了RankRAG框架,这一创新之举旨在全面增强LLM在RAG任务中的表现。RankRAG独辟蹊径,通过指令调优单个LLM,实现了在RAG框架内的上下文排序与答案生成的一体化执行。该框架通过融合上下文丰富的问答、检索增强的QA及排序数据集,扩展了指令调优的训练素材,旨在提升LLM在检索与生成阶段过滤无关信息的能力。

RankRAG框架的核心在于其独特的任务设计,即专注于识别与给定问题高度相关的上下文段落。这一排序任务以常规问题回答的形式进行指令,与RAG任务紧密契合。在推理阶段,LLM首先对检索到的上下文进行智能重排序,筛选出最相关的top-k上下文,并据此生成精准答案。这种多功能的解决方案,为广泛的知识密集型NLP任务提供了统一的性能提升途径。

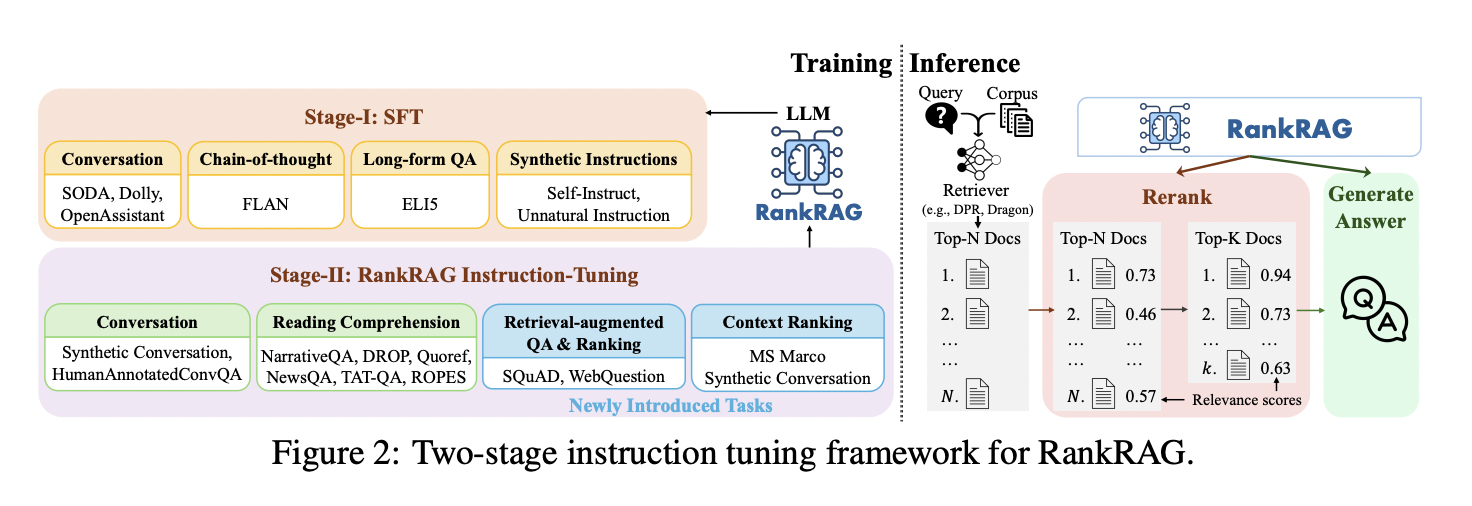

RankRAG的实施经历了精心设计的两阶段指令调优过程:第一阶段在多样化的指令跟随数据集上进行监督微调;第二阶段则将排序与生成任务整合,利用综合数据集进行统一训练。所有任务均标准化为(问题、上下文、答案)格式,促进了知识的高效传递。在推理流程中,RankRAG遵循“检索-重新排序-生成”的路径,显著提高了上下文相关性的评估精度及答案生成的质量。

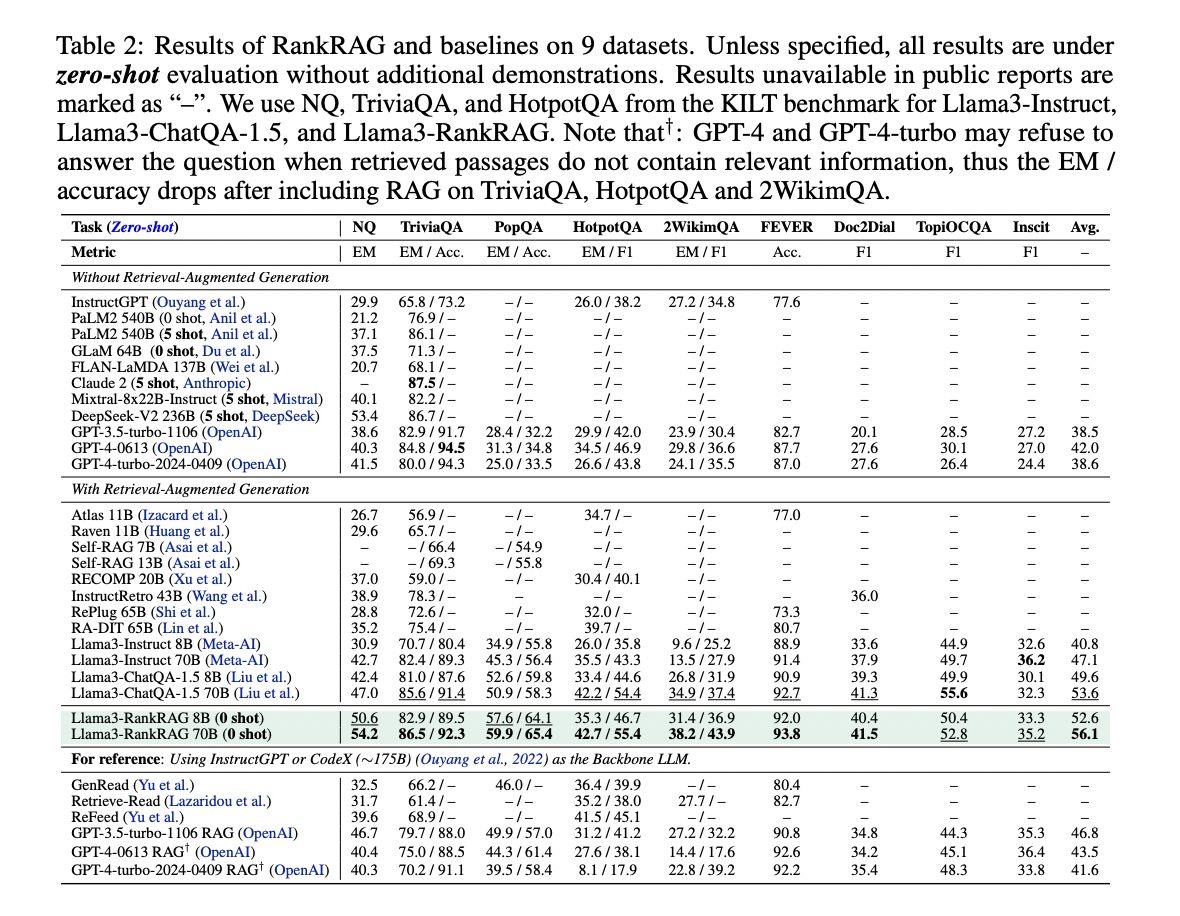

在基准测试中,RankRAG展现了令人瞩目的性能优势。无论是与参数相当的ChatQA-1.5模型相比,还是在面对参数规模更大的对手时,RankRAG均表现出色。特别是在处理复杂查询和多样化知识领域时,其性能提升尤为显著。在长尾QA和多跳QA等挑战性数据集上,RankRAG相较于ChatQA-1.5的改进幅度超过10%,凸显了其在低相关性顶级检索文档情况下的卓越排序能力。

综上所述,RankRAG框架的提出标志着RAG系统的一次重大飞跃。通过指令调优单个LLM以同时执行上下文排序与答案生成任务,RankRAG不仅简化了系统架构,还显著提升了RAG在多个领域的综合性能。这一创新方法为增强RAG系统的整体效能开辟了新途径,预示着未来自然语言处理技术的无限可能。