Anthropic推出新控制台功能以增强AI提示工程

2024年07月11日 由 samoyed 发表

250

0

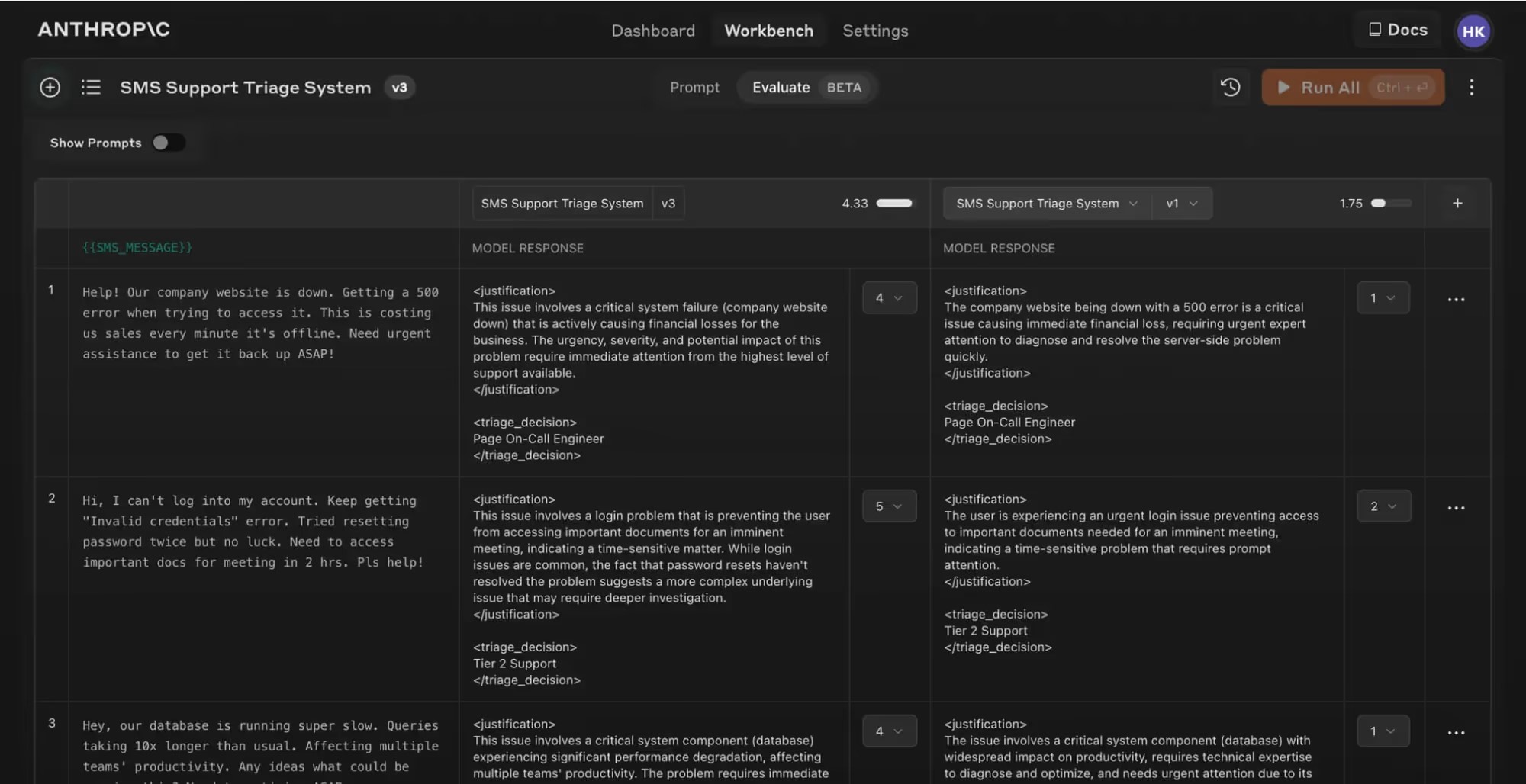

Anthropic 正在为使用其模型进行开发的 AI 开发者们的生活带来一丝便利。该公司最近为 Claude控制台推出了新功能,据称这些功能将有助于消除构建有效提示的猜测工作。新的“评估”标签允许开发者生成提示、自动创建测试用例,并并排比较输出。

Anthropic 在一篇博客文章中解释道:“提示的质量对结果有着显著影响。但是,编写高质量的提示是一项具有挑战性的任务,需要深入了解应用需求以及大型语言模型的专业知识。”

今年早些时候,Anthropic 发布了一个提示生成器辅助工具,允许开发者用自然语言描述他们的任务,并收到一个量身定制的高质量提示作为回报。仅这一功能就大大减少了创建有效 AI 交互所需的时间和专业知识。

现在,这个经过更新的提示生成器由 Claude 3.5 Sonnet 提供支持,将使用适当的双括号语法({{variable}})创建包含动态变量的提示,这是创建评估测试集所必需的。

一旦提示准备就绪,开发者现在可以使用 Claude 自动根据提示生成逼真的输入数据。然后,他们可以使用新的“评估”功能进行更强大的测试。

在“评估”页面上,您可以根据需要设置尽可能多的测试用例——使用 Claude 生成它们、手动添加它们,或从 CSV 文件中导入多个测试用例。一旦测试套件设置完毕,开发者只需一键即可运行所有测试用例,并查看其提示在各种场景下的表现。

一个非常实用的功能是能够并排比较不同提示的输出。这有助于更细致地了解提示的更改如何影响结果,从而实现更快更有效的迭代。此外,主题专家还可以根据5分制对响应质量进行评分,提供宝贵的反馈,说明更改是否带来了改进。

目前,评估工具正处于测试阶段,Anthropic 控制台的所有用户均可使用。

文章来源:https://www.maginative.com/article/anthropic-introduces-new-console-features-to-enhance-ai-prompt-engineering/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消