“视觉”AI模型可能根本看不见任何东西

最新的语言模型,如GPT-4o与Gemini 1.5 Pro,均被冠以“多模态”之名,意味着它们不仅能解析文本,还能处理图像与音频信息。然而,一项最新研究却揭示了一个出人意料的真相:这些模型或许并不具备我们直观理解的“视觉能力”。实际上,它们可能处于“视而不见”的状态。

首先,我们需明确一点,没有任何一方宣称这些AI的视力能媲美人类。但在市场推广与基准测试中,“视觉能力”、“视觉理解”等词汇频繁出现,营造出一种模型能像人一样“看”并分析的错觉。它们被描绘成能解决作业难题、陪伴观看赛事的视觉助手。

实则,这些描述背后隐藏的是模型对输入数据的模式匹配能力,无论是处理数学、写作还是图像,皆是如此。这种机制导致,即便在看似简单的任务上,模型也可能频频失误,比如无法准确随机选择数字。

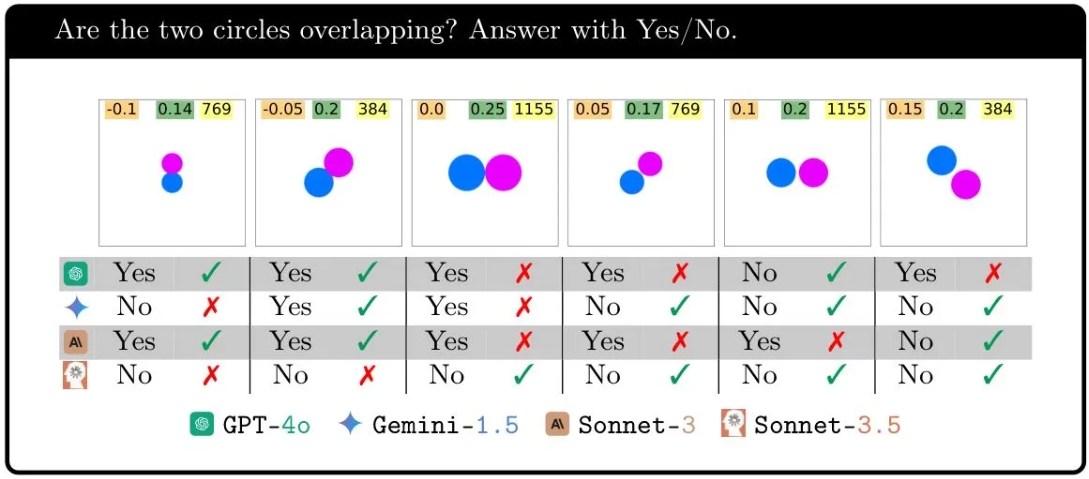

奥本大学与阿尔伯塔大学的研究团队,对当前顶尖的多模态AI模型进行了一场非正式却系统的视觉理解力测试。他们设计了一系列基础视觉任务,如判断两个形状是否重叠、计算图片中五边形的数量,或是识别被圈出的字母。这些任务对一年级学生而言轻而易举,却让AI模型大费周章。

“我们设计的七项任务均极为简单,人类能轻松达成100%准确率。我们原本期待AI也能如此,但现实却远非如此。”合著者Anh Nguyen在给TechCrunch的邮件中坦言,“我们的实验表明,即便是最好的模型,也仍在不断失败。”

以重叠形状测试为例,这是视觉推理中最基础的任务之一。当呈现两个圆圈时,无论它们是轻微重叠、恰好接触还是相隔一定距离,模型的表现却极不稳定。特别在圆圈近距离或接触时,GPT-4o的正确率骤降至18%,而Gemini Pro 1.5即便表现最佳,也仅达到七成准确率。

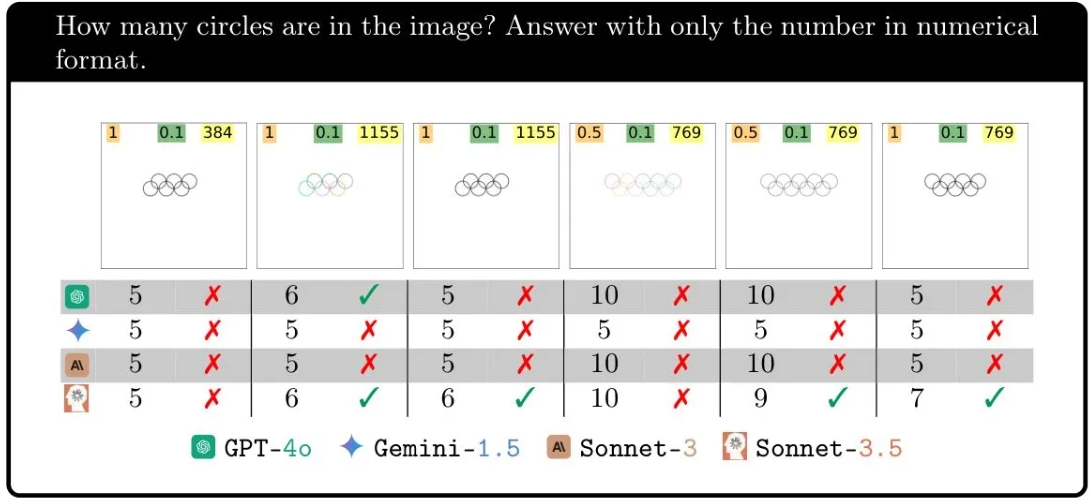

再来看圆环计数任务,当图像中有五个圆环时,各模型均能完美应对,但一旦增加一个圆环,它们便纷纷“失明”。Gemini从未答对过六个圆环的情况,Sonnet-3.5仅有三分之一时间正确,GPT-4o也仅略高于此。更有趣的是,增加圆环数量有时会让任务变得更为复杂,有时却反而变得简单,这完全取决于模型的“心情”。

这一系列实验的核心在于揭示:无论这些模型如何运作,它们的行为都与我们理解的“看见”大相径庭。

其他测试任务也呈现出类似模式,问题不在于它们的视觉或推理能力强弱,而是它们似乎遵循着某种难以捉摸的规律,在特定情境下能正确计数,在另一情境下则完全失效。

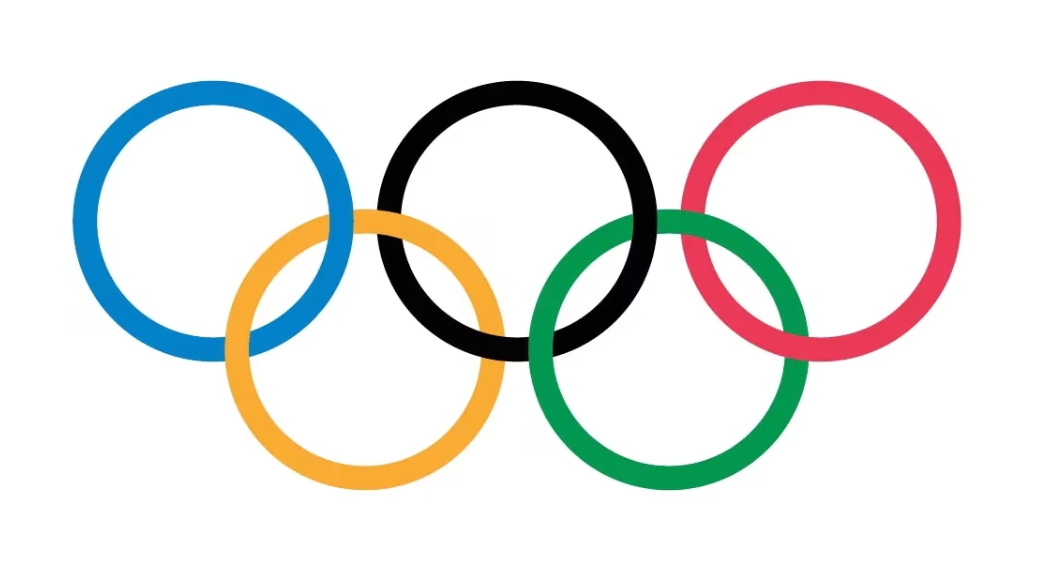

一个显而易见的解释是:为何模型能精准识别五个圆环的图像(如奥运五环),却在其他情况或面对五个五边形时屡战屡败?原因在于,它们的训练数据中频繁出现奥运五环的图像,这一标志不仅被反复训练,还可能在各类文档、指南中频繁提及。然而,对于六个、七个交错圆环的图像,训练数据中却鲜有踪迹,模型自然无从应对。

当被问及如何看待模型这种“盲目性”时,Nguyen表示:“‘盲目’一词对人类而言有多重含义,目前尚无精确词汇来描述AI对图像的这种非直观、不敏感的状态。技术上,我们还无法准确窥见模型眼中的世界。它们的行为是文本提示、图像输入与数十亿权重间复杂交织的结果。”

他推测,模型并非全然盲目,它们从图像中提取的信息是近似且抽象的,类似于“左侧有一个圆圈”的描述。但模型缺乏进行视觉判断的手段,它们的反应更像是被告知图像内容却无法亲眼所见的人。

这是否意味着这些“视觉”AI模型一无是处?答案显然是否定的。它们在特定领域,如人类行为表情分析、日常物体与场景识别等方面,仍能展现出高度准确性,这正是它们的设计初衷。

若仅凭AI公司的营销宣传来判断模型能力,我们或许会误以为它们拥有20/20的完美视力。但此类研究至关重要,它提醒我们:无论模型在判断人物动作(坐、走、跑)时多么精准,其背后的逻辑与我们所理解的“看见”仍相去甚远。