Google:关于Speculative RAG的研究

为什么选择 RAG

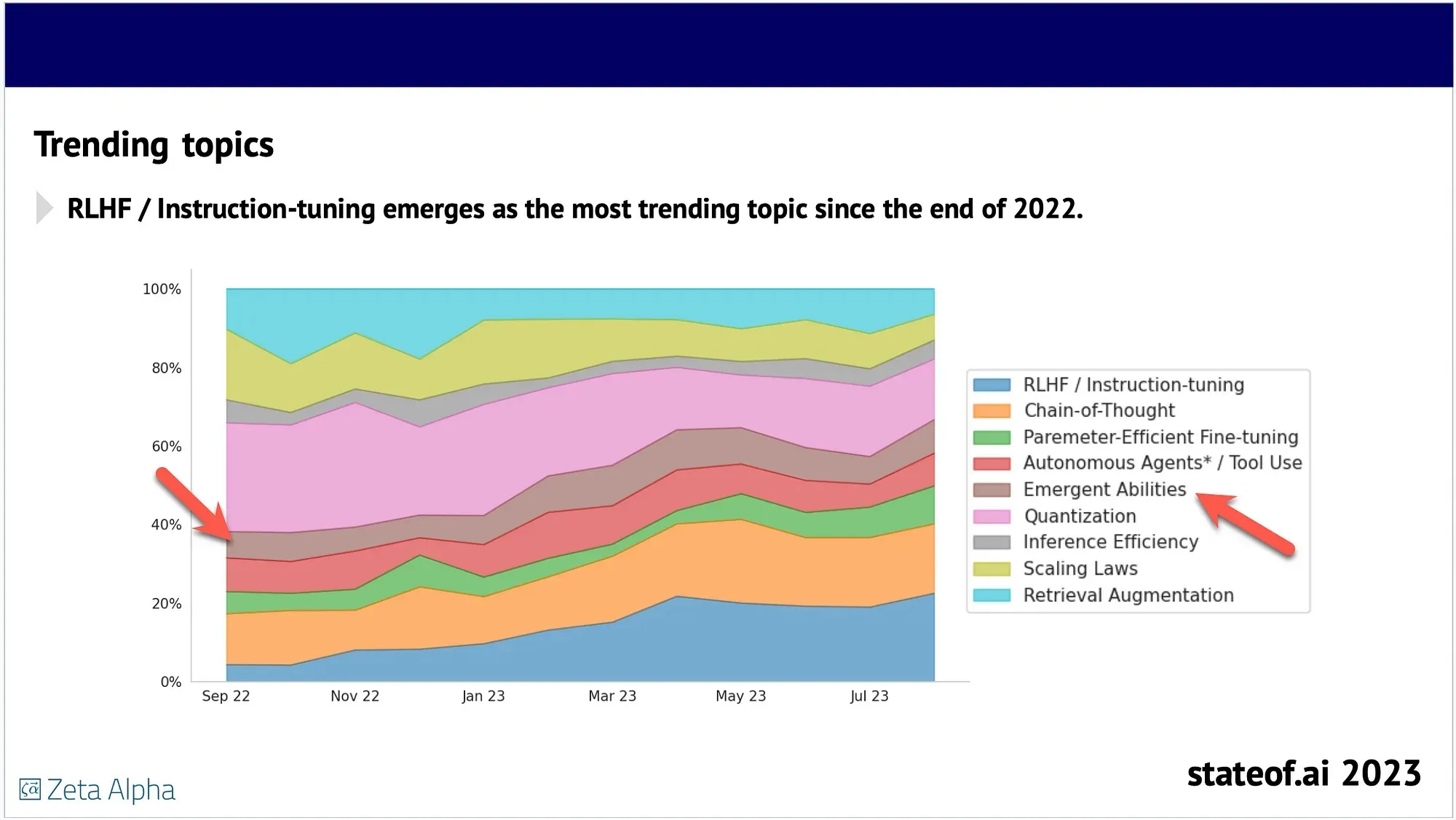

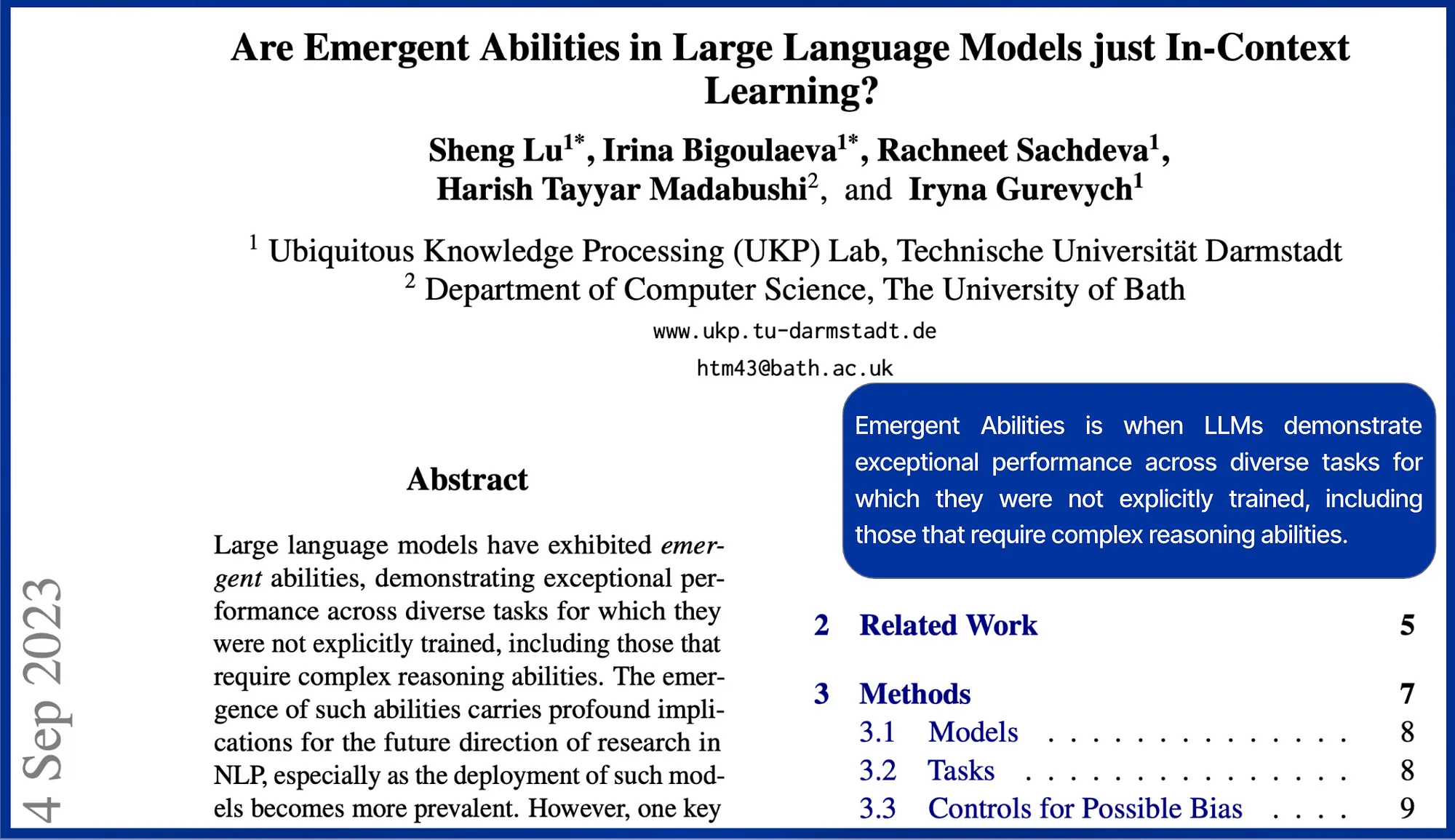

突发能力

直到最近,人们才发现 LLM拥有突发能力,即在与用户或任务交互过程中出现的意想不到的功能。

这些能力包括:

解决问题: LLM 可以利用其语言理解和推理能力,为没有经过明确训练的任务提供有见地的解决方案。

适应用户输入: LLM 可以根据特定的用户输入或上下文调整自己的响应,从而在交互中展现出一定程度的个性化。

即使提示中没有明确说明,对情境的理解也能让 LLM 生成与特定情境相关且合适的回复。

新兴能力现象促使组织探索未知的 LLM 功能。然而,最近的一项研究推翻了这一概念,揭示了看似新兴的能力实际上是后勤管理者对所提供情境的强烈反应。

指令和上下文参考

LLM 在推理时能很好地响应指令,并且在提示包含上下文参考数据时表现出色。大量研究经验证明,LLM在推理时会优先考虑提供的上下文知识,而不是模型经过微调的数据。

上下文学习

情境学习是指模型根据用户或任务提供的特定情境调整和完善其响应的能力。

这一过程使模型能够通过考虑其运行的上下文来生成更相关、更一致的输出。

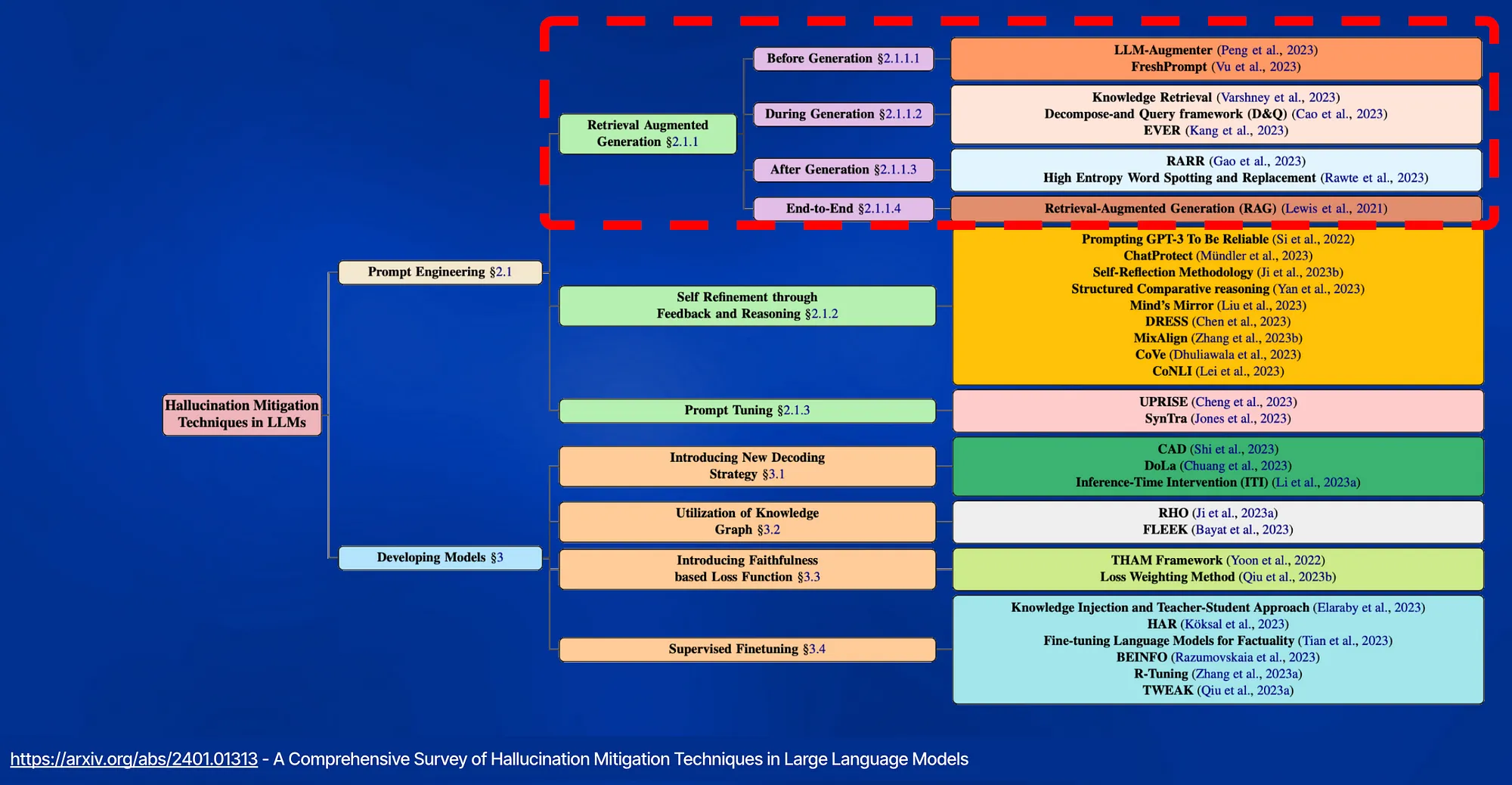

幻觉

在推理时为 LLM 提供上下文参考,从而实现上下文学习,可减轻幻觉。

检索增强生成(RAG)将大型语言模型(LLM)的生成能力与外部知识源相结合,以提供更准确和最新的响应。

最近的 RAG 进展侧重于通过迭代 LLM 改进或通过 LLM 的额外指令调整获得的自我批判能力来改进检索结果。

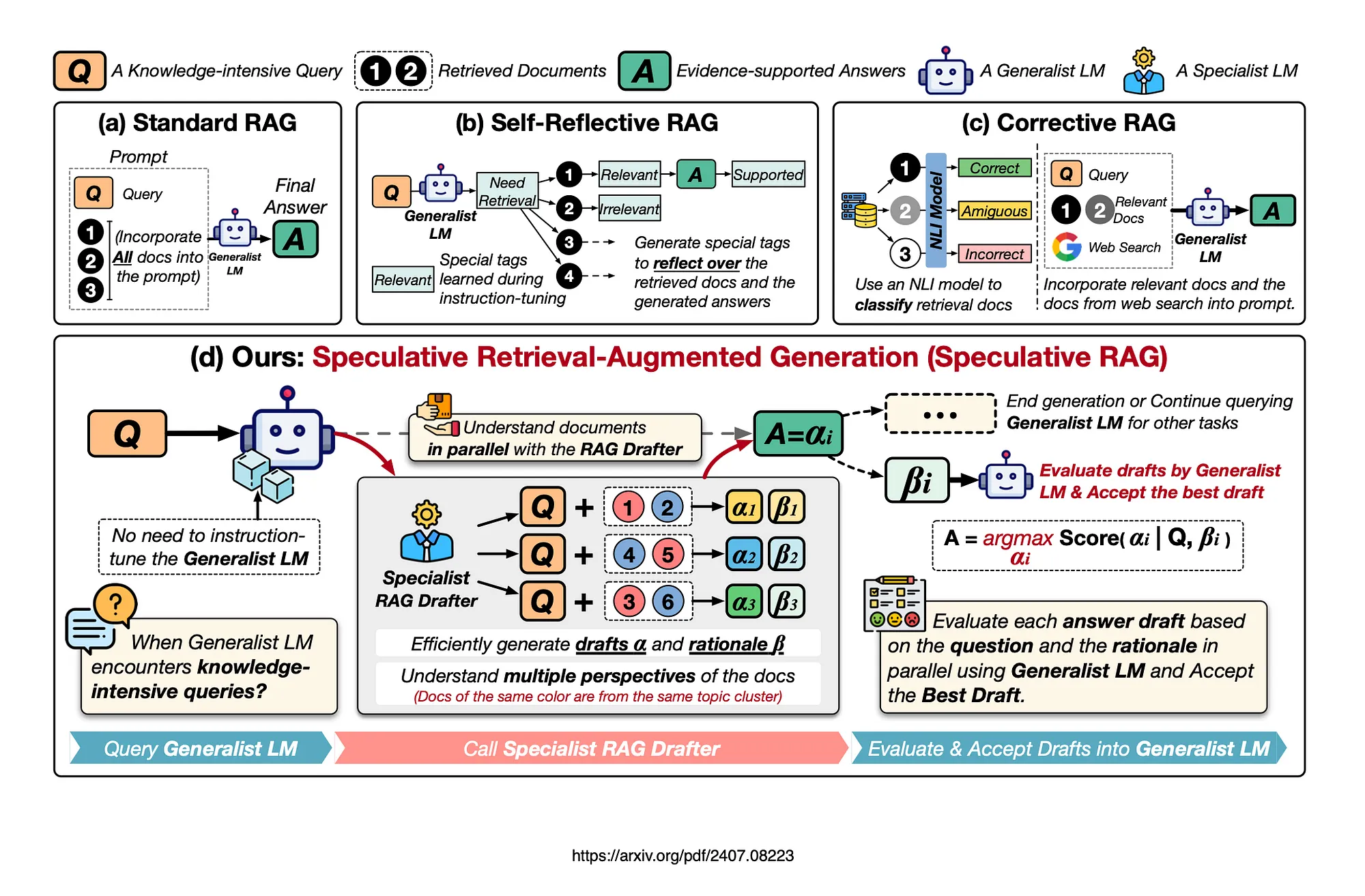

推测式 RAG

下图显示了 RAG 的不同方法,包括:

- 标准 RAG、

- 自我反思 RAG &

- 纠正性 RAG。

标准 RAG:根据 Google 的说法,标准 RAG 将所有文档都纳入提示,从而增加了输入长度并减慢了推理速度。原则上这是正确的,但也有一些变化,如使用摘要、重新排序和要求用户反馈等。

此外,还对分块策略以及如何优化相关分块中的上下文分割进行了深入研究。

自我反思式 RAG 需要对通用语言模型(LM)进行专门的指令调整,以生成用于自我反思的特定标记。

纠正性 RAG 使用外部检索评估器来改进文档质量。这种评价器只关注上下文信息,而不增强推理能力。

投机性 RAG 利用较大的通用 LM 来有效验证由较小的专用 LM 并行生成的多个 RAG 草案。

每个草稿都是从检索到的文件中的一个不同子集生成的,从而为证据提供了不同的视角,同时最大限度地减少了每个草稿的输入标记数量。

推测式 RAG 是一个框架,它使用一个较大的通用语言模型来有效验证由较小的专业化提炼语言模型并行生成的多个 RAG 草案。

每个草案都基于检索文档的一个不同子集,从而提供了不同的视角,并减少了每个草案的输入标记数。

研究表明,这种方法可以提高理解能力,并减少长语境中的位置偏差。通过将起草工作委托给较小的模型并让较大的模型执行单次验证,Speculative RAG 加快了 RAG 流程。

实验表明,Speculative RAG 在减少延迟的同时实现了最先进的性能。

与传统的 RAG 系统相比,准确率提高了 12.97%,延迟减少了 51%。

如何实现

这种新的 RAG 框架使用较小的专业 RAG 绘图仪生成高质量的答案草稿。

每个草案都来自检索文档的一个不同子集,从而提供了不同的视角,并减少了每个草案的输入标记数。

通用 LM 与 RAG 起草器协同工作,无需额外调整。

它可验证并将最有希望的草稿整合到最终答案中,从而增强对每个子集的理解,并减少 "中间丢失 "现象。

谷歌认为,这种方法通过让较小的专业 LM 处理草稿,而较大的通用 LM 则并行地对草稿执行单一、无偏见的验证,从而大大加快了 RAG 的速度。

在四种自由形式问题解答和封闭集生成基准上进行的广泛实验证明了这种方法的卓越效果和效率。

主要考虑因素

- 这项研究是一个很好的例子,说明了小语言模型是如何在一个采用模型协调的更大框架中使用的。

- SLM 具备专门创建的推理能力。

- 在这种情况下,小语言模型是理想的选择,因为在实施过程中,它们并不需要是知识密集型的。相关的上下文知识将在推理时注入。

- 该框架的目的是优化令牌数量,从而降低安全成本。

- 与传统的 RAG 系统相比,延迟降低了 51%。

- 提高准确率达 12.97%。

- 避免对模型进行微调。

- 多个 RAG 草案由更小、更专业的语言模型并行生成。

- 这种更小、更专业的 RAG 模型擅长对检索到的文档进行推理,并能快速生成准确的回复。这不禁让人联想到经过训练具有卓越推理能力的 SLM Orca-2 和 Phi-3。

- 使用 Mistral 7B SLM 作为 RAG 绘图仪取得了最佳效果。

- 验证器为 Mixtral 8x7B。