DeepMind的PEER架构:MoE技术的重大突破

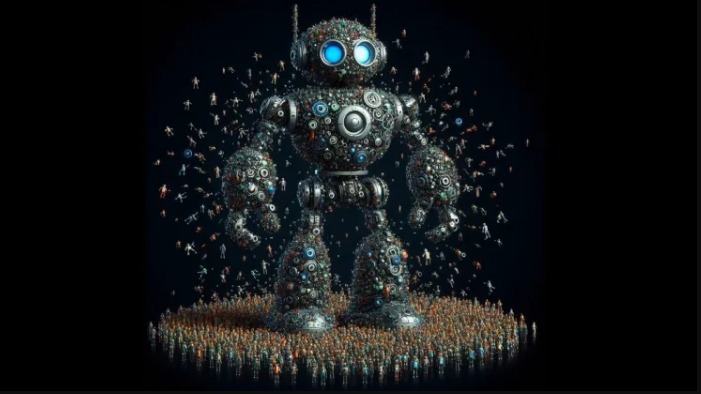

近年来,“专家混合”(Mixture-of-Experts, MoE)技术在大型语言模型(Large Language Models, LLMs)领域崭露头角,其巧妙之处在于,在不额外加重计算负担的前提下,极大地扩展了模型的容量与功能。与传统的全面利用模型资源处理每个输入的方式不同,MoE架构犹如一位智慧的调度者,将任务精准分配给一群专精于特定领域的“小专家”团队,各自发挥所长。这一策略使得大型语言模型即便在参数激增的情况下,依然能够保持高效的推理速度,如Mixtral、DBRX、Grok乃至备受瞩目的GPT-4等模型,均采用了这一先进策略。

然而,MoE技术也面临着挑战,特别是在专家数量的扩展上遭遇了瓶颈。为此,谷歌DeepMind团队提出的“参数高效专家检索”(Parameter Efficient Expert Retrieval, PEER)架构,为MoE技术的未来发展铺设了新的跑道。PEER的独到之处在于,它能够将MoE模型支持的专家数量推向数百万级别,从而在性能与计算资源之间找到了更加精细的平衡点。

大型语言模型的成长,一直以来都是参数增加与性能提升并进的过程。但随着参数的激增,计算与内存的瓶颈问题也日益严重。在传统的Transformer架构中,每个区块的注意力层负责解析输入间的关系,而前馈网络则如同庞大的知识库,占据了大量参数。这种“全面铺开”的方式,导致计算成本随模型规模的扩大而直线上升。

MoE技术的出现,为这场参数竞赛带来了灵活性。它用一群专业的小专家取代了原本庞大的前馈网络,每个专家只专注于一小块领域,由智能的路由器根据输入内容来分配任务。这样,即便专家数量增加,整体计算量也能保持稳定,实现了模型容量的提升而不增加额外负担。

然而,确定MoE的最佳专家数量并非易事,需要综合考虑训练数据量、计算资源等多方面因素。研究表明,适当增加专家的“密度”,即提高专家数量,能够显著提升模型性能,尤其是在模型规模与训练数据量同步增长的情况下。此外,高密度的MoE还能让模型更加灵活地吸收新知识,通过新增专家并适当正则化,来适应不断变化的数据环境。

但现有的MoE方法也有其局限性,特别是在专家数量达到一定规模后,传统的固定路由器设计显得力不从心,难以高效管理庞大的专家团队。

正是在此背景下,DeepMind的PEER架构应运而生。它通过引入学习型索引来替代传统路由器,实现了对海量专家的快速检索与精准激活。对于每个输入,PEER首先通过快速预筛选缩小候选专家范围,然后精准激活最相关的专家,从而保证了处理速度不受专家数量增加的影响。更为巧妙的是,PEER的专家设计极为精简,每个专家仅包含一个隐藏神经元,通过共享机制极大地提升了参数利用效率。同时,借鉴多头注意力机制,PEER实现了对专家能力的全面挖掘与整合。

PEER架构的提出,不仅为MoE技术注入了新的活力,也为大型语言模型的未来发展指明了新方向。无论是作为Transformer模型的增强层,还是直接替代前馈网络,PEER都能以极高的参数效率,实现模型性能的显著提升。同时,它与参数高效微调(PEFT)技术的结合,更使得模型在应对新任务时,能够以最小的代价快速适应与优化。

据论文所述,PEER还有潜力在运行时选择PEFT适配器,为动态地向大型语言模型(LLMs)添加新知识和功能提供了可能。此外,有消息称PEER可能会被用于DeepMind的Gemini 1.5模型中,该模型据称采用了“一种新的混合专家(Mixture-of-Experts, MoE)架构”。

在实际应用中,研究人员已在不同基准测试上验证了PEER的性能,并将其与采用密集前馈层的Transformer模型以及其他MoE架构进行了比较。实验结果表明,PEER模型在性能与计算之间实现了更佳的权衡,在相同的计算预算下达到了更低的困惑度分数。同时,研究人员还发现,增加PEER模型中的专家数量可以进一步降低困惑度,这一发现挑战了以往关于MoE模型在专家数量有限时效率达到顶峰的观点,证明了通过优化检索和路由机制,MoE技术完全有潜力扩展到数百万个专家,从而进一步降低训练和服务超大型语言模型的成本与复杂性。