Hugging Face 发布 SmolLM,紧凑型语言模型挑战行业巨头

Hugging Face 宣布了 SmolLM——一系列全新的紧凑型语言模型,其性能在同类产品中脱颖而出,超越了微软、Meta 及阿里巴巴的 Qwen 等知名产品。这些模型专为个人设备设计,能够在不妥协性能与隐私的前提下,带来前沿的AI体验。

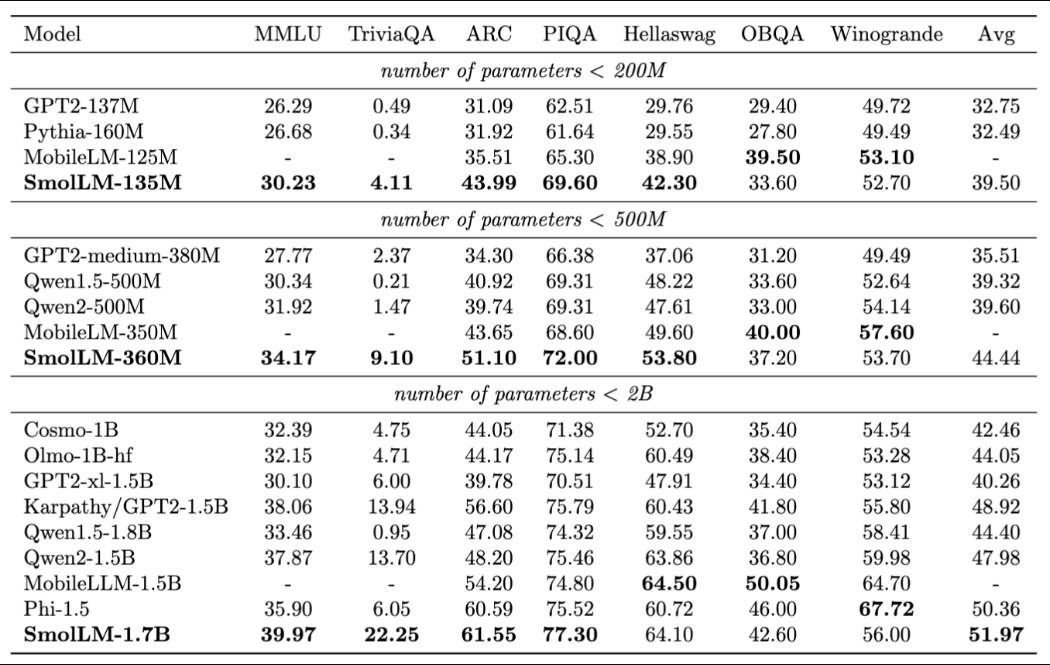

SmolLM 系列精心规划了三种规模,分别是1.35亿、3.6亿和17亿参数版本,旨在灵活适应不同计算资源的需求。尽管体积小巧,但在测试常识推理及世界知识掌握能力的基准中,它们展现出了非凡的实力。

“小而美”的颠覆:SmolLM 如何撼动AI界

Hugging Face 的 SmolLM 项目首席机器学习工程师 Loubna Ben Allal 指出,专为特定任务定制的小型模型同样能大显身手。“并非每个任务都需要庞大的基础模型,正如我们不会用大锤去钉钉子。”她比喻道,“小型模型针对特定任务设计,同样能高效完成任务。”

具体而言,SmolLM-135M 在使用较少训练数据的情况下,性能超越了 Meta 的 MobileLM-125M。而 SmolLM-360M 在所有参数少于5亿的模型中表现卓越,包括 Meta 和 Qwen 的竞品。旗舰型号 SmolLM-1.7B 更是在多个基准测试中击败了微软的 Phi-1.5、Meta 的 MobileLM-1.5B 和 Qwen2-1.5B。

Hugging Face 通过全面开源从数据整理到训练的全过程,彰显了其独特之处,这与其对开源价值和可重复研究的坚持不谋而合。

成功的基石:高质量数据整理

SmolLM 的卓越表现得益于其精心整理的训练数据。这些模型基于 Cosmo-Corpus 构建,该语料库融合了 Cosmopedia v2(合成教科书与故事)、Python-Edu(教育用Python样本)和 FineWeb-Edu(精选教育性网络内容)。

“SmolLM 的出色表现再次证明了数据质量的重要性。”Ben Allal 强调,“我们创新性地结合网络数据与合成数据,精心打造出高质量的训练集,从而构建了目前最优秀的小型模型。”

AI的民主化与隐私保护

SmolLM 的发布对AI的可访问性和隐私保护产生了深远影响。这些模型能够在手机、个人电脑等个人设备上直接运行,无需依赖云计算,从而降低了成本并减少了隐私泄露的风险。

Ben Allal 谈及可访问性时表示:“小型且高效的模型让AI触手可及,为每个人解锁了新的可能性,同时确保了完全的隐私和更低的环境影响。”

Hugging Face 研究团队负责人 Leandro von Werra 则进一步阐述了 SmolLM 的实际意义:“这些紧凑模型为开发者和终端用户开启了一个充满无限可能的新世界。从个性化的自动补全到复杂的用户请求解析,SmolLM 无需昂贵的GPU或云基础设施,即可实现定制化AI应用。这是推动AI更加普及、注重隐私的重要一步。”

SmolLM 的发布标志着AI领域的一个重要转折点。通过提升AI的可访问性和隐私保护,Hugging Face 正面回应了公众对AI环境影响和数据隐私的关切。

随着 SmolLM 模型、数据集及训练代码的公开,全球AI社区和开发者将有机会深入探索、优化并基于这一创新语言模型进行构建,共同推动AI技术的进一步发展。