NVIDIA推出FLEXTRON:革新大型语言模型部署技术

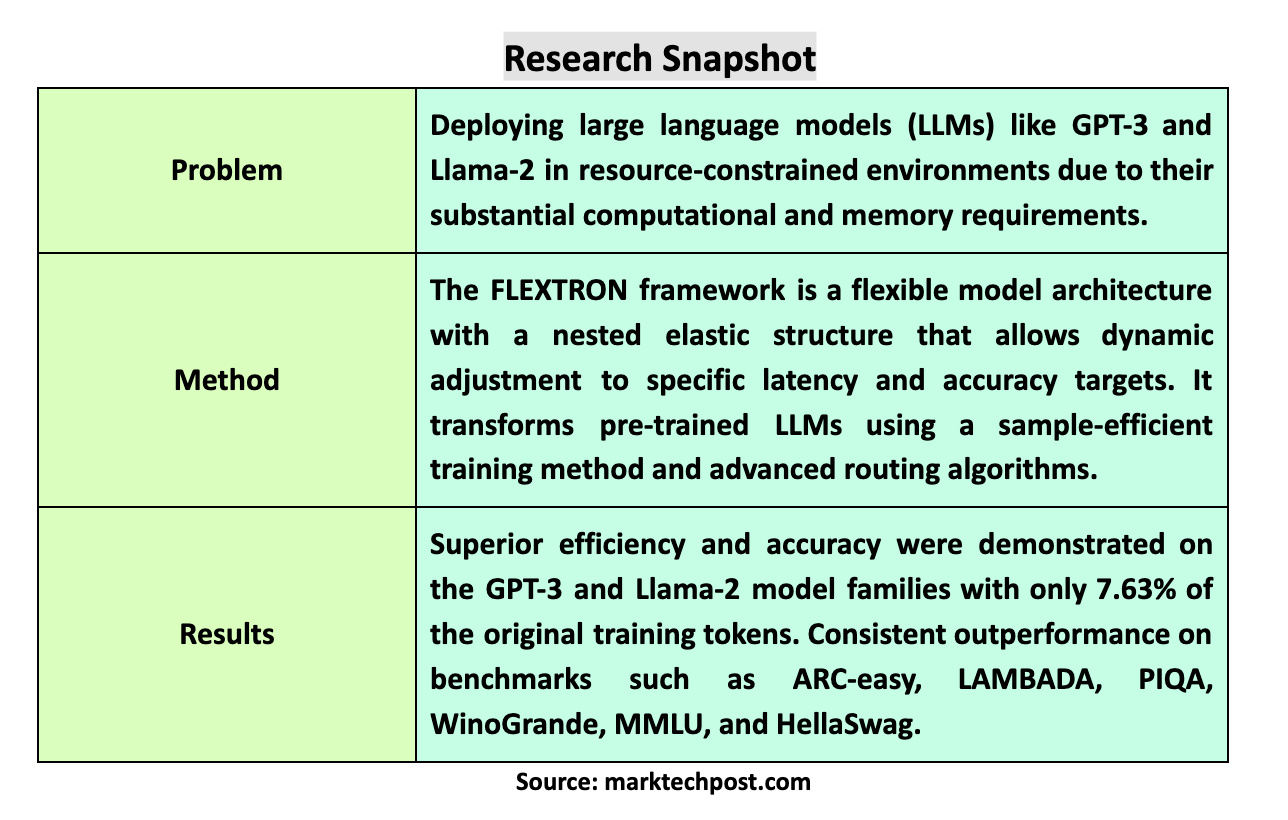

在人工智能领域,大型语言模型(LLMs)如GPT-3和Llama-2以其卓越的语言理解和生成能力引领着技术创新。然而,这些模型巨大的计算资源需求一直是其广泛应用的一大障碍。近日,NVIDIA与德克萨斯大学奥斯汀分校的研究团队宣布了一项重大突破——FLEXTRON框架的推出,这一创新技术有望彻底改变大型语言模型的部署方式。

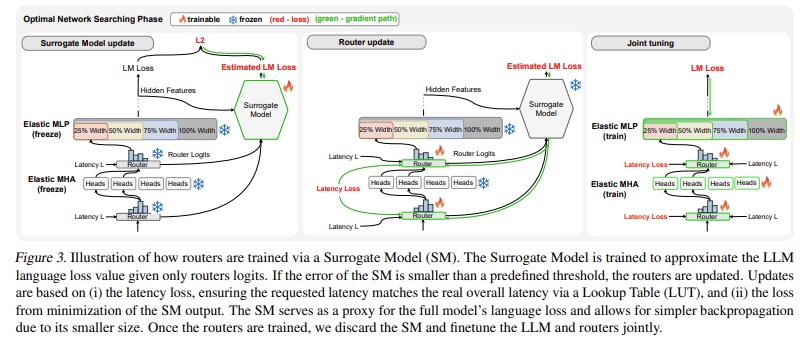

据悉,FLEXTRON是一种全新的灵活模型架构与后训练优化框架,专为解决LLMs在资源受限环境中部署的难题而设计。传统上,为了平衡效率和准确性,研究人员需要训练多个不同规模的模型版本,这一做法不仅耗时费力,还造成了计算资源的极大浪费。而FLEXTRON则通过其独特的嵌套弹性结构设计,实现了模型在推理过程中的动态调整,从而无需额外微调即可适应不同的计算环境和性能要求。

“FLEXTRON的推出是AI技术发展的一个重要里程碑。”NVIDIA相关负责人表示,“它不仅简化了大型语言模型的部署流程,还显著提高了资源使用效率,为AI技术的普及与广泛应用铺平了道路。”

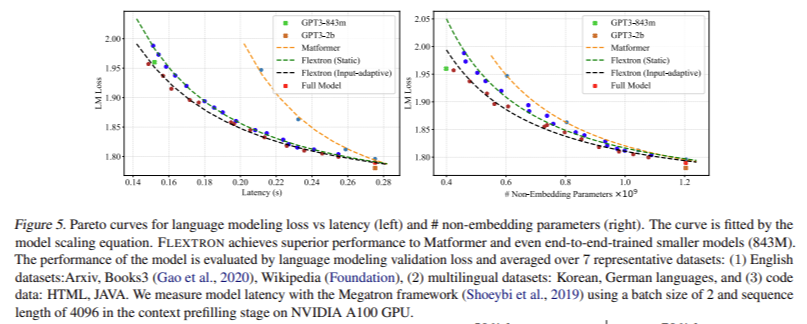

在实验中,FLEXTRON展现了其卓越的性能。据研究团队介绍,该框架在训练过程中仅使用了原始预训练数据的7.63%,却能在多种基准测试中超越其他模型,包括GPT-3和Llama-2系列。这一结果不仅证明了FLEXTRON的高效性,也彰显了其在优化资源使用方面的巨大潜力。

此外,FLEXTRON还引入了弹性多层感知器(MLP)和弹性多头注意力(MHA)层等创新技术,进一步增强了模型的适应性。通过根据输入数据动态调整注意力头的使用,这些技术使得模型在计算资源有限的情况下也能保持高效运行。

德克萨斯大学奥斯汀分校的研究人员表示:“FLEXTRON的成功开发是跨学科合作的典范。我们与NVIDIA的紧密合作,不仅推动了AI技术的进步,也为解决现实世界中的复杂问题提供了新的思路和方法。”

随着FLEXTRON框架的推出,业界对于大型语言模型的未来应用充满了期待。许多专家认为,这一创新技术将极大地促进AI技术在教育、医疗、金融等多个领域的广泛应用,为人类社会带来更加智能、便捷的服务体验。

未来,NVIDIA与德克萨斯大学奥斯汀分校的研究团队将继续深化对FLEXTRON框架的研究与优化,探索其在更多场景下的应用潜力。