苹果开源发布小模型DCLM-7B,性能优于Mistral-7B

随着全球对GPT-4o-mini强大性能的广泛赞誉,苹果公司也积极扩展了其小型语言模型阵容。就在几小时前,苹果参与的语言模型数据竞赛项目(DataComp for Language Models)研究团队,在Hugging Face平台上公布了一系列开放的DCLM(DataComp Language Model)模型,此举引起了业界的广泛关注。

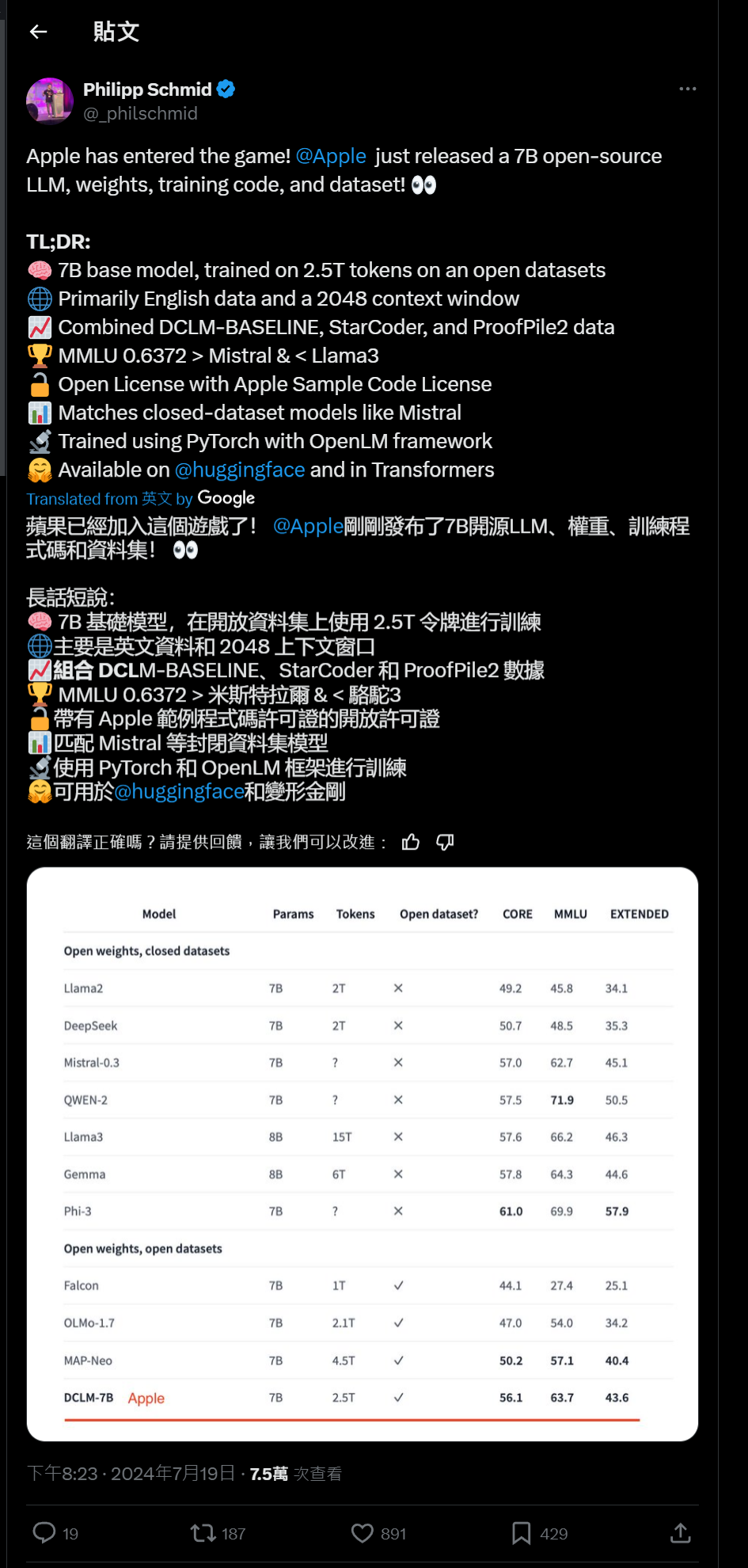

此次发布的DCLM模型包含两大亮点:一款拥有70亿参数,另一款则搭载了14亿参数。两者在基准测试中均展现出非凡实力,尤其是70亿参数的模型,其表现不仅超越了Mistral-7B,还紧追Llama 3与Gemma等业界领先的开放模型。

苹果机器学习团队的Vaishaal Shankar将这些模型誉为“顶尖”的开源之选,尤为值得一提的是,此次开源行动彻底,不仅公开了模型权重和训练代码,还分享了预训练数据集,极大地促进了学术与工业界的交流与发展。

深入剖析Apple DCLM模型,其背后是苹果携手华盛顿大学、特拉维夫大学及丰田研究所等多方力量共同推进的DataComp项目。该项目聚焦于构建高质量数据集,以优化AI模型训练,特别是在多模态领域。项目核心在于通过标准化的模型架构、训练代码、超参数及评估体系,探索最有效的数据策展策略,从而培育出高性能的语言模型。

经过长时间的努力,研究团队发现,基于机器学习模型的自动过滤技术,能够从海量数据中精准筛选出高质量训练素材,成为构建高质量训练集的关键。为了验证这一发现,团队利用DCLM-Baseline数据集,从零开始训练了两个DCLM模型——分别拥有70亿和14亿参数,且专注于英语处理。

特别值得一提的是,那款70亿参数的模型,在OpenLM框架下,基于2.5万亿个标记进行预训练,配备了2K的上下文窗口,并在MMLU基准测试中实现了63.7%的5-shot准确率,相比同类中的佼佼者MAP-Neo,不仅性能提升了6.6个百分点,还大幅减少了40%的计算资源消耗。

更令人振奋的是,该模型在MMLU上的表现已逼近市场上的顶尖开放模型,包括Mistral-7B-v0.3、Llama3 8B、谷歌的Gemma及微软的Phi-3。当研究团队进一步增加训练数据至100B,并借助数据集分解技术将上下文长度扩展至8K时,模型在核心及扩展基准测试中的综合表现更是有了显著提升,尽管MMLU成绩保持稳定。

在最新发布的论文中,研究团队强调:“我们的研究成果凸显了数据集设计对于语言模型训练的重要性,并为后续的数据策展研究奠定了坚实基础。”

与此同时,那款14亿参数的“小而美”模型同样不容小觑,在丰田研究所的协助下,它也在2.6万亿个标记上接受了严格训练,并在MMLU、核心及扩展测试中均展现出了卓越的性能。在5-shot MMLU测试中,该模型以41.9%的得分远超同类竞品,包括Hugging Face的SmolLM 1.7B版本(39.97%),以及Qwen-1.5B和Phi-1.5B等。

目前,这两款模型已分别以苹果的Sample Code License和Apache 2.0许可证发布,后者允许广泛的商业使用、分发及修改。不过,值得注意的是,这些模型目前仍处于研究阶段,其性能可能受到训练数据偏见的影响,并存在产生不当响应的风险。