LazyLLM:提升长文本下大语言模型推理效率的新技术

近年来,大型语言模型(LLM)在技术上取得了显著突破,但在推理过程中,尤其是在处理长文本时的初始响应速度(即首次生成令牌所需时间,TTFT)仍是一大瓶颈。这主要是因为当前的LLM,基于深度且复杂的Transformer结构,在处理长输入时,其计算注意力的成本会随着文本中单词数量的增加而急剧上升,呈现出二次方增长的趋势。例如,在LongBench测试中,拥有70亿参数的Llama 2模型,其TTFT时间竟是后续解码步骤的21倍之多,占据了整个生成时间的近四分之一。因此,如何优化TTFT,成为了提升LLM推理效率的关键课题。

针对这一问题,科研界已尝试多种策略,如修改Transformer架构、优化键值(KV)缓存等,但这些方法要么需要大幅改造模型并重新训练,要么未能有效解决TTFT过长的问题。还有令牌修剪的方法,尽管在分类任务中展现潜力,但直接应用于生成性LLMs时仍需调整。在此背景下,苹果与Meta AI的研究团队提出了一种创新的LazyLLM技术,通过智能选择关键令牌优先处理,有效加速了LLM的预填充过程。

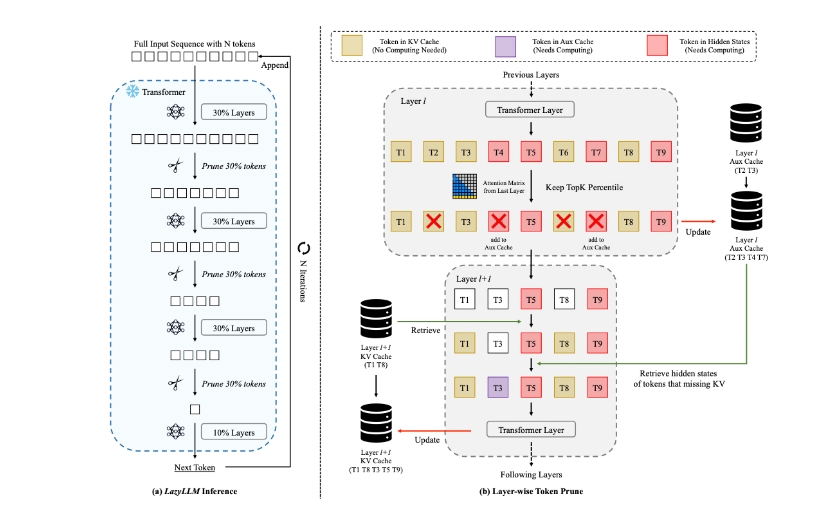

LazyLLM的核心思想在于“懒惰”地处理那些不那么重要的令牌,即先计算并处理对结果影响较大的令牌,而将其他令牌的计算推迟到后续步骤。这一过程中,LazyLLM利用前一层Transformer的注意力分数来评估每个令牌的重要性,并逐步进行修剪。与传统的静态修剪不同,LazyLLM能够在不同的生成阶段动态调整要处理的令牌集合,从而在保证准确性的同时,最大限度地减少计算量。

为了进一步优化解码过程,LazyLLM还引入了辅助缓存(Aux Cache)机制。这一机制负责存储被暂时修剪的令牌的隐藏状态,以便在需要时能够迅速恢复,避免重复计算。这样一来,模型在解码时就能更加高效地利用已有资源,进一步提升了整体推理速度。

实验结果显示,LazyLLM在多种语言任务中均表现出色,不仅显著缩短了TTFT(如Llama 2提升2.89倍,XGen提升4.77倍),而且保持了与基线模型相近的准确率。这种在速度与准确性之间的良好平衡,使得LazyLLM成为优化LLM推理的一个有力工具。

总而言之,LazyLLM通过其独特的逐步令牌修剪和辅助缓存机制,为大型语言模型在长文本处理中的推理效率提升提供了新思路。该技术无需对模型进行大规模修改或重新训练,即可实现显著的性能提升,满足了当前对于更快、更高效的LLM应用的迫切需求。